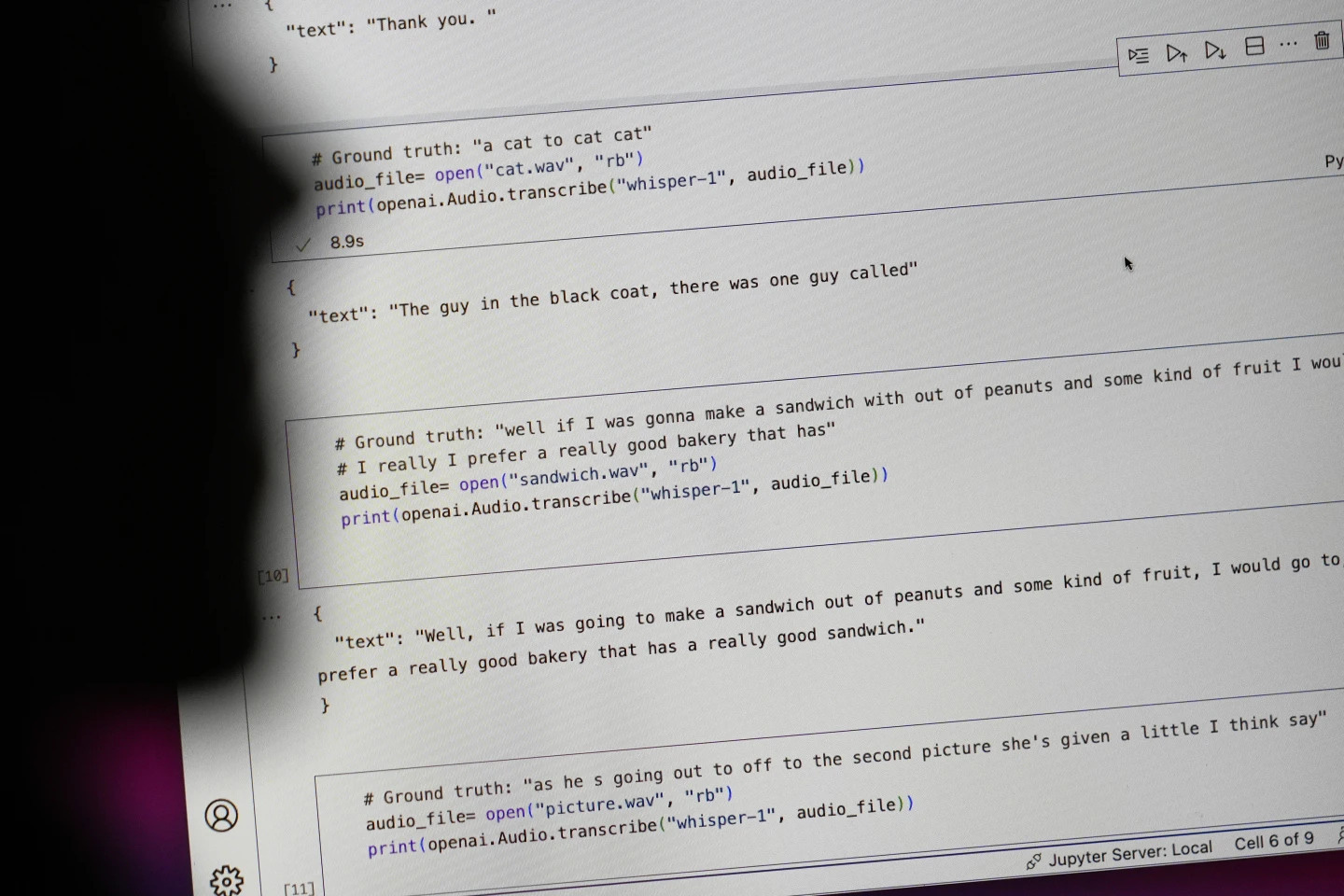

Le géant technologique OpenAI a vanté les mérites de son outil de transcription vocale, Whisper, comme une IA dotée d'une « précision et d'une robustesse quasi humaines ». Mais Whisper présentait un défaut majeur : il générait des textes et des phrases totalement erronés.

Certains textes générés par l'IA – qualifiés d'« hallucinations » – peuvent contenir des propos racistes, un langage violent et même des descriptions de traitements médicaux imaginaires. – Photo : AP

D'après l'AP, certains textes générés par l'IA sont qualifiés d'« hallucinatoires », selon des experts, et comprennent notamment des propos racistes, un langage violent et même des traitements médicaux imaginaires.

Taux élevé d’« illusion » dans les textes générés par l’IA

Les experts sont particulièrement inquiets car Whisper est largement utilisé dans de nombreux secteurs d'activité à travers le monde pour traduire et transcrire des entretiens, générer du texte pour des technologies grand public populaires et créer des sous-titres pour les vidéos.

Plus inquiétant encore, de nombreux centres médicaux utilisent Whisper pour transférer les consultations entre médecins et patients, bien qu'OpenAI ait averti que cet outil ne devrait pas être utilisé dans les zones « à haut risque ».

Il est difficile de déterminer l'ampleur exacte du problème, mais les chercheurs et les ingénieurs affirment qu'ils rencontrent régulièrement des « hallucinations » liées à Whisper dans le cadre de leur travail.

Un chercheur de l'Université du Michigan a déclaré avoir trouvé des « hallucinations » dans huit transcriptions audio sur dix qu'il a examinées. Un ingénieur informatique a constaté la présence d'« hallucinations » dans environ la moitié des transcriptions de plus de 100 heures d'audio qu'il a analysées. Un autre développeur a affirmé avoir trouvé des « hallucinations » dans la quasi-totalité des 26 000 enregistrements qu'il a réalisés avec Whisper.

Le problème persiste même avec des extraits audio courts et clairement enregistrés. Une étude récente menée par des informaticiens a recensé 187 « illusions » dans plus de 13 000 extraits audio de bonne qualité analysés. Selon les chercheurs, cette tendance pourrait entraîner des dizaines de milliers de transcriptions erronées dans des millions d’enregistrements.

De telles erreurs peuvent avoir des « conséquences très graves », notamment en milieu hospitalier, selon Alondra Nelson, qui a dirigé le Bureau des sciences et des technologies de la Maison-Blanche sous l'administration Biden jusqu'à l'année dernière.

« Personne ne souhaite un mauvais diagnostic », a déclaré Nelson, aujourd'hui professeur à l'Institute for Advanced Study de Princeton, dans le New Jersey. « Il faut un critère plus exigeant. »

Whisper est également utilisé pour créer des sous-titres destinés aux personnes sourdes et malentendantes, une population particulièrement exposée aux risques d'erreurs de traduction. En effet, ces personnes n'ont aucun moyen de repérer les passages inventés « dissimulés dans le reste du texte », explique Christian Vogler, sourd et directeur du programme d'accessibilité technologique de l'université Gallaudet.

OpenAI est sollicitée pour résoudre le problème

La fréquence de ces « hallucinations » a incité des experts, des militants et d'anciens employés d'OpenAI à demander au gouvernement fédéral d'envisager une réglementation de l'IA. À tout le moins, OpenAI doit remédier à cette lacune.

« Ce problème est soluble si l’entreprise est disposée à en faire une priorité », a déclaré William Saunders, ingénieur de recherche à San Francisco, qui a quitté OpenAI en février en raison de ses inquiétudes quant à la direction prise par l’entreprise.

« Ce serait problématique si, une fois la technologie disponible, les gens prenaient tellement confiance en ses capacités qu'ils l'intégraient à tous les autres systèmes. » Un porte-parole d'OpenAI a déclaré que l'entreprise travaillait constamment à atténuer ces « illusions » et appréciait les découvertes des chercheurs, ajoutant qu'OpenAI prenait en compte les retours d'information dans les mises à jour de ses modèles.

Alors que la plupart des développeurs supposent que les outils de synthèse vocale peuvent commettre des fautes de frappe ou d'autres erreurs, les ingénieurs et les chercheurs affirment n'avoir jamais vu d'outil de synthèse vocale basé sur l'IA qui « hallucine » autant que Whisper.

Prix Nobel de physique 2024 : Les personnes qui ont posé les fondements de l’IA

Prix Nobel de physique 2024 : Les personnes qui ont posé les fondements de l’IASource : https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Photo] Déblaiement de collines pour faciliter la circulation sur la route 14E, touchée par des glissements de terrain.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[Vidéo] Les monuments de Hué rouvrent leurs portes aux visiteurs](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Comment (0)