Lors d'un récent discours à Washington (États-Unis), M. Smith a déclaré que sa principale préoccupation concernant l'IA concernait le deepfake, une technologie qui crée des images et des vidéos réalistes. Il a appelé à des mesures pour aider les gens à distinguer les vraies photos et vidéos des fausses.

« Nous devons nous attaquer aux problèmes liés aux deepfakes », a déclaré le président de Microsoft. « Nous devons prendre des mesures pour lutter contre l'utilisation de l'IA pour modifier des contenus légitimes afin de tromper ou d'induire en erreur les utilisateurs. »

Il a également appelé à l'octroi de licences pour les formes les plus importantes d'IA, assorties d'« obligations de protection de la sûreté, de la sécurité physique, de la cybersécurité et de la sécurité nationale ». Nous avons besoin de nouveaux contrôles à l'exportation, au moins plus stricts que ceux existants, afin de garantir que les modèles d'IA ne soient pas volés ou utilisés de manière contraire aux contrôles à l'exportation, a-t-il déclaré.

La réglementation de l'IA est un sujet brûlant depuis le lancement public du chatbot ChatGPT d'OpenAI. Les législateurs de Washington se demandent comment introduire une réglementation de l'IA, alors que les entreprises, grandes et petites, se précipitent pour commercialiser l'IA.

La semaine dernière, Sam Altman, PDG d'OpenAI, a déclaré au Sénat américain que l'utilisation de l'IA pour perturber l'intégrité des élections était une « grande préoccupation ». Il a également soutenu que l'IA devait être réglementée, appelant à une coopération mondiale dans ce domaine.

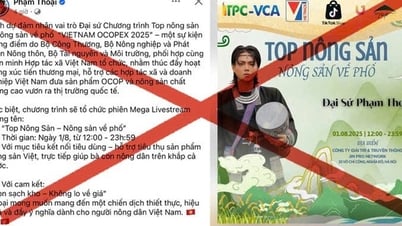

Smith a soutenu que les citoyens doivent être tenus responsables de tout problème causé par l'IA. Il a exhorté les législateurs à mettre en place des « freins de sécurité » sur les technologies d'IA utilisées pour gérer les réseaux électriques, l'approvisionnement en eau et autres infrastructures critiques, afin que les humains puissent en prendre le contrôle. Il a également évoqué un système de type « Know Your Customer » (KYC) permettant aux développeurs de modèles d'IA performants de savoir comment leur technologie est utilisée et d'informer le public sur les contenus générés par l'IA utilisés pour identifier les fausses vidéos.

Plus tôt cette semaine, une image générée par l'IA d'une explosion près du Pentagone est devenue virale sur les réseaux sociaux et a été partagée par de nombreux comptes « cochés en bleu ». La source de l'image est inconnue, et bien que le ministère américain de la Défense ait confirmé qu'il s'agissait d'un faux, elle a tout de même provoqué une chute importante de la bourse en quelques minutes.

OSINTdefender , un compte Twitter coché bleu comptant plus de 336 000 abonnés, était l'un des sites ayant partagé la photo. Le propriétaire du compte s'est ensuite excusé d'avoir diffusé de fausses informations, affirmant qu'il s'agissait d'un exemple de la façon dont « des images comme celle-ci peuvent être utilisées pour manipuler l'information avec facilité ».

C'est également l'une des nombreuses images d'IA populaires de ces dernières semaines, notamment le pape portant un élégant manteau blanc, la photo en noir et blanc qui a remporté le Sony World Photography Award et l'ancien président Donald Trump arrêté par la police.

(Selon CNN, The Guardian)

Source

Comment (0)