Nvidia était autrefois connue comme un fabricant de puces utilisées dans l'industrie du jeu vidéo, mais s'est recentrée ces dernières années sur le marché des centres de données.

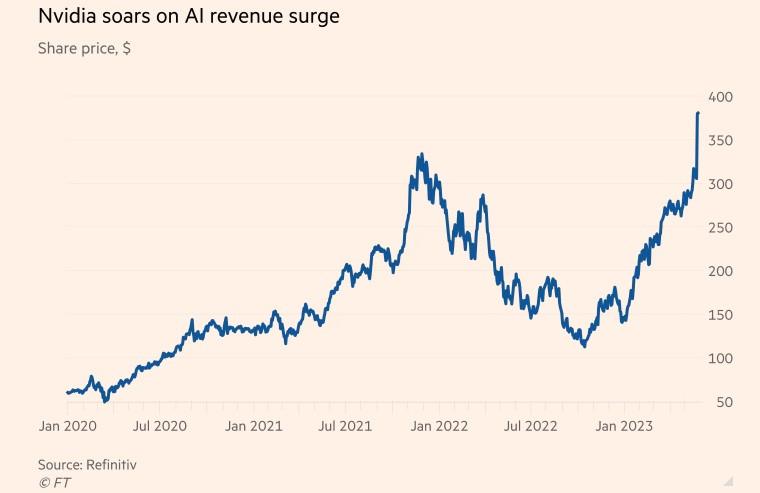

L'entreprise américaine de semi-conducteurs a connu une croissance fulgurante pendant la pandémie, portée par l'explosion de la demande en jeux vidéo et applications cloud, ainsi que par l'engouement mondial pour le minage de cryptomonnaies. À la fin de l'exercice fiscal, clos le 29 janvier, le secteur des puces pour centres de données représentait plus de 50 % de son chiffre d'affaires.

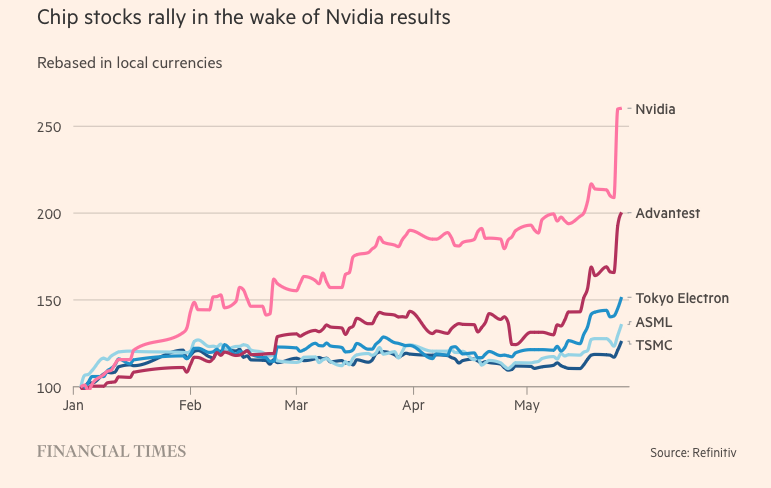

Parallèlement, le chatbot ChatGPT, extrêmement populaire, a propulsé la génération par intelligence artificielle (IA) à un niveau supérieur cette année. Cette technologie exploite d'immenses quantités de données disponibles pour créer du contenu inédit sur des sujets variés, allant de la poésie à la programmation informatique.

Microsoft et Alphabet, deux géants de la technologie et acteurs majeurs de l'intelligence artificielle, sont convaincus que les technologies génératives peuvent transformer le monde du travail. Tous deux se sont lancés dans une course effrénée pour intégrer l'IA aux moteurs de recherche et aux logiciels bureautiques, avec l'ambition de dominer le secteur.

Goldman Sachs estime que les investissements américains dans l'IA pourraient représenter environ 1 % de la production économique du pays d'ici 2030.

Les supercalculateurs utilisés pour le traitement des données et la génération d'IA s'appuient sur des unités de traitement graphique (GPU). Conçues pour gérer les tâches de calcul spécifiques à l'IA, les GPU sont nettement plus performantes que les unités centrales de traitement d'autres fabricants de puces comme Intel. Par exemple, ChatGPT d'OpenAI utilise des milliers de GPU Nvidia.

Parallèlement, Nvidia détient environ 80 % des parts de marché des GPU. Ses principaux concurrents sont Advanced Micro Devices et les puces d'IA internes de sociétés technologiques telles qu'Amazon, Google et Meta Platforms.

Les secrets pour atteindre la transcendance

Le succès fulgurant de cette entreprise est dû au H100, une puce basée sur la nouvelle architecture « Hopper » de Nvidia, nommée en hommage à l'icône américaine de la programmation Grace Hopper. L'essor de l'intelligence artificielle a fait du H100 le produit le plus recherché de la Silicon Valley.

Ces puces massives, utilisées dans les centres de données, contiennent 80 milliards de transistors, soit cinq fois plus que les puces en silicium des derniers iPhone. Bien que deux fois plus chère que sa prédécesseure, la puce A100 (sortie en 2020), la H100 offre, selon ses utilisateurs, des performances trois fois supérieures.

Le H100 s'avère particulièrement populaire auprès des entreprises « Big Tech » comme Microsoft et Amazon, qui construisent des centres de données entiers axés sur les charges de travail d'IA, et des startups d'IA de nouvelle génération comme OpenAI, Anthropic, Stability AI et Inflection AI, car il promet des performances supérieures, ce qui peut accélérer les lancements de produits ou réduire les coûts de formation au fil du temps.

« Il s'agit de l'une des ressources techniques les plus rares actuellement », a déclaré Brannin McBee, directeur de la stratégie et fondateur de CoreWeave, une startup cloud basée sur l'IA et l'une des premières entreprises à avoir reçu une livraison de H100 plus tôt cette année.

D'autres clients n'ont pas eu la même chance que CoreWeave et ont dû attendre jusqu'à six mois pour recevoir le produit nécessaire à l'entraînement de leurs vastes ensembles de données. De nombreuses start-ups spécialisées en IA craignent que Nvidia ne soit pas en mesure de répondre à la demande du marché.

Elon Musk a également commandé des milliers de puces Nvidia pour sa start-up spécialisée dans l'IA, déclarant que « les GPU sont plus difficiles à trouver que les médicaments en ce moment ».

« Le coût des ordinateurs a explosé. Le montant minimum requis pour le matériel serveur utilisé dans le développement d'une IA innovante a atteint 250 millions de dollars », a déclaré le PDG de Tesla.

Bien que le H100 soit arrivé à point nommé, la percée de Nvidia dans le domaine de l'IA remonte à deux décennies plus tôt, grâce à l'innovation logicielle plutôt qu'à l'innovation matérielle. En 2006, l'entreprise a lancé le logiciel CUDA, qui exploitait les GPU pour accélérer des tâches allant au-delà du simple traitement graphique.

« Nvidia a su anticiper l’avenir avant les autres et s’est tournée vers le développement de GPU programmables. L’entreprise a repéré l’opportunité, a investi massivement et a constamment surpassé ses concurrents », a déclaré Nathan Benaich, associé chez Air Street Capital et investisseur dans des startups spécialisées en IA.

(Selon Reuters, FT)

Source

![[Photo] Cérémonie de clôture de la 10e session de la 15e Assemblée nationale](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F11%2F1765448959967_image-1437-jpg.webp&w=3840&q=75)

![[Photo] Le Premier ministre Pham Minh Chinh s'entretient par téléphone avec le PDG de la société russe Rosatom.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F11%2F1765464552365_dsc-5295-jpg.webp&w=3840&q=75)

![[OFFICIEL] LE GROUPE MISA ANNONCE SON POSITIONNEMENT DE MARQUE PIONNIER DANS LA CONSTRUCTION D'IA AGENTE POUR LES ENTREPRISES, LES MÉNAGES ET LE GOUVERNEMENT](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/11/1765444754256_agentic-ai_postfb-scaled.png)

Comment (0)