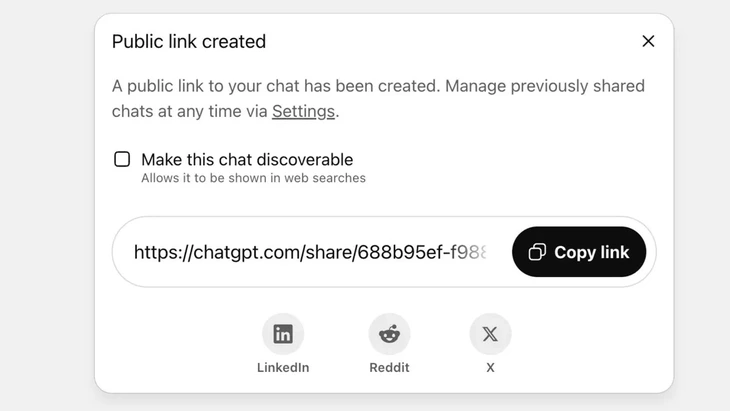

Fonctionnalité permettant de partager des conversations via un lien public sur ChatGPT - Photo : Techradar

ChatGPT reçoit désormais plus de 2,5 milliards de requêtes par jour de la part d'utilisateurs du monde entier, témoignant de la popularité croissante de ce chatbot.

Cependant, cet outil se heurte à une forte opposition de la part des utilisateurs, car la fonction de « partage » a entraîné la fuite d'informations sensibles de milliers de conversations vers Google et certains moteurs de recherche sur Internet.

Risque de sécurité élevé

M. Vu Ngoc Son - chef du département technologique de la National Cyber Security Association (NCA) - a estimé que l'incident ci-dessus démontre un niveau élevé de risque de sécurité pour les utilisateurs de ChatGPT.

« L’incident décrit ci-dessus n’est pas nécessairement dû à un défaut technique, car l’utilisateur a pris l’initiative de cliquer sur le bouton de partage. Cependant, on peut affirmer que le problème réside dans la conception du chatbot IA, qui a semé la confusion chez les utilisateurs et dont les avertissements concernant le risque de fuite de données personnelles en cas de partage sont insuffisants », a analysé M. Vu Ngoc Son.

Sur ChatGPT, cette fonctionnalité est mise en œuvre une fois que l'utilisateur a choisi de partager la conversation via un lien public ; le contenu sera stocké sur le serveur d'OpenAI en tant que site web public (chatgpt.com/share/...), sans qu'aucun identifiant ni mot de passe ne soit requis pour y accéder.

Les robots d'exploration de Google analysent et indexent automatiquement ces pages, ce qui les fait apparaître dans les résultats de recherche, y compris les textes sensibles, les images ou les données de chat.

De nombreux utilisateurs ignoraient le risque, croyant partager la conversation avec des amis ou des contacts. Cela a entraîné la divulgation de milliers de conversations, contenant parfois des informations personnelles sensibles.

Bien qu'OpenAI ait rapidement supprimé cette fonctionnalité fin juillet 2025 suite aux protestations de la communauté, la coordination avec Google pour la suppression des anciens index a tout de même pris du temps. Compte tenu notamment de la complexité du système de stockage, qui inclut les serveurs de cache de Google, cette opération ne peut être réalisée rapidement.

Ne considérez pas les chatbots IA comme une « boîte noire de sécurité ».

Vu Ngoc Son, expert en sécurité des données et responsable technique de l'Association nationale de cybersécurité (NCA) - Photo : CHI HIEU

La fuite de milliers de journaux de conversation peut présenter des risques pour les utilisateurs, tels que la révélation de secrets personnels et professionnels, une atteinte à la réputation, des risques financiers, voire des risques pour la sécurité liés à la divulgation d'adresses personnelles.

« Les chatbots dotés d’IA sont utiles, mais ne constituent pas une “boîte noire”, car les données partagées peuvent exister indéfiniment sur le web si elles ne sont pas contrôlées. »

Cet incident est assurément une leçon pour les fournisseurs comme pour les utilisateurs. Les autres fournisseurs de services d'IA peuvent tirer des enseignements de cette expérience et concevoir des fonctionnalités dotées d'avertissements plus clairs et plus transparents.

« Dans le même temps, les utilisateurs doivent également limiter de manière proactive la publication incontrôlée d'informations personnelles ou permettant d'identifier une personne sur les plateformes d'IA », a recommandé l'expert en sécurité Vu Ngoc Son.

D'après les experts en sécurité des données, cet incident souligne la nécessité d'un cadre juridique et de normes de cybersécurité pour l'IA. Les fournisseurs et développeurs d'IA doivent également concevoir des systèmes garantissant la sécurité et prévenant les risques de fuites de données, notamment : les fuites liées à des vulnérabilités importantes ; les failles logicielles pouvant entraîner des attaques de bases de données ; et un contrôle insuffisant conduisant à des manipulations et à des abus, comme l'utilisation de réponses erronées ou déformées.

Les utilisateurs doivent également contrôler le partage de leurs informations personnelles avec l'IA et éviter de divulguer des informations sensibles. En cas de nécessité, il est conseillé d'utiliser le mode anonyme ou de chiffrer activement les informations afin d'empêcher que les données ne soient directement associées à des personnes spécifiques.

Source : https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Photo] « Cimetière de navires » dans la baie de Xuan Dai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Vidéo] Les monuments de Hué rouvrent leurs portes aux visiteurs](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Comment (0)