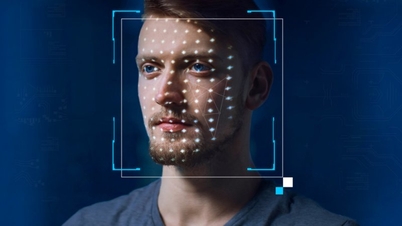

Jejaring sosial X terpaksa memblokir pencarian untuk Taylor Swift setelah gambar pornografi deepfake penyanyi tersebut viral. Saat mencari Taylor Swift di platform X, pengguna akan melihat pesan kesalahan dan permintaan untuk memuat ulang halaman. Joe Benarroch – Direktur Operasional Bisnis X – mengatakan bahwa ini merupakan tindakan awal dan dilakukan dengan hati-hati.

Foto-foto porno Taylor Swift yang dihasilkan AI mulai beredar di X pada 24 Januari, mendorong penggemar penyanyi tersebut untuk mengunggah serangkaian foto asli sang bintang untuk "menenggelamkan" deepfake tersebut. Mereka juga meminta X untuk mengambil tindakan lebih tegas dengan menghapus foto-foto tersebut dan melaporkan akun-akun yang membagikan foto palsu. Slogan "lindungi Taylor Swift" juga menjadi tren utama di platform tersebut.

Sehari kemudian, akun-akun yang dilaporkan ditangguhkan atau dibatasi, tetapi masih mudah untuk menemukan pornografi AI di X.

Dalam sebuah pernyataan akhir pekan lalu, X menyatakan bahwa mereka melarang pembagian gambar vulgar tanpa izin dari subjek dan memiliki kebijakan tanpa toleransi terhadap konten semacam itu. Pernyataan tersebut tidak menyebutkan nama Swift.

"Tim kami secara aktif menghapus semua gambar yang teridentifikasi dan mengambil tindakan yang tepat terhadap akun-akun yang mengunggahnya. Kami akan memantau situasi secara ketat untuk memastikan pelanggaran lebih lanjut segera ditangani dan konten tersebut dihapus," ujar X.

Kemajuan dalam AI generatif telah mempermudah pemalsuan gambar pornografi orang lain. Dengan X, setelah berada di bawah kendali Elon Musk pada tahun 2022, banyak peraturan sensor telah dilonggarkan, sementara ia telah memberhentikan ribuan karyawan untuk menstabilkan keuangannya.

Menurut NBC News, tidak jelas dari mana asal gambar deepfake Taylor Swift, tetapi gambar-gambar tersebut diberi tanda air yang menunjukkan bahwa gambar-gambar tersebut berasal dari situs web yang dikenal menyebarkan gambar-gambar porno palsu para selebritas. Situs web tersebut juga memiliki bagian khusus untuk deepfake AI. Foto-foto palsu Swift tersebut telah dilihat lebih dari 27 juta kali dan disukai lebih dari 260.000 kali setelah 19 jam diunggah.

Menyusul insiden tersebut, CEO Microsoft Satya Nadella menyerukan agar lebih banyak aturan diterapkan untuk mengatur AI. Dalam wawancara dengan NBC News, ia berpendapat bahwa kita memiliki tanggung jawab untuk memantau teknologi yang sedang berkembang ini agar lebih banyak konten yang aman dapat diproduksi.

Menanggapi pertanyaan tentang deepfake Swift, CEO Microsoft tersebut berkata: "Ya, kita harus bertindak. Saya rasa kita semua diuntungkan dari dunia daring yang aman. Saya rasa tidak ada yang menginginkan dunia daring yang sepenuhnya tidak aman, baik bagi pembuat konten maupun konsumen konten. Jadi, saya rasa kita perlu bertindak cepat terkait masalah ini."

Menurut 404 Media, sebuah grup obrolan Telegram mengklaim telah menggunakan alat Designer buatan Microsoft yang menghasilkan AI untuk memalsukan foto Taylor. Nadella tidak berkomentar langsung mengenai informasi 404 Media, tetapi dalam pernyataan yang dikirimkan ke situs berita tersebut, Microsoft menyatakan bahwa mereka sedang menyelidiki laporan tersebut dan akan mengambil tindakan yang sesuai.

Pemerintahan Presiden AS Joe Biden menyebut penyebaran deepfake pornografi Taylor Swift "mengkhawatirkan" dan meminta perusahaan media sosial untuk mengkaji "peran vital" mereka dalam menegakkan peraturan guna mencegah penyebaran informasi palsu dan gambar sensitif tanpa persetujuan.

Pada bulan Oktober 2023, Presiden Biden menandatangani perintah eksekutif tentang AI yang berfokus pada pengaturan teknologi baru dan risikonya.

(Menurut The Hill, WSJ)

[iklan_2]

Sumber

![[Foto] Warga Da Nang "berburu foto" ombak besar di muara Sungai Han](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/21/1761043632309_ndo_br_11-jpg.webp)

![[Foto] Perdana Menteri Pham Minh Chinh bertemu dengan Ketua Majelis Nasional Hongaria Kover Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760970413415_dsc-8111-jpg.webp)

![[Foto] Perdana Menteri Pham Minh Chinh menerima Bapak Yamamoto Ichita, Gubernur Provinsi Gunma (Jepang)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/21/1761032833411_dsc-8867-jpg.webp)

Komentar (0)