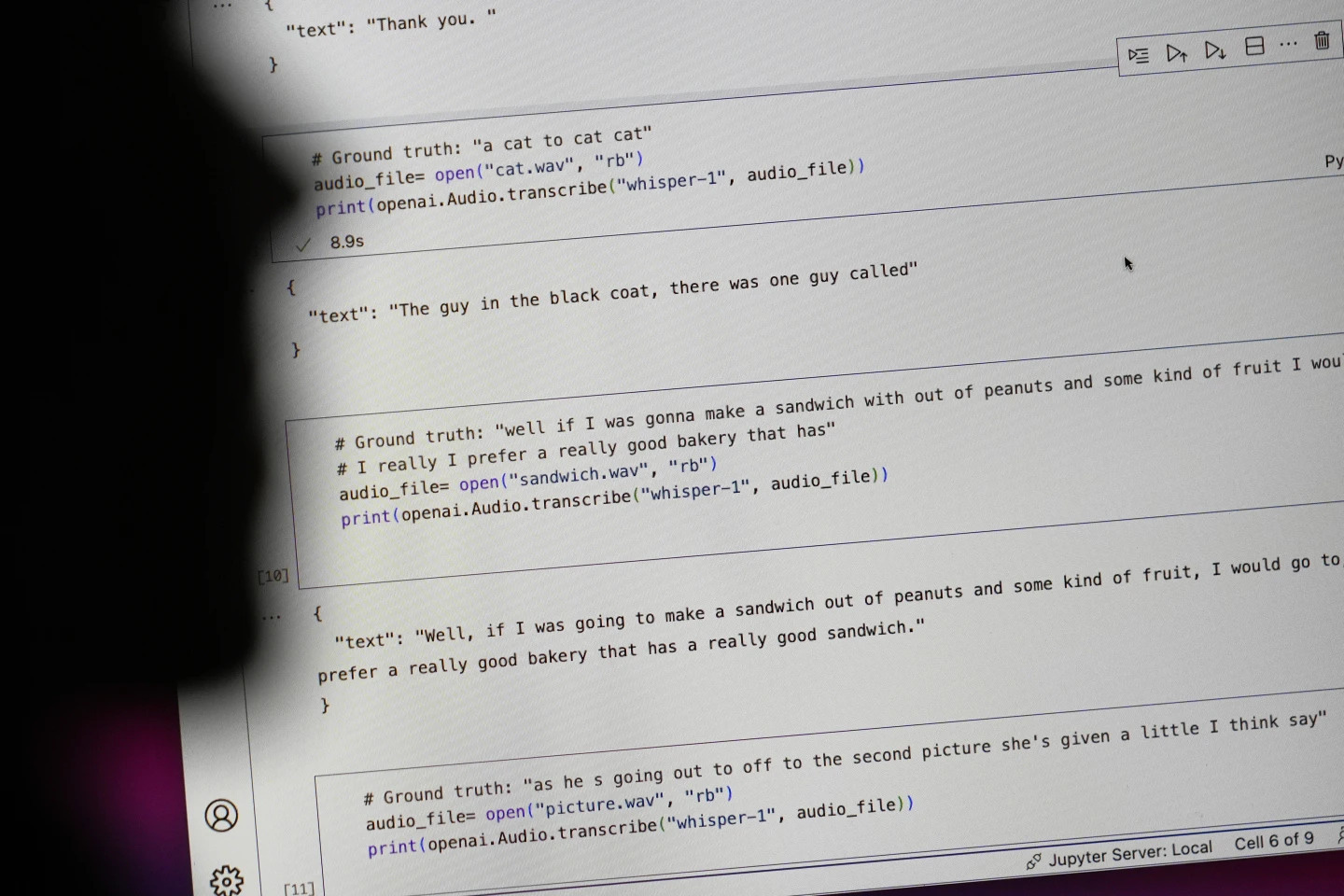

Gigant technologiczny OpenAI zachwalał swoje narzędzie do zamiany mowy na tekst, Whisper, jako sztuczną inteligencję o „dokładności i solidności dorównującej człowiekowi”. Jednak Whisper miał jedną zasadniczą wadę: generował tekst i zdania, które były całkowicie fałszywe.

Część tekstów generowanych przez sztuczną inteligencję – zwanych „halucynacjami” – może zawierać komentarze rasistowskie, wulgarny język, a nawet wyimaginowane metody leczenia – Zdjęcie: AP

Jak twierdzą eksperci, według AP, część tekstów generowanych przez sztuczną inteligencję ma charakter „halucynacyjny” i zawiera komentarze rasistowskie, wulgaryzmy, a nawet wyimaginowane metody leczenia.

Wysoki wskaźnik „złudzeń” w tekstach generowanych przez sztuczną inteligencję

Eksperci są szczególnie zaniepokojeni, ponieważ Whisper jest powszechnie używany w wielu branżach na całym świecie do tłumaczenia i transkrypcji wywiadów, generowania tekstu w popularnych technologiach konsumenckich i tworzenia napisów do filmów.

Co bardziej niepokojące, wiele ośrodków medycznych korzysta z Whisper do przekazywania konsultacji między lekarzami i pacjentami, chociaż OpenAI ostrzega, że narzędzia tego nie należy używać w obszarach „wysokiego ryzyka”.

Dokładna skala problemu jest trudna do określenia, jednak naukowcy i inżynierowie twierdzą, że w swojej pracy regularnie spotykają się z „halucynacjami” powodowanymi przez Whisper.

Badacz z Uniwersytetu Michigan stwierdził, że znalazł „halucynacje” w ośmiu na dziesięć przeanalizowanych przez siebie transkrypcji audio. Inżynier komputerowy stwierdził „halucynacje” w około połowie transkrypcji z ponad 100 godzin nagrań audio, które przeanalizował. Inny programista stwierdził, że znalazł „halucynacje” w prawie wszystkich z 26 000 nagrań, które stworzył za pomocą Whisper.

Problem utrzymuje się nawet w przypadku krótkich, wyraźnie nagranych próbek audio. Niedawne badanie przeprowadzone przez informatyków wykazało 187 „złudzeń” w ponad 13 000 czystych klipów audio, które przebadali. Ta tendencja doprowadziłaby do dziesiątek tysięcy fałszywych transkrypcji w milionach nagrań, twierdzą naukowcy.

Jak twierdzi Alondra Nelson, która do ubiegłego roku kierowała Biurem Nauki i Technologii Białego Domu w administracji Bidena, takie błędy mogą mieć „bardzo poważne konsekwencje”, zwłaszcza w warunkach szpitalnych.

„Nikt nie chce błędnej diagnozy” – powiedział Nelson, obecnie profesor w Institute for Advanced Study w Princeton w stanie New Jersey. „Potrzebny jest wyższy standard”.

Whisper jest również wykorzystywany do tworzenia napisów dla osób głuchych i niedosłyszących – grupy szczególnie narażonej na błędy w tłumaczeniach. Dzieje się tak, ponieważ osoby głuche i niedosłyszące nie mają możliwości zidentyfikowania sfabrykowanych fragmentów „ukrytych w całym tekście”, mówi Christian Vogler, głuchy i dyrektor Programu Dostępności Technologii na Uniwersytecie Gallaudet.

Rozwiązaniem problemu zajmuje się OpenAI

Powszechność takich „halucynacji” skłoniła ekspertów, rzeczników i byłych pracowników OpenAI do apelu do rządu federalnego o rozważenie wprowadzenia regulacji dotyczących sztucznej inteligencji. OpenAI musi co najmniej usunąć tę wadę.

„Ten problem da się rozwiązać, jeśli firma będzie skłonna nadać mu priorytet” – powiedział William Saunders, inżynier ds. badań z San Francisco, który opuścił OpenAI w lutym z powodu obaw dotyczących kierunku rozwoju firmy.

„Byłoby to problemem, gdyby po udostępnieniu tego rozwiązania ludzie byli tak pewni jego możliwości, że zintegrowaliby je ze wszystkimi innymi systemami”. Rzecznik OpenAI powiedział, że firma stale pracuje nad sposobami łagodzenia tych „złudzeń” i docenia odkrycia badaczy, dodając, że OpenAI uwzględnia informacje zwrotne w aktualizacjach modeli.

Podczas gdy większość programistów zakłada, że narzędzia do zamiany tekstu na mowę mogą popełniać literówki i inne błędy, inżynierowie i badacze twierdzą, że nigdy nie widzieli narzędzia do zamiany tekstu na mowę opartego na sztucznej inteligencji, które „wywoływałoby halucynacje” w takim stopniu jak Whisper.

Nagroda Nobla w dziedzinie fizyki 2024: Ludzie, którzy stworzyli podwaliny sztucznej inteligencji

Nagroda Nobla w dziedzinie fizyki 2024: Ludzie, którzy stworzyli podwaliny sztucznej inteligencjiSource: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Zdjęcie] Premier Pham Minh Chinh przyjmuje laotańskiego ministra pracy i opieki społecznej Phosay Sayasone](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/11/1762872028311_dsc-2246-jpg.webp)

![Przejście Dong Nai OCOP: [Artykuł 3] Powiązanie turystyki z konsumpcją produktów OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Komentarz (0)