|

Компания Anthropic только что обновила свою политику. Фото: GK Images . |

28 августа компания Anthropic, занимающаяся разработкой технологий искусственного интеллекта, объявила о запуске обновления своих Условий обслуживания пользователей и Политики конфиденциальности. Теперь пользователи могут разрешить использование своих данных для улучшения Claude и усиления защиты от таких злоупотреблений, как мошенничество и мошенничество.

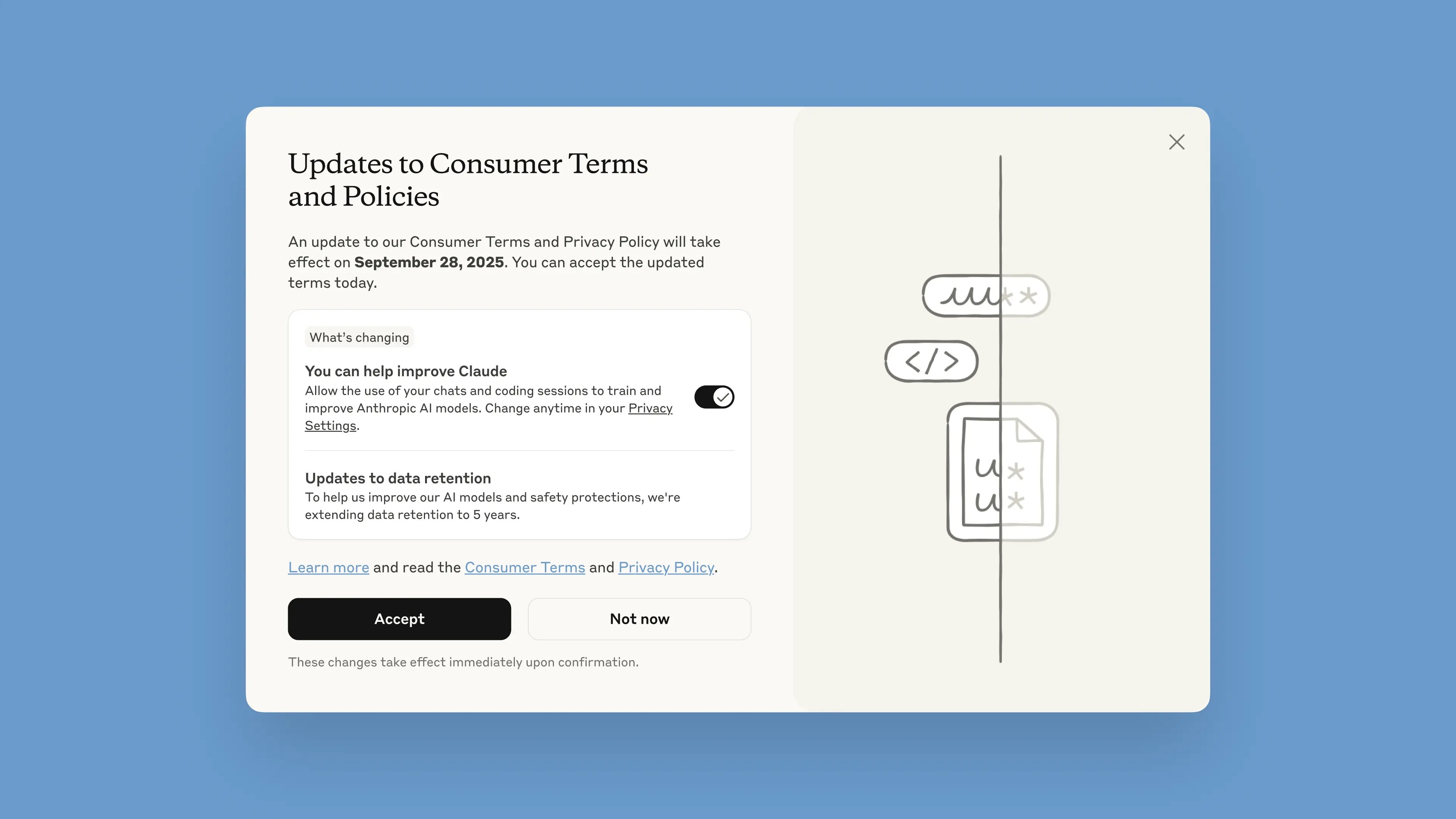

Это уведомление будет опубликовано в чат-боте с 28 августа. У пользователей есть один месяц, чтобы принять или отклонить условия. Новые правила вступят в силу немедленно после их принятия. После 28 сентября пользователям потребуется подтвердить своё согласие, чтобы продолжить использование Claude.

По заявлению компании, обновления направлены на создание более мощных и полезных моделей искусственного интеллекта. Изменить эту опцию легко, и её можно сделать в любое время в настройках конфиденциальности.

Эти изменения касаются тарифных планов Claude Free, Pro и Max, которые включают Claude Code, инструмент программирования от Anthropic. Сервисы, подпадающие под действие Коммерческих условий, включая Claude for Work, Claude Gov, Claude for Education, а также использование API, в том числе сторонних, таких как Amazon Bedrock и Vertex AI от Google Cloud, не будут применяться.

Участвуя в проекте, пользователи помогут повысить безопасность модели, повысив её способность точно определять вредоносный контент и снизив риск ошибочной пометки безобидных разговоров, говорится в сообщении Anthropic в её блоге. В будущих версиях Claude также будут улучшены такие навыки, как программирование, анализ и рассуждение.

Важно, чтобы пользователи имели полный контроль над своими данными и могли самостоятельно разрешить платформе использовать их во всплывающих окнах. Новые учётные записи могут настроить это при регистрации.

|

Всплывающее окно «Новые условия» в чат-боте. Фото: Anthropic. |

Срок хранения данных увеличен до пяти лет. Он распространяется на новые или продолжающиеся разговоры или сеансы кодирования, а также на ответы чат-ботов. Удаленные данные не будут использоваться для обучения модели в будущем. Если пользователи не согласятся предоставлять данные для обучения, для них будет действовать текущая 30-дневная политика хранения.

Объясняя эту политику, компания Anthropic отметила, что циклы разработки ИИ обычно занимают годы, и поддержание согласованности данных на протяжении всего процесса обучения также способствует стабильности моделей. Более длительное хранение данных также улучшает работу классификаторов — систем, используемых для выявления злоупотреблений, — и позволяет выявлять вредоносные шаблоны.

«Для защиты конфиденциальности пользователей мы используем комбинацию автоматизированных инструментов и процессов для фильтрации или маскировки конфиденциальных данных. Мы не продаём данные пользователей третьим лицам», — написала компания.

Компанию Anthropic часто называют одним из лидеров в области безопасного ИИ. Компания Anthropic разработала подход, называемый «Конституционный ИИ», который устанавливает этические принципы и правила, которым должны следовать модели. Anthropic также входит в число компаний, подписавших Обязательства по безопасному ИИ с правительствами США, Великобритании и стран «Большой семёрки».

Источник: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

![[Фото] Осмотрите военный корабль ВМС США USS Robert Smalls.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F10%2F1765341533272_11212121-8303-jpg.webp&w=3840&q=75)

Комментарий (0)