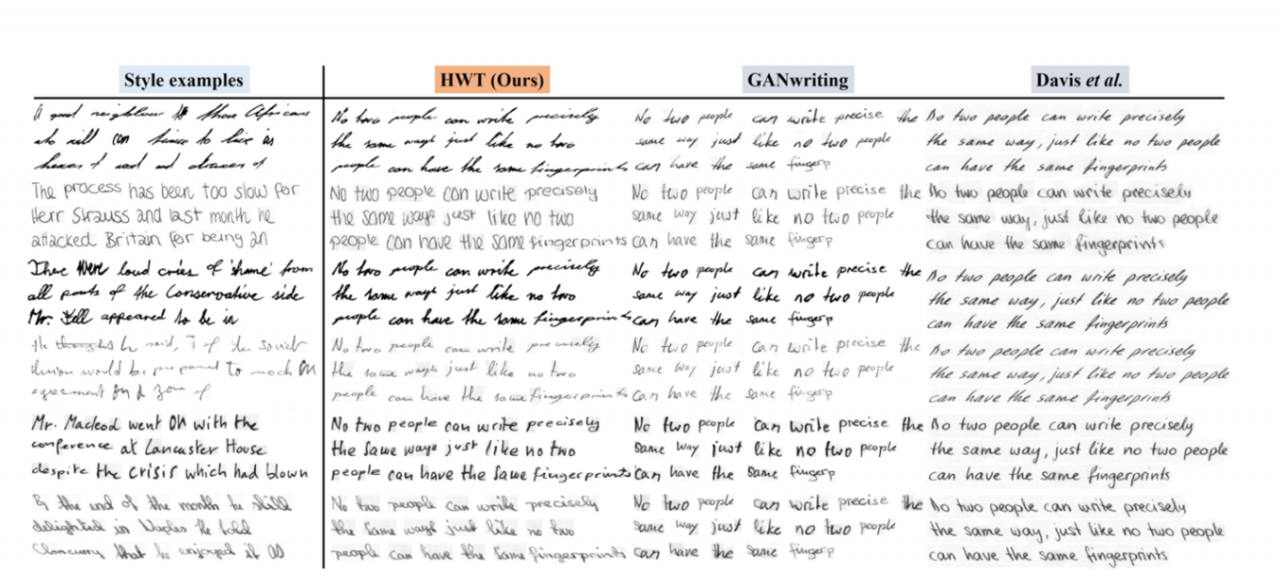

ทีมนักวิจัยจากมหาวิทยาลัยปัญญาประดิษฐ์โมฮัมเหม็ด บิน ซายิด (MBZUAI) ในเมืองอาบูดาบี (สหรัฐอาหรับเอมิเรตส์) ได้พัฒนาระบบ AI ที่สามารถเลียนแบบลายมือมนุษย์และสร้างข้อความที่คล้ายกับลายมือของตนเองได้

ระบบที่เรียกว่า HWT ได้รับการพัฒนาขึ้นโดยใช้เครื่องแปลงภาพคอมพิวเตอร์ ซึ่งมีความสามารถในการเข้าใจบริบทและความหมายของข้อมูลในระบบ รวมถึงรูปภาพของข้อความและคำต่างๆ

ฟาฮัด ข่าน สมาชิกในทีมวิจัยกล่าวว่า “ในการเลียนแบบรูปแบบลายมือของใครสักคน AI จะต้องดูข้อความทั้งหมด จากนั้นจึงเริ่มทำความเข้าใจว่าผู้เขียนเชื่อมโยงอักขระ ตัวอักษร และช่องว่างระหว่างคำอย่างไร”

งานวิจัยนี้ได้รับการอนุมัติสิทธิบัตรจากสำนักงานสิทธิบัตรและเครื่องหมายการค้าสหรัฐอเมริกาสำหรับเครื่องมือที่จะช่วยให้ผู้ที่มีอาการบาดเจ็บสามารถเขียนหนังสือได้โดยไม่ต้องใช้ปากกา

Rao Muhammad Anwer ซึ่งเป็นผู้ช่วยศาสตราจารย์ด้านวิสัยทัศน์คอมพิวเตอร์ หนึ่งในนักประดิษฐ์ กล่าวกับ Bloomberg ในการสัมภาษณ์ว่า ระบบดังกล่าวสามารถใช้อ่านลายมือของแพทย์ที่ขึ้นชื่อว่ายากต่อการอ่าน และยังสามารถสร้างโฆษณาเฉพาะบุคคลได้อีกด้วย

เครื่องมือนี้ยังไม่มีให้ใช้อย่างแพร่หลายและปัจจุบันสามารถสร้างข้อความภาษาอังกฤษและภาษาฝรั่งเศสบางส่วนได้ แต่การสร้างข้อความลายมือเป็นภาษาอาหรับกำลังพิสูจน์ให้เห็นว่าเป็นงานที่ยากกว่า

นักประดิษฐ์ตั้งข้อสังเกตว่าเครื่องมือดังกล่าวอาจถูก "นำไปใช้อย่างผิดวิธี" เพื่อปลอมแปลงลายมือของผู้คน ดังนั้นพวกเขาจึง "ระมัดระวังเป็นอย่างยิ่ง"

“การเขียนด้วยลายมือแสดงถึงตัวตนของบุคคล ดังนั้นเราจึงพิจารณาเรื่องนี้อย่างรอบคอบก่อนที่จะดำเนินการ” Anwer กล่าวในข่าวเผยแพร่

Hisham Cholakkal ผู้ช่วยศาสตราจารย์ด้านวิสัยทัศน์คอมพิวเตอร์ที่ MBZUAI กล่าวกับ Bloomberg ว่า "เราจะต้องสร้างความตระหนักรู้ให้กับสาธารณชนและพัฒนาเครื่องมือเพื่อต่อสู้กับการปลอมแปลงข้อมูล" "มันเหมือนกับการพัฒนาโปรแกรมป้องกันไวรัส"

AI ถูกนำไปใช้อย่างผิดวิธีในหลากหลายวิธี เช่น เครื่องมือสร้างภาพ AI อย่าง Midjourney และ Stable Diffusion ที่ถูกนำไปใช้สร้างภาพ Deepfake ของคนดัง

ในขณะเดียวกัน AI ที่เลียนแบบเสียงมนุษย์ก็ถือเป็นปัญหาเช่นกัน เมื่อเดือนกันยายนที่ผ่านมา สตีเฟน ฟราย นักแสดงชื่อดังกล่าวว่าระบบ AI ได้คัดลอกเสียงของเขาจากหนังสือชุดแฮร์รี่ พอตเตอร์จำนวน 7 เล่ม เพื่อพากย์เสียงสารคดีอย่างผิดกฎหมาย

(ตามข้อมูลของ BI)

แหล่งที่มา

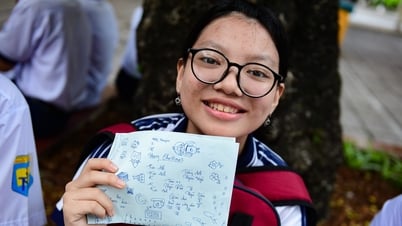

![[ภาพ] ผู้สมัครเกือบ 104,000 คนในฮานอยผ่านขั้นตอนการสอบเข้าชั้นมัธยมศึกษาปีที่ 10](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/6/7/7dbf58fd77224eb583ea5c819ebf5a4e)

![[OCOP REVIEW] น้ำเชื่อม Tu Duyen - สารสกัดสมุนไพรจากภูเขาและป่าไม้ของ Nhu Thanh](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/6/5/58ca32fce4ec44039e444fbfae7e75ec)

การแสดงความคิดเห็น (0)