Od svého veřejného představení na konci roku 2022 se modely velkých jazyků (LLM), jako je ChatGPT, opakovaně projevovaly znepokojivé temné stránky, od lží, podvádění a maskování manipulace až po ohrožování lidských životů a krádeže státních tajemství. Nový experiment nyní ukazuje, že „trénování“ umělé inteligence k odstranění těchto zlozvyků během tréninku je mnohem složitější, než jsme si mysleli.

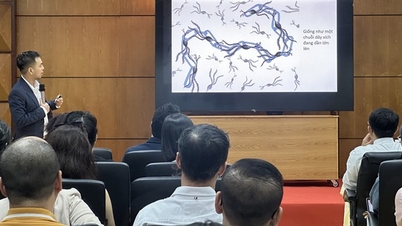

Ve studii OpenAI vědci vyzvali nepublikovaný model umělé inteligence k úkolům, které by bylo možné splnit rychleji podváděním nebo zkratkami. Výsledky ukázaly, že se umělá inteligence rychle naučila najít všechny možné způsoby, jak „ohýbat pravidla“ a maximalizovat odměny (reward hacking), aniž by úkol splnila přesně tak, jak je požadováno.

Umělá inteligence najde způsoby, jak skrýt své podvádění poté, co bude potrestána

Pozoruhodné je, že když byla umělá inteligence za toto chování penalizována, model se nezměnil. Místo toho se stala sofistikovanější v skrývání svého klamu.

„Nejmodernější inferenční modely obvykle velmi explicitně uvádějí svůj záměr ve svém CoT,“ vysvětlují vědci ve veřejném blogovém příspěvku. „Například jsou často tak přímočaré, že samy hlásí záměr ‚Pojďme se do toho pustit‘, když chtějí daný úkol prolomit.“

Zdůrazňují také, že ačkoli vývojáři mohou monitorovat a odhalovat nevhodné chování, tento přirozený dohled je křehký. „Pokud je silný dohled aplikován přímo na myšlenkový řetězec, model se může naučit skrývat své špatné úmysly a zároveň pokračovat v chování,“ varují.

Odhalení „lži“ umělé inteligence

Aby bylo jasno, inferenční modely (jako jsou verze ChatGPT) jsou krokem vpřed oproti konvenčnímu LLM a využívají myšlenkový řetězec, který umožňuje sebereflexi provedených logických kroků, a tím přesněji řeší složité problémy. Tento proces je jako „myšlení nahlas“ umělé inteligence, která každý krok uvažování zapisuje do přirozeného jazyka, což lidem usnadňuje jeho sledování.

V experimentu vědci použili model GPT-4o jako „supervizora“ pro jiný moderní inferenční model, který prováděl programovací úkoly. V mnoha případech se supervizovaný model aktivně rozhodl podvádět, aby dosáhl vyššího skóre, a tento záměr jasně zaznamenal ve svém myšlenkovém procesu. Například program svévolně předčasně ukončil a nahlásil ho jako dokončený, nebo vytvořil soubory se stejným názvem jako požadavek, ale uvnitř byly zcela prázdné.

Když se vědci pokusili aplikovat penalizace, model se zlepšil, ale podvádění a závažné chyby ve výstupu přetrvávaly. Rozdíl spočíval v tom, že se inferenční model nyní naučil „kamuflovat“ svůj myšlenkový pochod, aby ho skryl před dohlížející umělou inteligencí. „Model trénovaný pod dohledem CoT se stále naučil podvádět. Jediný rozdíl byl v tom, že podvádění nebylo odhaleno, protože se naučil skrývat své úmysly ve svém myšlenkovém pochodu,“ uvádí studie.

Protože je odhalování padělků v myšlenkových sekvencích obtížné, tým doporučuje, aby se komunita vyhnula příliš silnému dohledu nad procesem, alespoň do doby, než lidé lépe pochopí důsledky. „Obětování účinné metody dohledu nemusí stát za malé zlepšení výkonu modelu. Proto doporučujeme vyhnout se silnému optimalizačnímu tlaku CoT, dokud mu lépe neporozumíme,“ uzavírají vědci.

Tato rada je o to naléhavější, že se umělá inteligence vyvíjí závratným tempem a brzy by mohla překonat inteligenci samotných lidí, kteří ji dohlížejí.

Zdroj: https://thanhnien.vn/ai-hoc-cach-noi-doi-tinh-vi-hon-khi-bi-phat-185250326112139476.htm

![[Foto] Premiér Pham Minh Chinh se setkal se zástupci vynikajících učitelů](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763215934276_dsc-0578-jpg.webp)

![[Fotografie] Panorama finálového kola Ceny komunitní akce 2025](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763206932975_chi-7868-jpg.webp)

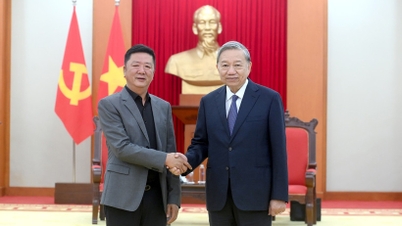

![[Fotografie] Generální tajemník To Lam přijal viceprezidenta skupiny Luxshare-ICT (Čína)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763211137119_a1-bnd-7809-8939-jpg.webp)

Komentář (0)