Nvidia war einst als Hersteller von Chips für die Videospielindustrie bekannt, hat seinen Fokus in den letzten Jahren aber auf den Markt für Rechenzentren verlagert.

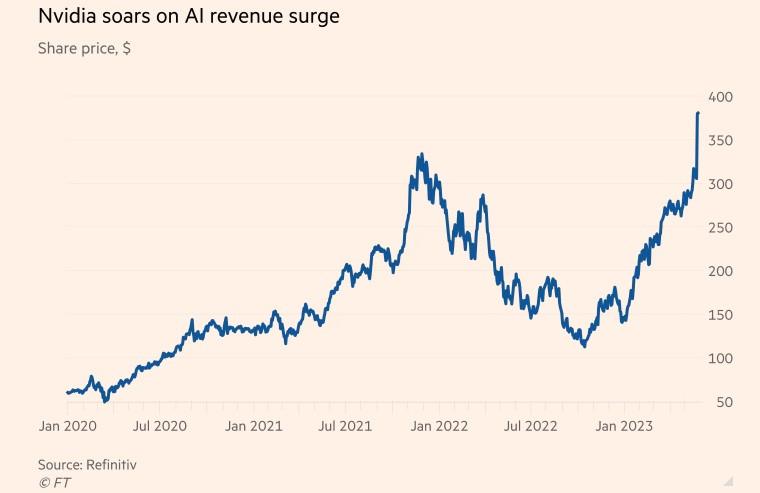

Das amerikanische Chipunternehmen erlebte während der Pandemie einen rasanten Aufschwung, da die Nachfrage nach Gaming- und Cloud-Anwendungen sowie der weltweite Boom beim Kryptowährungs-Mining stark anstieg. Zum Ende des Geschäftsjahres am 29. Januar trug das Geschäft mit Rechenzentrumschips bereits über 50 % zum Umsatz des Unternehmens bei.

Der äußerst beliebte Chatbot ChatGPT hat die Entwicklung künstlicher Intelligenz (KI) in diesem Jahr auf ein neues Niveau gehoben. Diese Technologie nutzt riesige Mengen verfügbarer Daten, um neue Inhalte zu verschiedensten Themen zu erstellen, von Poesie bis hin zu Computerprogrammierung.

Microsoft und Alphabet, zwei Technologiegiganten und führende Akteure im Bereich der künstlichen Intelligenz, sind überzeugt, dass generative Technologien die Arbeitswelt verändern können. Beide Unternehmen liefern sich einen Wettlauf um die Integration von KI in Suchmaschinen und Bürosoftware mit dem Ziel, die Branche zu dominieren.

Goldman Sachs schätzt, dass die US-Investitionen in KI bis 2030 etwa 1 % der Wirtschaftsleistung des Landes ausmachen könnten.

Supercomputer, die für Datenverarbeitung und KI-Generierung eingesetzt werden, nutzen Grafikprozessoren (GPUs). GPUs sind speziell für die Rechenaufgaben der KI entwickelt und deutlich effizienter als zentrale Prozessoren anderer Chiphersteller wie Intel. Beispielsweise wird OpenAIs ChatGPT von Tausenden von Nvidia-GPUs angetrieben.

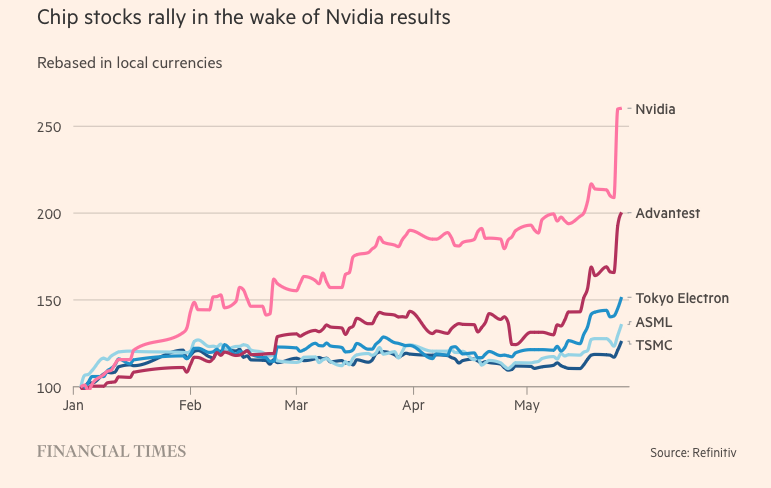

Nvidia hält derzeit rund 80 % des GPU-Marktanteils. Zu den Hauptkonkurrenten von Nvidia zählen Advanced Micro Devices und hauseigene KI-Chips von Technologieunternehmen wie Amazon, Google und Meta Platforms.

Geheimnisse zur Erlangung von Transzendenz

Der Durchbruch dieses Unternehmens war dem H100 zu verdanken, einem Chip, der auf Nvidias neuer „Hopper“-Architektur basiert – benannt nach der amerikanischen Programmierikone Grace Hopper. Der KI-Boom machte den H100 zum begehrtesten Produkt im Silicon Valley.

Diese riesigen Chips, die in Rechenzentren zum Einsatz kommen, verfügen über 80 Milliarden Transistoren – fünfmal so viele wie die Siliziumchips in den neuesten iPhones. Obwohl der H100 doppelt so teuer ist wie sein Vorgänger, der A100 (erschienen 2020), bieten Nutzer laut eigenen Angaben die dreifache Leistung.

Der H100 erfreut sich besonderer Beliebtheit bei großen Technologieunternehmen wie Microsoft und Amazon, die ganze Rechenzentren auf KI-Workloads ausrichten, sowie bei KI-Startups der nächsten Generation wie OpenAI, Anthropic, Stability AI und Inflection AI, da er eine höhere Leistung verspricht, die Produkteinführungen beschleunigen oder die Trainingskosten im Laufe der Zeit senken kann.

„Dies ist derzeit eine der knappsten technischen Ressourcen“, sagte Brannin McBee, Chief Strategy Officer und Gründer von CoreWeave, einem KI-gestützten Cloud-Startup und einem der ersten Unternehmen, das Anfang dieses Jahres eine Lieferung von H100 erhielt.

Andere Kunden hatten nicht so viel Glück wie CoreWeave und mussten bis zu sechs Monate auf das Produkt warten, um ihre riesigen Datensätze trainieren zu können. Viele KI-Startups befürchten, dass Nvidia die Marktnachfrage nicht decken kann.

Elon Musk bestellte außerdem Tausende von Nvidia-Chips für sein KI-Startup und sagte: „GPUs sind derzeit schwerer zu bekommen als Medikamente.“

„Die Computerkosten sind explodiert. Der Mindestbetrag, der für Serverhardware zur Entwicklung innovativer KI-Systeme benötigt wird, hat 250 Millionen Dollar erreicht“, teilte der CEO von Tesla mit.

Obwohl die H100 zum richtigen Zeitpunkt erschien, wurzelte Nvidias Durchbruch im Bereich KI bereits zwei Jahrzehnte zuvor und wurde durch Softwareinnovationen, nicht durch Hardware, vorangetrieben. 2006 brachte das Unternehmen die CUDA-Software auf den Markt, die GPUs nutzte, um Aufgaben jenseits der Grafik zu beschleunigen.

„Nvidia erkannte die Zukunft voraus und verlagerte seinen Fokus auf die Entwicklung programmierbarer GPUs. Das Unternehmen erkannte die Chance, setzte alles auf eine Karte und übertraf seine Konkurrenten konstant“, sagte Nathan Benaich, Partner bei Air Street Capital und Investor in KI-Startups.

(Laut Reuters, FT)

Quelle

![[Foto] Abschlusszeremonie der 10. Sitzung der 15. Nationalversammlung](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F11%2F1765448959967_image-1437-jpg.webp&w=3840&q=75)

![[Foto] Premierminister Pham Minh Chinh telefoniert mit dem Vorstandsvorsitzenden des russischen Energiekonzerns Rosatom.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F11%2F1765464552365_dsc-5295-jpg.webp&w=3840&q=75)

![[OFFIZIELL] MISA GROUP VERKÜNDET IHRE PIONIERTÄTIGE MARKENPOSITIONIERUNG IM BEREICH DER ENTWICKLUNG VON KI-AGENTEN FÜR UNTERNEHMEN, HAUSHALTE UND DIE REGIERUNG](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/11/1765444754256_agentic-ai_postfb-scaled.png)

Kommentar (0)