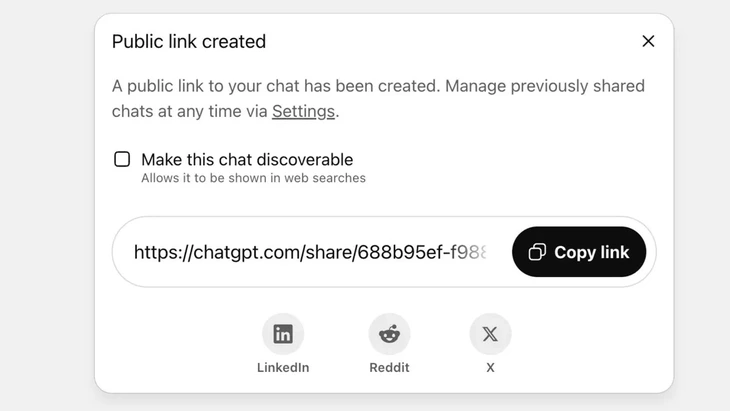

Funktion zum Teilen von Chats über einen öffentlichen Link auf ChatGPT – Foto: Techradar

ChatGPT erreicht mittlerweile täglich über 2,5 Milliarden Anfragen von Nutzern weltweit, was die wachsende Beliebtheit dieses Chatbots unterstreicht.

Allerdings stößt dieses Tool bei den Nutzern auf heftige Kritik, da die „Teilen“-Funktion dazu geführt hat, dass in Tausenden von Konversationen sensible Informationen an Google und einige Suchmaschinen im Internet gelangten.

Hohes Sicherheitsrisiko

Herr Vu Ngoc Son - Leiter der Technologieabteilung der National Cyber Security Association (NCA) - kam zu dem Schluss, dass der oben genannte Vorfall ein hohes Sicherheitsrisiko für ChatGPT-Nutzer darstellt.

„Der oben genannte Vorfall ist nicht unbedingt auf einen technischen Fehler zurückzuführen, da das Klicken des Teilen-Buttons eine gewisse Eigeninitiative des Nutzers erkennen lässt. Vielmehr liegt das Problem im Design des KI-Chatbots, der die Nutzer verwirrt und nicht ausreichend vor dem Risiko des Datenlecks beim Teilen warnt“, analysierte Herr Vu Ngoc Son.

Bei ChatGPT wird diese Funktion implementiert, nachdem der Benutzer sich entschieden hat, den Chat über einen öffentlichen Link zu teilen. Der Inhalt wird auf dem Server von OpenAI als öffentliche Website (chatgpt.com/share/...) gespeichert; für den Zugriff ist kein Login oder Passwort erforderlich.

Die Crawler von Google scannen und indexieren diese Seiten automatisch, sodass sie in den Suchergebnissen erscheinen, einschließlich sensibler Texte, Bilder oder Chatdaten.

Viele Nutzer waren sich des Risikos nicht bewusst und dachten, sie würden den Chat mit Freunden oder Kontakten teilen. Dies führte dazu, dass Tausende von Konversationen offengelegt wurden, die in einigen Fällen sensible persönliche Informationen enthielten.

Obwohl OpenAI diese Funktion nach heftiger Kritik aus der Community Ende Juli 2025 schnell entfernte, dauerte die Abstimmung mit Google zur Löschung der alten Indizes dennoch einige Zeit. Insbesondere bei dem komplexen Speichersystem, das auch Googles Cache-Server umfasst, ist dies nicht schnell möglich.

Behandeln Sie KI-Chatbots nicht als „Sicherheits-Blackbox“.

Datensicherheitsexperte Vu Ngoc Son – Technologiechef der Nationalen Cybersicherheitsvereinigung (NCA) – Foto: CHI HIEU

Das Durchsickern von Tausenden von Chatprotokollen kann Risiken für die Nutzer bergen, wie die Offenlegung persönlicher und geschäftlicher Geheimnisse, Rufschädigung, finanzielle Risiken oder sogar Sicherheitsrisiken durch die Offenlegung von Wohnadressen.

„KI-gestützte Chatbots sind zwar nützlich, aber keine ‚Black Box‘, da geteilte Daten im Web für immer existieren können, wenn sie nicht kontrolliert werden.“

Der oben beschriebene Vorfall ist zweifellos eine Lehre für Anbieter und Nutzer gleichermaßen. Andere KI-Dienstleister können aus dieser Erfahrung lernen und Funktionen mit klareren und transparenteren Warnhinweisen entwickeln.

Gleichzeitig müssen die Nutzer auch proaktiv die unkontrollierte Veröffentlichung identifizierender oder persönlicher Informationen auf KI-Plattformen einschränken“, empfahl der Sicherheitsexperte Vu Ngoc Son.

Laut Datensicherheitsexperten verdeutlicht der oben genannte Vorfall den Bedarf an rechtlichen Rahmenbedingungen und Cybersicherheitsstandards für KI. KI-Anbieter und -Entwickler müssen zudem Systeme entwickeln, die Sicherheit gewährleisten und das Risiko von Datenlecks minimieren. Dazu gehören beispielsweise: Datenlecks durch Sicherheitslücken; Software-Schwachstellen, die zu Datenbankangriffen führen; und mangelhafte Kontrollen, die zu Manipulation und Missbrauch führen, um falsche oder verzerrte Fragen zu beantworten.

Nutzer müssen zudem die Weitergabe persönlicher Daten an die KI kontrollieren und dürfen keine sensiblen Informationen weitergeben. Im Bedarfsfall empfiehlt es sich, den Anonymisierungsmodus zu nutzen oder Informationen aktiv zu verschlüsseln, um zu vermeiden, dass Daten direkt mit bestimmten Personen in Verbindung gebracht werden.

Quelle: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Foto] „Schiffsfriedhof“ in der Xuan-Dai-Bucht](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Video] Denkmäler von Hue öffnen wieder ihre Pforten und heißen Besucher willkommen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Kommentar (0)