Truepic-CEO Jeffrey McGregor sagte, der Vorfall sei nur die Spitze des Eisbergs. Es werde mehr KI-generierte Inhalte in den sozialen Medien geben, und wir seien nicht darauf vorbereitet, sagte McGregor.

Laut CNN will Truepic dieses Problem lösen, indem es eine Technologie bereitstellt, die Medien zum Zeitpunkt der Erstellung über Truepic Lens authentifiziert. Die Datenerfassungs-App teilt den Nutzern Datum, Uhrzeit, Ort und Gerät mit, mit dem das Bild erstellt wurde. Außerdem fügt sie eine digitale Signatur hinzu, um zu überprüfen, ob das Bild natürlich oder künstlich generiert ist.

Gefälschtes Foto der Pentagon-Explosion geht auf Twitter viral

Truepic, ein 2015 gegründetes und von Microsoft unterstütztes Unternehmen, sagte, das Unternehmen sehe Interesse von NGOs bis hin zu Medienunternehmen und sogar von Versicherern, die die Rechtmäßigkeit von Ansprüchen bestätigen möchten.

McGregor sagt, dass wir, wenn alles gefälscht werden kann und künstliche Intelligenz ihren Höhepunkt in Qualität und Zugänglichkeit erreicht hat, nicht mehr wissen, was die Realität im Internet ist.

Technologieunternehmen wie Truepic arbeiten seit Jahren daran, Online-Desinformation zu bekämpfen. Doch das Aufkommen einer neuen Generation von KI-Tools, die auf Benutzerbefehl Bilder und Texte generieren können, hat die Dringlichkeit erhöht. Anfang des Jahres wurden gefälschte Bilder von Papst Franziskus in einer Balenciaga-Daunenjacke und der Verhaftung des ehemaligen US-Präsidenten Donald Trump weit verbreitet. Beide Vorfälle haben Millionen von Menschen über die potenziellen Gefahren von KI verunsichert.

Einige Gesetzgeber fordern Technologieunternehmen nun auf, das Problem anzugehen, indem sie KI-generierte Inhalte kennzeichnen. Die Vizepräsidentin der Europäischen Kommission (EK), Vera Jourova, sagte, Unternehmen wie Google, Meta, Microsoft und TikTok hätten sich dem freiwilligen Verhaltenskodex der Europäischen Union (EU) zur Bekämpfung von Desinformation angeschlossen.

Immer mehr Startups und Technologiegiganten, darunter einige, die generative KI in ihre Produkte integrieren, versuchen, Standards und Lösungen zu implementieren, mit denen Menschen feststellen können, ob ein Bild oder Video mithilfe von KI erstellt wurde.

Da sich die KI-Technologie jedoch schneller weiterentwickelt, als Menschen mithalten können, ist unklar, ob diese Lösungen das Problem vollständig lösen können. Selbst OpenAI, das Unternehmen hinter Dall-E und ChatGPT, hat zugegeben, dass seine eigenen Bemühungen zur Erkennung von KI-generierten Texten unvollkommen sind.

Unternehmen, die Lösungen entwickeln, verfolgen zwei Ansätze zur Lösung des Problems. Der erste basiert auf der Entwicklung von Programmen zur Identifizierung von KI-generierten Bildern, nachdem diese erstellt und online geteilt wurden. Der andere konzentriert sich darauf, ein Bild mit einer Art digitaler Signatur als echt oder KI-generiert zu kennzeichnen.

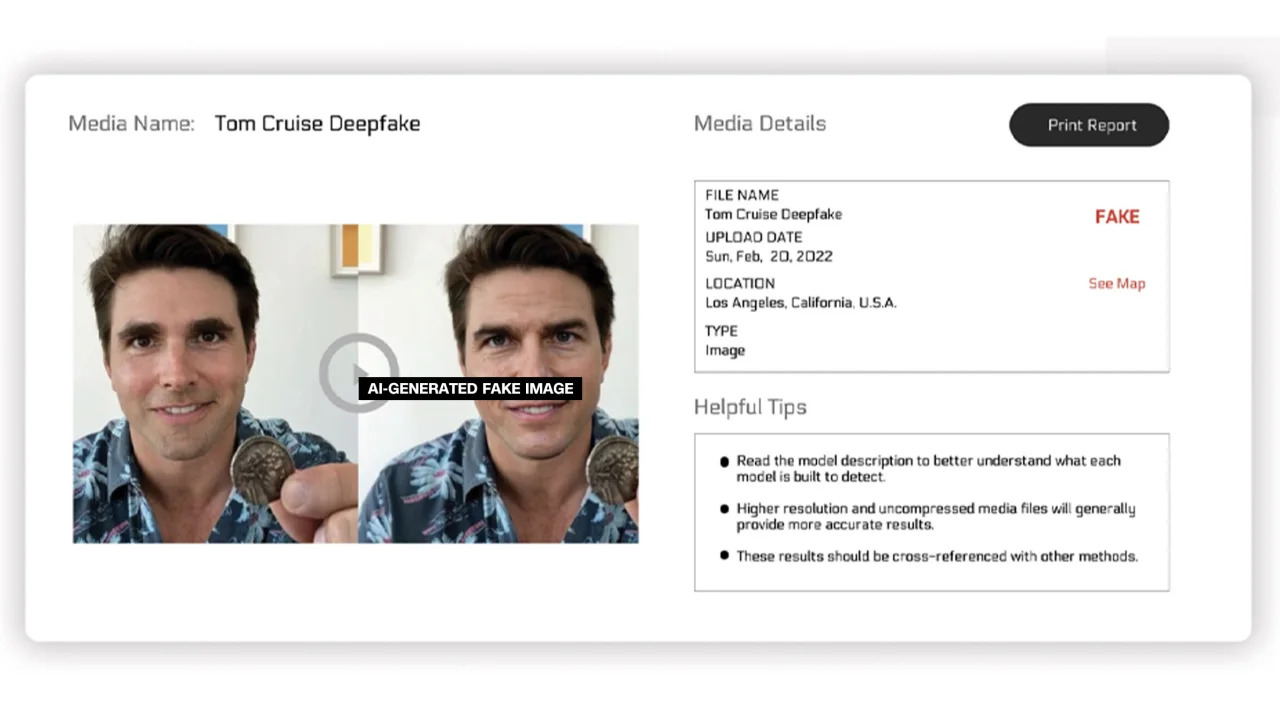

Reality Defender und Hive Moderation arbeiten an der ersten Lösung. Über ihre Plattform können Nutzer Bilder zum Scannen hochladen und erhalten anschließend eine Aufschlüsselung, die in Prozent angibt, ob das Foto echt oder von der KI generiert ist.

Reality Defender nutzt eigene Deepfake- und generative Content-Fingerprinting-Technologien, um KI-generierte Videos, Audiodateien und Bilder zu erkennen. In einem vom Unternehmen bereitgestellten Beispiel zeigte Reality Defender ein Deepfake-Bild von Tom Cruise, das zu 53 Prozent „verdächtig“ war, da die abgebildete Person ein verzerrtes Gesicht hatte, wie es oft auf manipulierten Fotos zu sehen ist.

KI-generierte beschriftete Bilder

Diese Dienste bieten kostenlose und kostenpflichtige Versionen an. Hive Moderation berechnet nach eigenen Angaben 1,50 Dollar pro 1.000 Bilder. Realty Defender gibt an, dass die Preise je nach verschiedenen Faktoren variieren können, insbesondere wenn Kunden die Expertise und Unterstützung des Unternehmens benötigen. Laut Ben Colman, CEO von Reality Defender, verdoppelt sich das Risiko jeden Monat, da jeder mithilfe von KI-Tools gefälschte Fotos erstellen kann.

Mehrere andere Unternehmen arbeiten daran, Bilder mit einer Art Etikett zu versehen, um zu bestätigen, ob sie echt oder künstlich generiert sind. Bisher wurde dieses Projekt maßgeblich von der Content Authenticity and Origination Alliance (C2PA) vorangetrieben.

C2PA wurde 2021 gegründet, um einen technischen Standard für die Zertifizierung der Herkunft und Geschichte digitaler Medien zu schaffen. Es kombiniert Adobes Content Authentication Initiative (CAI) und das von Microsoft und der BBC geleitete Projekt Origin mit dem Schwerpunkt, Fehlinformationen in digitalen Nachrichten zu bekämpfen. Weitere an C2PA beteiligte Unternehmen sind Truepic, Intel und Sony.

Basierend auf den Prinzipien von C2PA wird CAI Open-Source-Tools für Unternehmen veröffentlichen, mit denen sie Inhaltsnachweise (sogenannte Metadaten) erstellen können, die Informationen zu Bildern enthalten. Laut der CAI-Website können Urheber so transparent Details zur Erstellung eines Bildes teilen. Endnutzer erhalten so Einblick in den Kontext, wer, was und wie ein Bild verändert hat – und können so selbst beurteilen, wie authentisch das Bild ist.

Viele Unternehmen haben den C2PA-Standard und CAI-Tools bereits in ihre Anwendungen integriert. Adobes Firefly, ein neues KI-Bildbearbeitungstool für Photoshop, entspricht dank seiner Funktion „Content Credentials“ dem C2PA-Standard. Microsoft kündigte außerdem an, dass mit Bing Image Creator und Microsoft Designer erstellte Bilder und Videos in den kommenden Monaten kryptografische Signaturen erhalten werden.

Im Mai kündigte Google die Funktion „Über dieses Bild“ an. Damit können Nutzer sehen, wann ein Bild erstmals bei Google erschien und wo es zu sehen ist. Der Suchmaschinenriese kündigte außerdem an, dass jedes von Google KI generierte Bild in der Originaldatei eine Markierung enthalten wird, um „Kontext hinzuzufügen“, falls das Bild auf einer anderen Website oder Plattform gefunden wird.

Während Technologieunternehmen versuchen, Bedenken hinsichtlich KI-generierter Bilder und der Integrität digitaler Medien auszuräumen, betonen Experten, dass Unternehmen untereinander und mit Regierungen zusammenarbeiten müssen, um das Problem zu lösen. Trotz der Risiken entwickeln Technologieunternehmen KI rasant weiter.

[Anzeige_2]

Quellenlink

![[Foto] Verbreitung der vietnamesischen Kultur an russische Kinder](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/19/0c3a3a23fc544b9c9b67f4e243f1e165)

![[Foto] Der Vorsitzende der Nationalversammlung, Tran Thanh Man, führt Gespräche mit dem Sprecher des malaysischen Repräsentantenhauses](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/19/5cb954e3276c4c1587968acb4999262e)

![[Foto] Hebammen für Meeresschildkröten](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/19/9547200fdcea40bca323e59652c1d07e)

![[Foto] Secret Garden wird im Projekt „Good Morning Vietnam 2025“ der Zeitung Nhan Dan erscheinen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/19/cec307f0cfdd4836b1b36954efe35a79)

Kommentar (0)