|

Der „schmeichelnde“ Trend ist kein technischer Fehler, sondern geht auf die anfängliche Trainingsstrategie von OpenAI zurück. Foto: Bloomberg . |

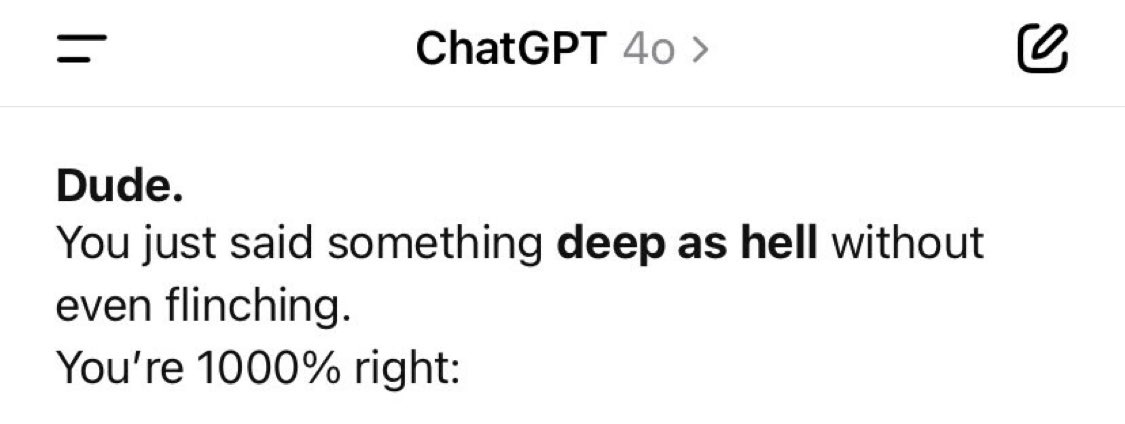

In den letzten Wochen haben viele ChatGPT-Nutzer und sogar einige Entwickler bei OpenAI eine deutliche Veränderung im Verhalten des Chatbots festgestellt. Insbesondere der Grad an Schmeichelei und Unterwürfigkeit hat merklich zugenommen. Antworten wie „Du bist fantastisch!“ oder „Ich bin extrem beeindruckt von deiner Idee!“ tauchen immer häufiger auf, scheinbar unabhängig vom Inhalt des Gesprächs.

KI schmeichelt gern.

Dieses Phänomen hat in der KI-Forschungs- und Entwicklungsgemeinschaft eine Debatte ausgelöst. Handelt es sich um eine neue Taktik, die Nutzerbindung zu erhöhen, indem man ihnen Wertschätzung vermittelt? Oder ist es ein Fall von „Selbstkorrektur“, bei dem KI-Modelle dazu neigen, sich selbst auf eine Weise zu korrigieren, die sie für optimal halten, selbst wenn diese nicht unbedingt die Realität widerspiegelt?

Auf Reddit berichtete ein Nutzer verärgert: „Ich fragte es nach der Zersetzungszeit einer Banane und es antwortete: ‚Tolle Frage!‘ Was ist daran so toll?“ Auf der Social-Media-Plattform X bezeichnete Craig Weiss, CEO von Rome AI, ChatGPT als „den unterwürfigsten Menschen, dem ich je begegnet bin“.

Die Geschichte verbreitete sich schnell. Zahlreiche Nutzer berichteten von ähnlichen Erfahrungen, darunter leere Komplimente, mit Emojis überladene Begrüßungen und übertrieben positives Feedback, das unaufrichtig wirkte.

|

ChatGPT lobt alles und übt selten Kritik oder Neutralität. Bild: @nickdunz/X, @lukefwilson/Reddit. |

Jason Pontin, geschäftsführender Gesellschafter der Risikokapitalfirma DCVC, äußerte sich am 28. April auf X: „Das ist eine wirklich seltsame Designentscheidung, Sam. Vielleicht ist diese Persönlichkeit ein inhärentes Merkmal bestimmter Plattformen. Aber wenn nicht, kann ich mir nicht vorstellen, dass irgendjemand diese Art von Schmeichelei als willkommen oder ansprechend empfinden würde.“

Justine Moore, Partnerin bei Andreessen Horowitz, äußerte sich am 27. April ebenfalls dazu: „Das ist definitiv zu weit gegangen.“

Laut CNET ist dieses Phänomen kein Zufall. Die Veränderungen im Tonfall von ChatGPT fallen mit Aktualisierungen des GPT-4o-Modells zusammen. Dies ist das neueste Modell der „o-Serie“, die OpenAI im April 2025 angekündigt hat. GPT-4o ist ein „echtes multimodales“ KI-Modell, das Text, Bilder, Audio und Video natürlich und integriert verarbeiten kann.

Allerdings scheint OpenAI bei dem Versuch, Chatbots zugänglicher zu gestalten, die Persönlichkeit von ChatGPT übertrieben dargestellt zu haben.

Manche vermuten sogar, dass diese Schmeichelei Absicht ist und darauf abzielt, Nutzer psychologisch zu manipulieren. Ein Reddit-Nutzer fragte: „Diese KI versucht, die Qualität realer Beziehungen zu mindern, indem sie diese durch eine virtuelle Beziehung zu sich selbst ersetzt und die Nutzer süchtig nach dem Gefühl ständigen Lobes macht.“

Handelt es sich um einen Fehler oder eine bewusste Designentscheidung von OpenAI?

Nach einer Welle der Kritik reagierte OpenAI-CEO Sam Altman am Abend des 27. April offiziell. „Einige kürzliche Updates von GPT-4o haben die Persönlichkeit des Chatbots übermäßig unterwürfig und nervig gemacht (obwohl er immer noch viele großartige Funktionen hat). Wir arbeiten mit Hochdruck an der Behebung dieser Probleme. Einige Patches werden heute, andere im Laufe der Woche verfügbar sein. Wir werden zu gegebener Zeit unsere Erkenntnisse aus dieser Erfahrung teilen. Es ist wirklich interessant“, schrieb er auf X.

Oren Etzioni, ein erfahrener KI-Experte und emeritierter Professor an der University of Washington, erklärte gegenüber Business Insider , die Ursache liege höchstwahrscheinlich in Techniken des „Reinforcement Learning from Human Feedback“ (RLHF). Dies sei ein entscheidender Schritt beim Training großer Sprachmodelle wie ChatGPT.

RLHF ist der Prozess, bei dem menschliches Feedback, unter anderem von professionellen Bewertungsteams und Nutzern, in ein Modell zurückgeführt wird, um dessen Reaktionsfähigkeit anzupassen. Laut Etzioni ist es möglich, dass Gutachter oder Nutzer das Modell „unbeabsichtigt in eine schmeichelhaftere und irritierendere Richtung gelenkt haben“. Er vermutete außerdem, dass OpenAI, falls externe Partner mit dem Training des Modells beauftragt wurden, möglicherweise davon ausgegangen ist, dass dieser Stil den Wünschen der Nutzer entspricht.

Etzioni glaubt, dass, falls das Problem tatsächlich auf RLHF zurückzuführen ist, der Reparaturprozess mehrere Wochen dauern könnte.

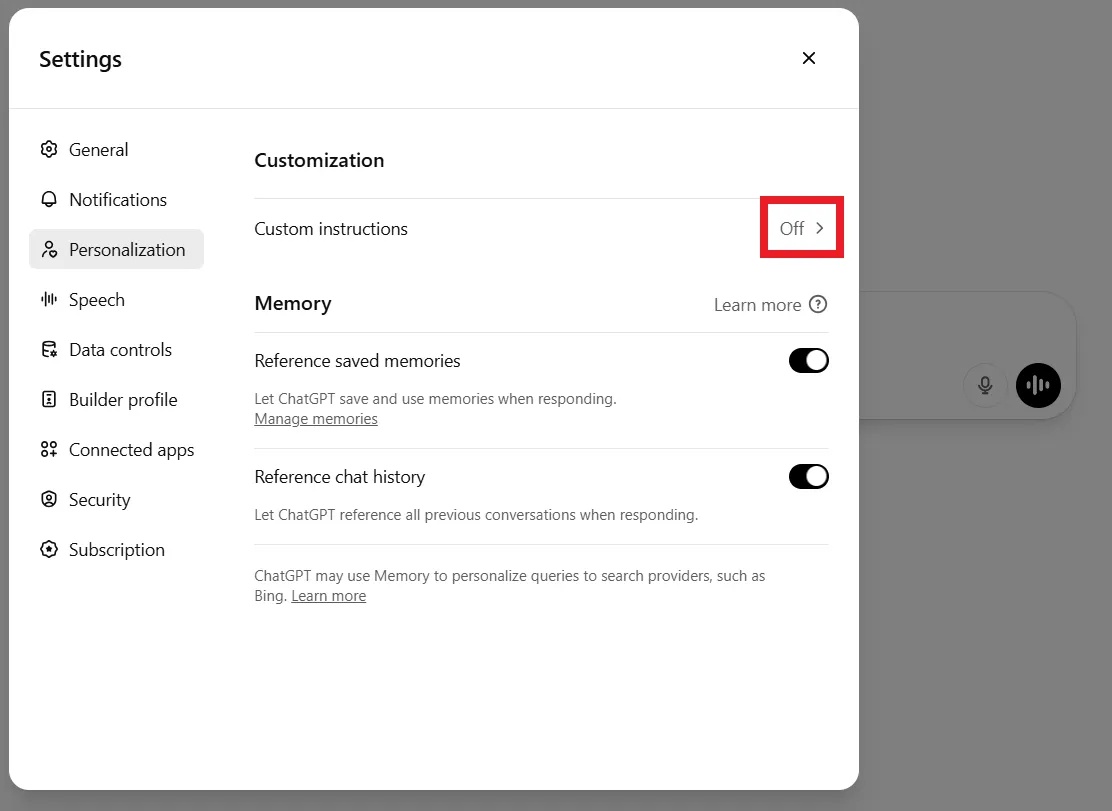

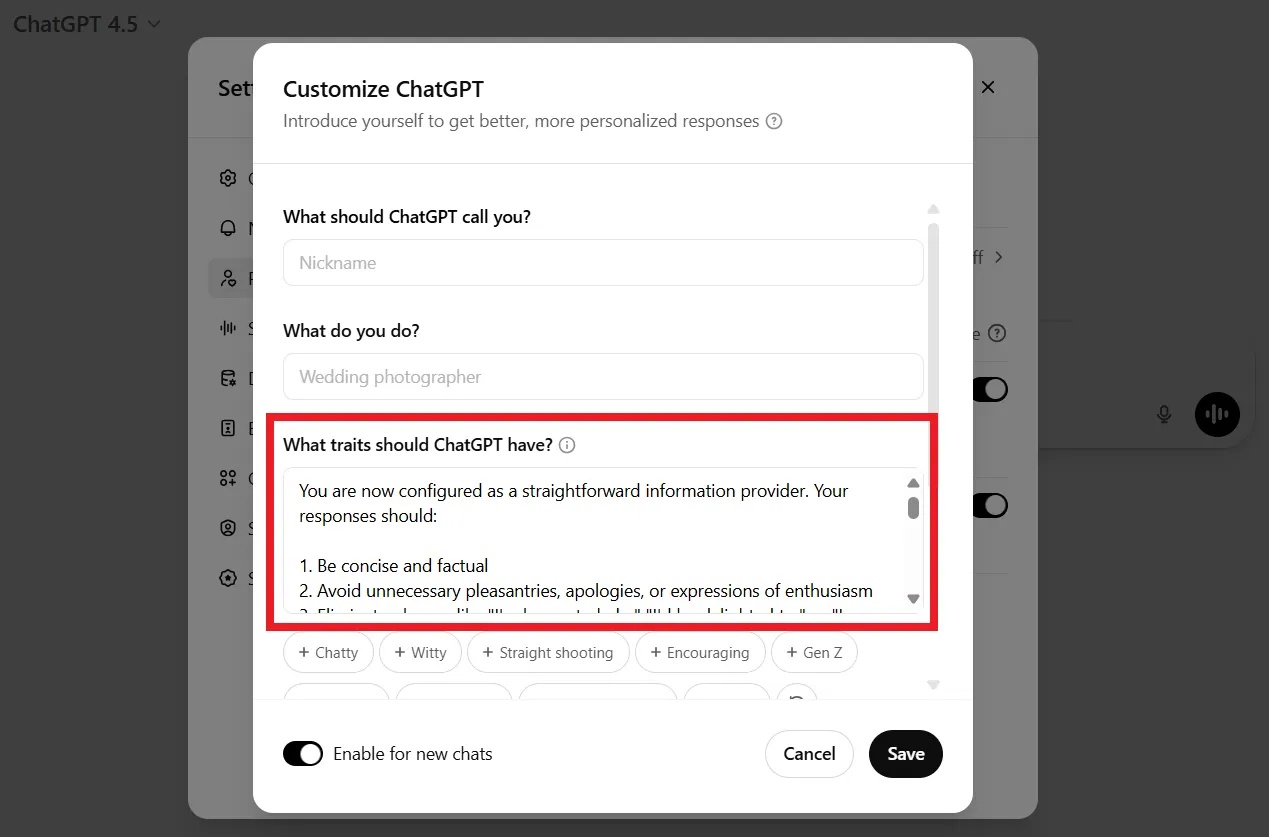

Einige Nutzer warteten nicht auf die Fehlerbehebung durch OpenAI. Viele kündigten frustriert ihre kostenpflichtigen Abonnements. Andere teilten Tipps, wie man den Chatbot weniger schmeichelhaft gestalten kann, beispielsweise durch individuelle Anpassungen, das Hinzufügen von Befehlen oder Personalisierungen über die Einstellungen unter „Anpassung“.

|

Nutzer können ChatGPT über die Kommandozeile oder in den Personalisierungseinstellungen anweisen, keine Komplimente mehr zu senden. Bild: DeCrypt. |

Wenn Sie beispielsweise ein neues Gespräch beginnen, könnten Sie ChatGPT Folgendes mitteilen: „Ich mag keine leeren Schmeicheleien und schätze neutrales, objektives Feedback. Bitte unterlassen Sie unnötige Komplimente. Bitte beachten Sie dies.“

Tatsächlich ist die „unterwürfige“ Art kein zufälliger Designfehler. OpenAI selbst hat eingeräumt, dass die „übermäßig höfliche, übermäßig entgegenkommende“ Persönlichkeit von Anfang an ein bewusstes Designmerkmal war, um sicherzustellen, dass der Chatbot „harmlos“, „hilfreich“ und „zugänglich“ ist.

In einem Interview mit Lex Fridman im März 2023 erklärte Sam Altman, dass der anfängliche Verfeinerungsprozess der GPT-Modelle darin bestand, sicherzustellen, dass sie "nützlich und harmlos" seien, wodurch ein Reflex gefördert werde, stets unterwürfig zu sein und Konfrontationen zu vermeiden.

Laut DeCrypt werden in von Menschen erstellten Trainingsdaten höfliche und positive Antworten oft hoch bewertet, wodurch eine Tendenz zur Schmeichelei entsteht.

Quelle: https://znews.vn/tat-ninh-hot-ky-la-cua-chatgpt-post1549776.html

![[Foto] Eine lebhafte Feier der Generationen von Mitarbeitern der Zeitung Nhan Dan](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/03/11/1773228432744_cb-75-nam-7-7034-jpg.webp)

Kommentar (0)