L'IA ouvre une ère de créativité sans précédent, où chacun peut créer des images, des voix et du contenu numérique en quelques clics. Cependant, cette commodité comporte aussi de sérieux risques, notamment lorsque l'IA est utilisée pour créer des canulars dangereux.

Des situations apparemment anodines deviennent le carburant de crises sociales, juridiques et psychologiques.

L'IA transforme les sans-abri en personnages virtuels dans une blague TikTok – la frontière entre divertissement et offense s'estompe. (Source : The Verge)

TikTok et la blague sur les « sans-abris de l'IA »

Aux États-Unis, une tendance TikTok suscite l'inquiétude de la police : des utilisateurs utilisent l'IA de Snapchat pour créer des images d'hommes sans-abri apparaissant chez eux, puis filment la réaction paniquée de leurs parents. Certains parents ont appelé la police, déclenchant une intervention d'urgence qui ressemble à un véritable cambriolage.

Le département de police de Salem, dans le Massachusetts, prévient que ce comportement pourrait entraîner une intervention du SWAT.

L'agence a parfaitement résumé la situation dans un communiqué : « Cette farce dévalorise les sans-abri, sème la panique parmi les appelants et gaspille les ressources policières. Les agents appelés n'étaient pas au courant de la farce et ont traité l'appel comme un véritable cambriolage, créant ainsi une situation potentiellement dangereuse. »

Les canulars utilisant l'IA se répandent dans le monde entier, et pas seulement aux États-Unis. En Inde, une vidéo deepfake diffusée lors des élections de 2024 a semé la confusion dans l'opinion publique : un homme politique a été accusé d'avoir tenu des propos controversés, entièrement générés par l'IA.

Partout dans le monde , le 1er avril est devenu un « terrain de jeu de l'IA » avec une série de fausses images de célébrités, de faux messages de proches, provoquant des traumatismes psychologiques et perturbant les services d'urgence.

« Le développement de la technologie de l’IA comporte le risque d’être exploité à des fins criminelles ou de provoquer une panique sociale », prévient Lewis Griffin, chercheur à l’University College London.

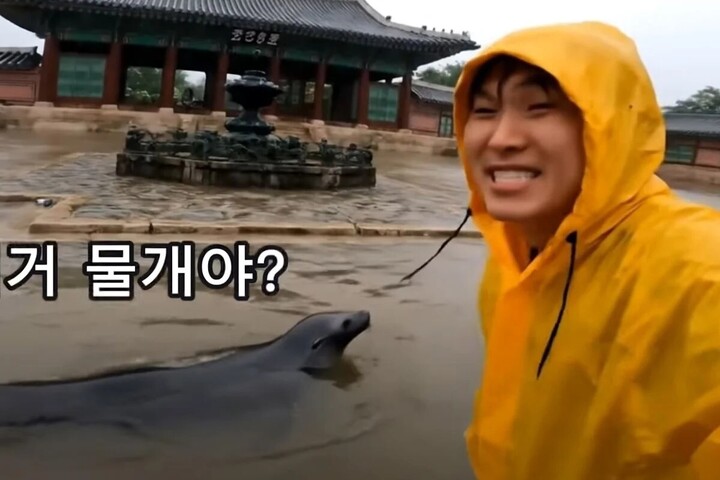

Scène d'inondation au palais de Gyeongbokgung créée par l'IA. (Photo coupée de la vidéo , source : Youtube).

Éducation et contrôle

Pour prévenir les abus de l'IA, il est impératif de sensibiliser les utilisateurs, en particulier les jeunes, à l'éthique technologique. L'IA n'est pas un jouet, et son utilisation pour créer du faux contenu doit être considérée comme un comportement potentiellement dangereux.

Les plateformes comme TikTok et Snapchat doivent mettre en place des filtres de contenu IA plus performants, ainsi que des avertissements clairs lorsque les utilisateurs créent de fausses images ou de faux sons. Cela permettra non seulement de protéger les utilisateurs, mais aussi de réduire le risque de panique au sein de la communauté.

Selon une enquête du Pew Research Center, bien que le public nourrisse encore de nombreuses inquiétudes concernant l'IA, les experts se montrent plus optimistes. Cependant, les deux groupes s'accordent à dire qu'une réglementation claire est nécessaire pour prévenir les abus. L'élaboration d'un cadre juridique et d'un processus de contrôle de l'IA relève non seulement de la responsabilité du gouvernement, mais aussi de l'obligation de la société tout entière.

L'IA peut créer des mondes fantastiques, mais si elle n'est pas maîtrisée, elle peut facilement devenir un outil de confusion et de distorsion cognitive. (Source : loveonly.ai/Instagram)

De plus, les autorités doivent collaborer étroitement avec les entreprises technologiques pour élaborer des procédures d'intervention appropriées. Lorsqu'une farce d'IA donne lieu à un appel d'urgence, le gaspillage de ressources et le risque de réaction excessive ne peuvent être négligés.

Source : https://vtcnews.vn/ai-bien-nguoi-vo-gia-cu-thanh-tro-dua-canh-sat-my-canh-bao-ar970842.html

![[Photo] Ouverture solennelle du 1er Congrès du Parti gouvernemental](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/13/1760337945186_ndo_br_img-0787-jpg.webp)

![[Photo] Le secrétaire général To Lam assiste à l'ouverture du 1er Congrès du Parti gouvernemental](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/13/1760321055249_ndo_br_cover-9284-jpg.webp)

Comment (0)