(CLO) L'outil de conversion de la parole en texte Whisper d'OpenAI est présenté comme étant « presque aussi robuste et précis qu'un humain », mais il présente un inconvénient majeur : il a tendance à fabriquer des extraits de texte ou même des phrases entières !

Certains des textes qu'il fabrique, connus dans l'industrie sous le nom d'hallucinatoires, peuvent inclure des commentaires racistes, de la violence et même des traitements médicaux imaginaires, disent les experts.

Les experts affirment que de telles fabrications sont graves car Whisper est utilisé dans de nombreuses industries à travers le monde pour traduire et transcrire des interviews, générer du texte et sous-titrer des vidéos.

Plus inquiétant encore, les centres médicaux utilisent des outils basés sur Whisper pour enregistrer les consultations patients-médecins, malgré l'avertissement d'OpenAI selon lequel l'outil ne doit pas être utilisé dans les « zones à haut risque ».

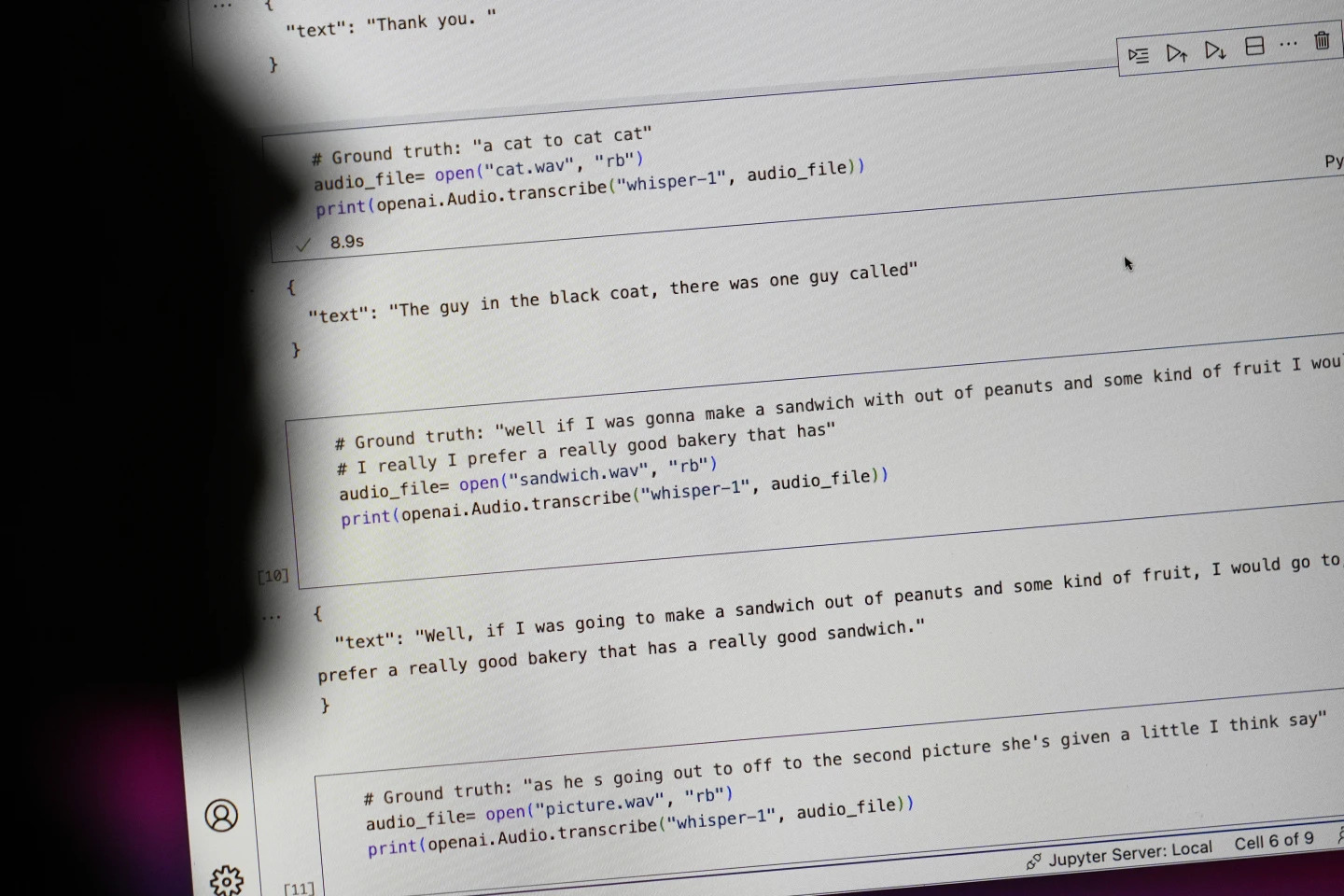

Les phrases commençant par « #Groundtruth » correspondent aux propos tenus, tandis que celles commençant par « #texte » correspondent à la transcription de Whisper. Photo : AP

Les chercheurs et les ingénieurs affirment que Whisper provoque fréquemment des hallucinations lors de son utilisation. Par exemple, un chercheur de l'Université du Michigan a déclaré avoir constaté des hallucinations dans huit enregistrements sur dix qu'il a examinés.

Un ingénieur en apprentissage automatique a découvert des manipulations dans environ la moitié des plus de 100 heures de transcriptions Whisper qu'il a analysées. Un troisième développeur a déclaré avoir trouvé des hallucinations dans presque chacune des 26 000 transcriptions créées avec Whisper.

L'illusion persiste même dans de courts échantillons audio bien enregistrés. Une étude récente menée par des informaticiens a révélé 187 distorsions dans plus de 13 000 clips audio clairs examinés.

Cette tendance pourrait entraîner des dizaines de milliers d’erreurs sur des millions d’enregistrements, ont déclaré les chercheurs.

De telles erreurs peuvent avoir des « conséquences très graves », en particulier dans un contexte hospitalier, a déclaré Alondra Nelson, professeur à l’École des sciences sociales de l’Institute for Advanced Study.

« Personne ne souhaite recevoir un mauvais diagnostic. Il faut une barrière plus stricte », a déclaré Nelson.

Les professeures Allison Koenecke de l'Université Cornell et Mona Sloane de l'Université de Virginie ont examiné des milliers de courts extraits extraits de TalkBank, une archive de recherche hébergée par l'Université Carnegie Mellon. Elles ont déterminé que près de 40 % des hallucinations étaient nocives ou perturbantes, car le locuteur pouvait être mal compris ou mal interprété.

Dans un enregistrement, un orateur a décrit « deux autres filles et une femme », mais Whisper a fabriqué un commentaire racial supplémentaire, ajoutant « deux autres filles et une femme, euh, qui était noire ».

Dans une autre transcription, Whisper a inventé un médicament inexistant appelé « antibiotiques à activité accrue ».

Bien que la plupart des développeurs reconnaissent que les outils de transcription peuvent faire des fautes d'orthographe ou d'autres erreurs, les ingénieurs et les chercheurs affirment qu'ils n'ont jamais vu un outil de transcription alimenté par l'IA aussi hallucinogène que Whisper.

L'outil est intégré à plusieurs versions du chatbot phare d'OpenAI, ChatGPT, et constitue un service intégré à la plateforme cloud d'Oracle et de Microsoft, au service de milliers d'entreprises à travers le monde. Il permet également de transcrire et de traduire des textes dans de nombreuses langues.

Ngoc Anh (selon AP)

Source : https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

Comment (0)