あらゆる角度から攻撃します。

Googleは「Gemini Nano Banana」という新しい人工知能(AI)製品を発表しました。これは文章作成や推論が可能な大規模言語AI(LLM)ではなく、写真編集に特化したAIです。多くのユーザーがこのツールに期待を寄せていますが、いくつかの欠点も抱えています。

「これはAI技術と倫理的制約における『後退』のようなものだ」と、Conductify AIの最高科学責任者であるグエン・ホン・フック氏は個人的な意見を述べた。「Gemini Nano Bananaには効果的な画像編集機能がある。しかし、GoogleがGemini Nano Bananaの検閲を解除し、障壁や制限メカニズムを緩めたことで、このAIは著名人に酷似した画像や、示唆的な画像、センシティブな画像などを作成できるようになった」とフック氏は述べた。

グエン・ホン・フック氏によると、この機能により、ジェミニ・ナノバナナは、AIの専門家でも区別できないほどリアルな偽の画像を作成するツールとなり、有名な政治家との偽の写真を作成して虚偽の情報を拡散したり、個人がAIによって生成された写真操作やソーシャルメディアでの名誉毀損の対象になったりするなど、詐欺やサイバーセキュリティの新たなリスクにつながるとのことだ。

さらに、数十ものAI写真編集ツールがインターネットを席巻する中、ディープフェイク詐欺は止まる気配がありません。セキュリティ組織の統計によると、ディープフェイク技術は、特にビジネスリーダーをはじめとする高価値な個人を狙ったフィッシングキャンペーンを生み出しています。2024年には、世界中で14万~15万件の事例が発生し、その75%がCEOや上級管理職を標的としていました…ディープフェイクは、2027年までに世界の経済損失を32%、年間約400億ドル増加させる可能性があります。

最近、AI企業Anthropicは、海外のハッカーによるサイバー攻撃キャンペーンを検知・阻止しました。このキャンペーンでは、自動化された攻撃活動の調整にAIが利用されていたことが初めて記録されました。具体的には、ハッカーは侵入作戦の計画、指示、展開にAIシステムを使用していました。これはサイバー攻撃キャンペーンの規模と速度を拡大させるリスクがある「懸念すべき」展開です。

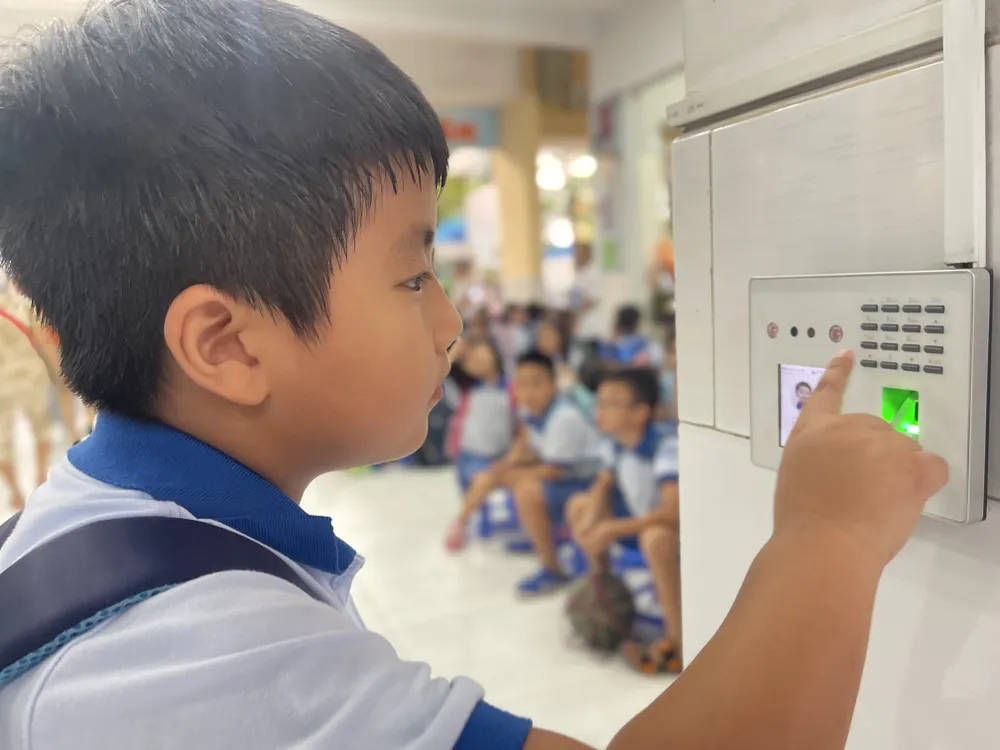

国家サイバーセキュリティ協会の詐欺対策部門ディレクター、ゴ・ミン・ヒュー氏は、AIを統合したツールは、実際の人間による場合と比較して、詐欺の速度を約20倍向上させると述べました。詐欺師はAIに詐欺シナリオを提供して分析を行うと、システムは即座に被害者と自動的にチャットを開始します。AIは初期データから被害者の希望を理解し、リアルタイムでコミュニケーションを取ることができます。最も巧妙な手口は「中間者攻撃」です。これは、ユーザーがビデオ認証(顔の録画や指示など)を行う際に、ハッカーが介入して送信データを妨害するものです。サイバー犯罪者は、事前に用意されたディープフェイク動画を挿入し、ユーザーの実際のデータストリームを置き換えて認証プロセスを回避します。この手法により、銀行や金融機関のセキュリティシステムも欺かれるリスクにさらされています。

より優れたデータ管理

AIの普及が進むにつれ、セキュリティとプライバシーのリスクも大幅に増加しています。リモートサーバーに保存・処理されるデータは、ハッカーやサイバー犯罪者にとって魅力的な標的となるでしょう。全米サイバーセキュリティ協会(National Cyber Security Association)のデータによると、2025年第2四半期だけでもAIを活用したサイバー攻撃の件数は62%増加し、世界全体で最大180億ドルの損失が発生しています。

専門家はデータ保護が極めて重要だと考えています。しかしながら、多くの「ブラックマーケット」プラットフォームでは、月額わずか20ドルという低価格でデータの収集と販売が公然と行われています。サイバー犯罪者は、言語モデルを模倣しながらも犯罪目的にカスタマイズされたツールを悪用することがあります。これらのツールは、マルウェアを生成したり、ウイルス対策ソフトウェアを回避したりすることも可能です。

ベトナムでは、2023年4月17日発効の政令第13/2023/ND-CP号により、個人データの保護が規制されています。さらに、2026年1月1日に施行予定の個人データ保護法は、個人データの漏洩や悪用リスクに対処するための、より強力な法的メカニズムを整備するものです。しかし、国家サイバーセキュリティ協会によると、法執行の有効性は、国民の意識向上、企業の責任強化、規制機関の処理能力向上という3つの柱において、依然として強化する必要があるとされています。技術的な対策に加え、一人ひとりが異常な兆候や疑わしい兆候を察知し、危険なデジタルインタラクションから積極的に身を守る能力を身につける必要があります。

カスペルスキーは、ダークAI(標準的なセキュリティ制御の外で動作し、フィッシング、改ざん、サイバー攻撃、データ不正利用などの行為を可能にする大規模言語モデル(LLM)の導入を指す用語)の悪用について警告を発しています。アジア太平洋地域におけるダークAIの台頭により、組織や個人は、ますます巧妙化し、検知が困難になるサイバー攻撃に備える必要があります。

カスペルスキーの中東、トルコ、アフリカ、アジア太平洋地域担当グローバル調査分析チーム(GReAT)責任者であるセルゲイ・ロズキン氏は、現在のAI悪用の兆候の一つとして、ブラックハットGPTモデルの出現を挙げました。ブラックハットGPTモデルとは、マルウェアの作成、大規模攻撃のための巧妙で説得力のあるフィッシングメールの作成、ディープフェイクの音声や動画の作成、さらには模擬攻撃の実行など、非倫理的かつ違法な目的のために特別に開発または改変されたAIモデルです。

カスペルスキーの専門家は、個人および企業に対し、AIが生成するマルウェアを検知する次世代セキュリティソリューションを活用し、データ保護を最優先することを推奨しています。企業は、AIによる脆弱性悪用を追跡するためのリアルタイム監視ツールを導入し、AIのダークゾーンへの侵入とデータ漏洩のリスクを抑制するためにアクセス制御と従業員トレーニングを強化し、脅威を監視し、インシデントに迅速に対応するためのサイバーセキュリティオペレーションセンターを設置する必要があります。

出典: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

コメント (0)