Penipuan yang melibatkan peniruan suara dengan suara palsu

Dalam era kecerdasan buatan yang pesat membangun, suara – yang dahulunya dianggap sebagai bukti yang boleh dipercayai – kini telah menjadi alat berbahaya di tangan penjenayah. Teknologi suara Deepfake membolehkan penciptaan suara yang hampir tidak dapat dibezakan daripada orang sebenar, membolehkan panggilan penipuan canggih yang bertujuan untuk menipu dan mencuri aset.

Mengapakah suara deepfake begitu menakutkan?

Suara Deepfake ialah teknologi yang menggunakan kecerdasan buatan (AI) dan pembelajaran mesin untuk mencipta suara palsu yang kedengaran sama seperti suara orang sebenar.

Dengan bantuan model moden seperti Tacotron, WaveNet, ElevenLabs atau platform pengklonan suara seperti Reppeecher, penjenayah hanya memerlukan 3-10 saat sampel suara untuk mencipta deepfake yang 95% boleh dipercayai.

Suara deepfake amat berbahaya kerana keupayaannya meniru pertuturan dengan hampir sempurna, daripada sebutan dan intonasi hinggalah kepada corak pertuturan unik setiap individu.

Ini menyukarkan mangsa untuk membezakan antara suara sebenar dan palsu, terutamanya apabila suara itu milik saudara mara, rakan atau pihak atasan.

Mengeksploitasi rakaman suara juga sangat mudah, kerana pada masa kini kebanyakan orang mendedahkan audio mereka melalui platform seperti TikTok, strim langsung media sosial, podcast atau mesyuarat dalam talian. Lebih membimbangkan, suara palsu yang tidak dikenali tidak meninggalkan kesan visual seperti imej atau video , menyukarkan siasatan dan mangsa mudah kehilangan wang.

Deepfake boleh dihasilkan hanya dengan beberapa saat sampel suara.

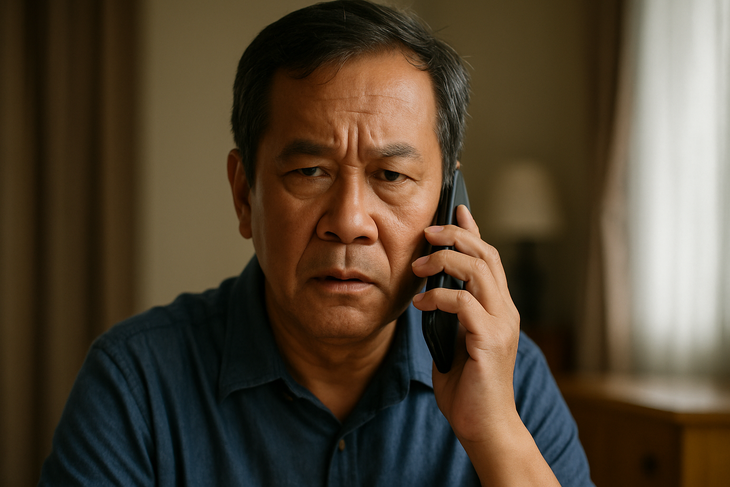

Penipuan suara Deepfake menjadi semakin canggih, selalunya menggunakan skrip yang biasa: menyamar sebagai kenalan dalam situasi kecemasan untuk menimbulkan panik dan memberi tekanan kepada mangsa agar memindahkan wang dengan segera.

Di Vietnam, terdapat kes-kes ibu-ibu yang menerima panggilan daripada "anak lelaki mereka" yang mendakwa telah mengalami kemalangan dan memerlukan wang dengan segera. Di UK, seorang pengarah syarikat telah ditipu lebih $240,000 selepas mendengar "bosnya" meminta pemindahan wang melalui telefon. Seorang pekerja pentadbiran juga telah ditipu apabila dia menerima panggilan daripada "bos kanan" yang meminta bayaran untuk "rakan kongsi strategik"...

Benang merah dalam situasi ini adalah suara palsu itu dihasilkan semula agar kedengaran seperti saudara atau orang atasan, menyebabkan mangsa mempercayainya sepenuhnya dan tidak memberi mereka masa untuk mengesahkannya.

Sentiasa sahkan, jangan percaya serta-merta.

Memandangkan peningkatan penipuan suara palsu yang semakin meningkat, orang ramai dinasihatkan untuk tidak memindahkan wang hanya berdasarkan panggilan suara, walaupun suara itu kedengaran seperti saudara mara. Sebaliknya, hubungi semula nombor asal atau sahkan maklumat tersebut melalui pelbagai saluran sebelum membuat sebarang transaksi.

Ramai pakar juga mengesyorkan untuk menyediakan "kata laluan dalaman" dalam keluarga atau perniagaan untuk pengesahan dalam situasi yang luar biasa.

Tambahan pula, adalah perlu untuk mengehadkan muat naik video dengan audio yang jelas ke media sosial, terutamanya kandungan yang panjang. Amaran dan panduan proaktif khususnya harus diberikan kepada kumpulan yang terdedah seperti warga emas atau mereka yang mempunyai akses terhad kepada teknologi, kerana mereka ini adalah sasaran utama penipuan teknologi tinggi.

Suara keluarga, rakan-rakan dan rakan sekerja semuanya boleh dipalsukan.

Di banyak negara, pihak berkuasa telah mula mengetatkan peraturan teknologi deepfake melalui rangka kerja perundangan mereka sendiri.

Di AS, beberapa negeri telah mengharamkan penggunaan deepfake dalam kempen pilihan raya atau untuk menyebarkan maklumat salah. Kesatuan Eropah (EU) meluluskan Akta AI, yang mewajibkan organisasi bersikap telus dan memberikan amaran yang jelas jika kandungan dicipta menggunakan kecerdasan buatan.

Sementara itu, di Vietnam, walaupun tiada peraturan khusus untuk suara-suara deepfake, tindakan berkaitan boleh didakwa di bawah undang-undang semasa, dengan tuduhan seperti penipuan, pencerobohan privasi atau penyamaran identiti.

Walau bagaimanapun, realitinya ialah teknologi sedang berkembang pada kadar yang jauh melebihi kapasiti pemantauan undang-undang, meninggalkan banyak kelemahan yang boleh dieksploitasi oleh pelaku yang berniat jahat.

Apabila suara bukan lagi bukti

Suara-suara dahulunya berkait rapat dan dipercayai dengan bukti, tetapi dengan suara-suara palsu, ia bukan lagi bukti yang boleh dipercayai. Pada zaman AI, individu memerlukan pengetahuan pertahanan digital, pengesahan proaktif dan kewaspadaan berterusan kerana panggilan boleh menjadi perangkap.

Sumber: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

Komen (0)