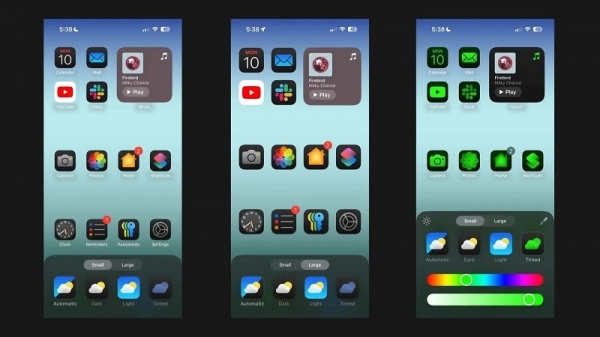

Ifølge Android Authority beskriver Apples forskningsartikkel en løsning for å kjøre store språkmodeller (LLM-er) på enheter med begrenset RAM. Artikkelen avslører hvordan selskapet kan lagre «modellparametere» og laste inn en del av dem i enhetens RAM når det er nødvendig, i stedet for å laste inn hele modellen i RAM-en.

Apple ønsker å hjelpe eldre iPhoner med mindre RAM med å kjøre generell AI

Artikkelen hevder at denne metoden tillater å kjøre modeller som krever dobbelt så mye RAM som en iPhone kan ha, samtidig som den sikrer 4–5x og 20–25x inferenshastigheter sammenlignet med enkle lastemetoder på henholdsvis CPU og GPU.

Det ville være en stor fordel å implementere syntetisk AI på en enhet med mer RAM, fordi det ville gi raskere lese-/skrivehastigheter. Hastighet er viktig for AI på enheten, noe som gir mye raskere inferenstider fordi brukere ikke nødvendigvis trenger å vente i titalls sekunder (eller mer) på et svar eller et endelig resultat. Alt dette betyr at en AI-assistent på enheten potensielt kan kjøre med samtalehastigheter, generere bilder/tekst mye raskere, oppsummere artikler raskere, osv. Men Apples løsning betyr at brukere ikke nødvendigvis trenger mye RAM for å øke hastigheten på AI-oppgaveresponsen på enheten.

Apples tilnærming kan gjøre det mulig for både gamle og nye iPhoner å tilby syntetiske AI-funksjoner rett på enhetene sine. Det er viktig fordi Apples iPhoner vanligvis tilbyr mindre RAM enn avanserte Android-telefoner. iPhone 11-serien tilbyr for eksempel bare 4 GB RAM, mens selv den vanlige iPhone 15 bare har 6 GB.

Apple er ikke det eneste mobilselskapet som jobber med å krympe LLM. Både Qualcomm og MediaTeks nye flaggskipbrikker støtter INT4-presisjon for å krympe disse modellene. Uansett prøver selskaper å finne nye måter å redusere systemkravene for AI på enhetene, slik at selv rimeligere telefoner kan tilby funksjonen.

[annonse_2]

Kildekobling

![[Foto] Tilbedelse av Tuyet Son-statuen – en nesten 400 år gammel skatt ved Keo-pagoden](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764679323086_ndo_br_tempimageomw0hi-4884-jpg.webp&w=3840&q=75)

![[Foto] Parade for å feire 50-årsjubileet for Laos' nasjonaldag](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

Kommentar (0)