O Departamento de Segurança da Informação emitiu recentemente um alerta sobre a recorrência contínua de fraudes de vídeo e imagem de alta tecnologia.

Assim, a situação de cibercriminosos que se aproveitam de imagens e vídeos públicos de pessoas para editar, cortar e ameaçar com chantagem por meio de vídeos falsos tem sido amplamente alertada pelas autoridades a um grande número de pessoas.

Utilizando a tecnologia Deepfake, que permite a reprodução da voz e da imagem de uma pessoa com alta precisão, criminosos podem se passar por líderes em reuniões online ou criar vídeos e chamadas para cometer fraudes financeiras.

Além disso, esses golpes frequentemente exploram fatores psicológicos como urgência, medo ou poder, levando as vítimas a agirem precipitadamente sem verificar cuidadosamente a autenticidade.

Os deepfakes não se limitam a golpes financeiros. Outro exemplo são os golpes românticos, nos quais os deepfakes são usados para criar personagens fictícios que interagem com as vítimas por meio de videochamadas; após ganhar a confiança da vítima, o golpista solicita transferências de dinheiro para resolver emergências, despesas de viagem ou empréstimos.

Diante da situação acima, o Departamento de Segurança da Informação recomenda que as pessoas desconfiem de conselhos de investimento de celebridades nas redes sociais; fiquem atentas a mensagens, e-mails ou ligações de remetentes desconhecidos; e observem atentamente expressões faciais incomuns em vídeos.

As pessoas também precisam limitar a publicação de conteúdo relacionado a informações pessoais nas redes sociais para evitar que informações como imagens, vídeos ou áudios sejam roubadas por pessoas mal-intencionadas; ao mesmo tempo, devem configurar suas contas no modo privado para proteger as informações pessoais.

Em entrevista ao jornal Dai Doan Ket, o especialista em segurança cibernética Ngo Minh Hieu, cofundador do Projeto de Prevenção de Fraudes Cibernéticas do Vietnã (Chongluadao.vn), afirmou que o uso da tecnologia Deepfake em inteligência artificial para simular videochamadas com o objetivo de fraudar ainda é complexo. Os criminosos exploram essa tecnologia para aumentar a credibilidade de suas vítimas.

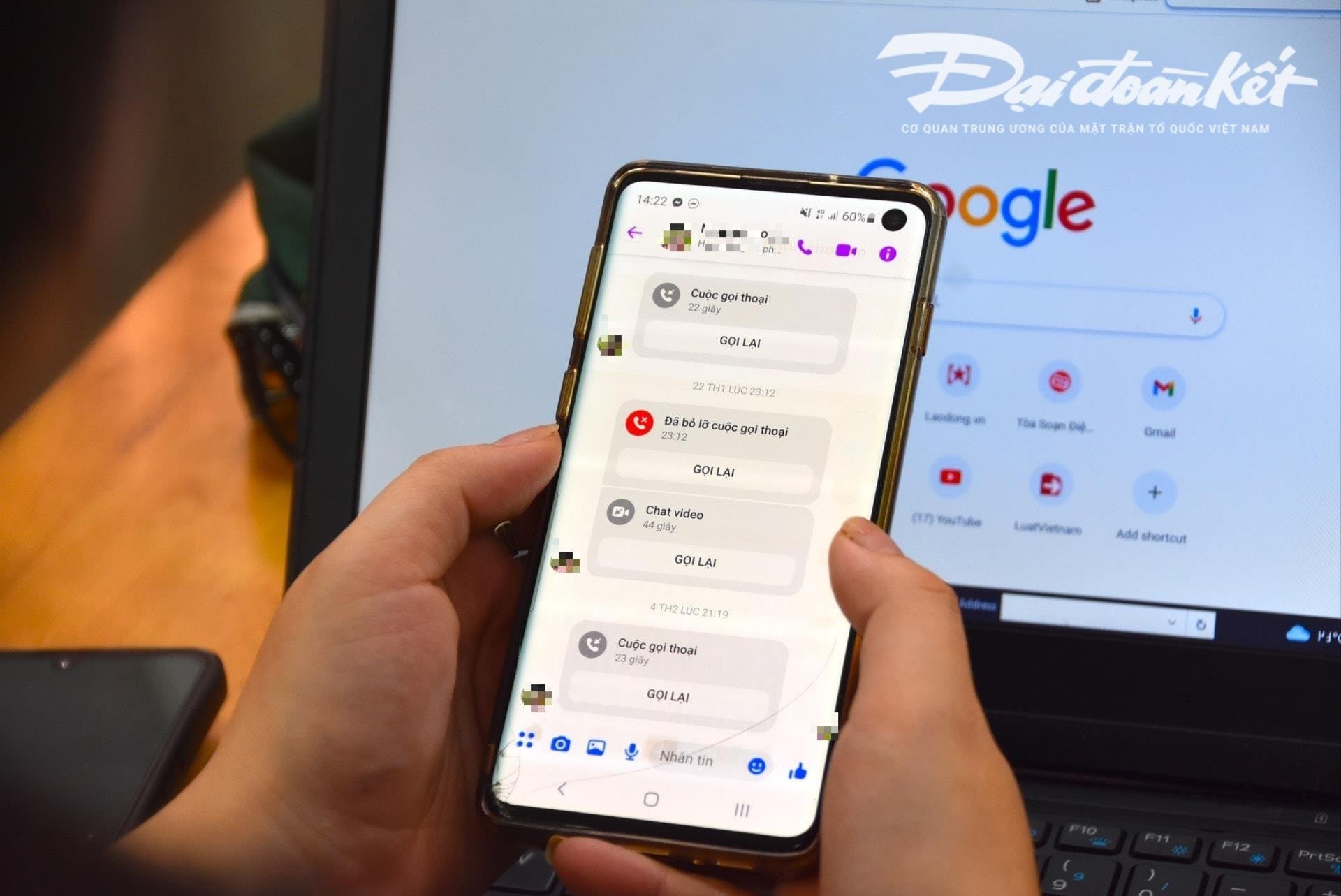

Especificamente, os indivíduos farão chamadas de vídeo proativas para as vítimas a partir de imagens e vídeos previamente "roubados" e manipularão a técnica, distorcendo o som ou simulando problemas de imagem para ganhar a confiança da vítima.

Geralmente, essas ligações são muito curtas, durando apenas alguns segundos, e então os golpistas usam a desculpa de uma rede instável, de estarem na rua, etc., para pedir à vítima que atenda às suas solicitações.

Especialistas alertam que o uso de IA para fraudes cibernéticas provavelmente aumentará significativamente em um futuro próximo. Portanto, as pessoas devem aumentar proativamente sua vigilância, especialmente ao receber mensagens, videochamadas e links suspeitos.

Segundo a análise deste especialista, o atual algoritmo de inteligência artificial (IA) Deepfake, utilizado em chamadas em tempo real, não conseguirá lidar com situações em que o interlocutor se vire para a esquerda, para a direita ou se levante.

Uma fragilidade específica à qual as pessoas precisam estar atentas ao receberem essas ligações é o sorriso. Os algoritmos de IA atuais não conseguem reproduzir os dentes da pessoa que está sendo imitada.

Ao usar Deepfake, a imagem da pessoa abrindo a boca pode não mostrar dentes, enquanto outras podem ter três ou até quatro mandíbulas. Portanto, a característica dos dentes é o elemento mais reconhecível em uma chamada falsa criada com Deepfake.

Para evitar cair em golpes, é fundamental "ter calma" e não atender imediatamente às solicitações. Ao receber qualquer mensagem ou ligação pelas redes sociais, é preciso ligar para um parente próximo para verificar quem está entrando em contato, aguardando no mínimo 30 segundos, ou marcar um encontro pessoalmente.

Em caso de suspeita de usurpação de identidade de familiares em redes sociais para fins de fraude ou apropriação indébita, é necessário comunicar imediatamente o ocorrido à delegacia de polícia mais próxima para que sejam tomadas as devidas providências.

Fonte: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[Foto] Cat Ba - Paraíso da ilha verde](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[Vídeo] O Vietnã é pioneiro na criação de um arcabouço legal para a inteligência artificial.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/05/1764896569407_1764674648895-jpg.webp)

![[VIMC 40 dias de velocidade relâmpago] Porto de Da Nang: Unidade - Velocidade relâmpago - Rumo à linha de chegada](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764833540882_cdn_4-12-25.jpeg)

Comentário (0)