Согласно BGR , 2024 год станет поворотным для мира , когда станет ясно, является ли искусственный интеллект действительно будущим вычислительной техники или всего лишь мимолетной модой. Хотя реальные области применения ИИ становятся все более разнообразными, в ближайшие месяцы также проявится и темная сторона этой технологии в виде бесчисленных мошеннических схем.

Эксперты Scams.info по борьбе с мошенничеством только что опубликовали список из 3 мошеннических схем, использующих искусственный интеллект, которых следует опасаться в 2024 году. Общее правило — с осторожностью относиться ко всему, что выглядит слишком привлекательно, но схемы, перечисленные ниже, требуют особенно повышенной бдительности.

Мошенничество с инвестициями на основе ИИ

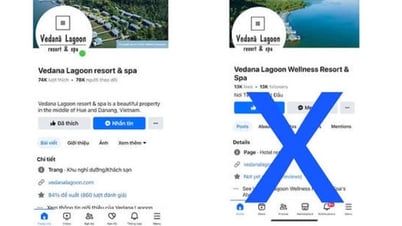

Крупные игроки, такие как Google, Microsoft и OpenAI, вложили миллионы долларов в искусственный интеллект и продолжат активно инвестировать в этом году. Мошенники воспользуются этим фактом, чтобы заманить вас в сомнительные проекты. Если кто-то в социальных сетях пытается убедить вас, что ИИ многократно увеличит доходность ваших инвестиций, хорошо подумайте, прежде чем открывать кошелек.

«Выгодных предложений» и инвестиций с низким риском на самом деле не существует.

«Остерегайтесь инвестиций, обещающих высокую доходность при низком риске, и обязательно проведите тщательное исследование, прежде чем вкладывать в них свои деньги», — предупреждает эксперт Николас Крауч из Scams.info. Новым инвесторам также следует с осторожностью относиться к предложениям, требующим привлечения новых участников; такие предложения часто работают по модели многоуровневого маркетинга (MLM), принося выгоду только тем, кто находится на вершине, в то время как другие участники редко получают прибыль.

Выдача себя за родственника

Мошенничество с выдачей себя за друзей или родственников с целью заимствования денег — не новость, поскольку имитация голоса не очень эффективна. Однако с появлением искусственного интеллекта этот вид мошенничества становится гораздо более коварным. Достаточно видео на YouTube или публикации в Facebook, содержащей голос родственника, и мошенник с помощью ИИ может идеально его воспроизвести. Смогли бы вы отличить его от реального голоса во время телефонного разговора?

Искусственный интеллект с легкостью может имитировать голоса ваших близких.

Скриншот из Washington Post

«Крайне важно, чтобы люди защищали свои аккаунты в социальных сетях, чтобы предотвратить сбор мошенниками голосовых записей и информации о членах семьи», — подчеркнул Крауч.

Использование голосовых команд для обхода систем безопасности.

Некоторые банки используют распознавание голоса для проверки личности пользователей при проведении операций по телефону. По указанным выше причинам этот метод внезапно стал менее безопасным, чем раньше. Если вы разместите видео или клипы со своим голосом где-либо в интернете, злоумышленники могут использовать этот контент для копирования вашего голоса. Как отмечает Крауч, у банков по-прежнему есть другие данные для проверки личности клиентов, но эта тактика приближает преступников к краже вашего банковского счета.

Системы безопасности, основанные на голосовом управлении, больше не защищены от возможностей искусственного интеллекта.

Искусственный интеллект способен коренным образом изменить нашу жизнь и то, как мы взаимодействуем с устройствами. Кроме того, это новейший инструмент, который хакеры и мошенники будут использовать для атак на пользователей. Поэтому крайне важно сохранять бдительность и проводить тщательное исследование, прежде чем заниматься какой-либо деятельностью, связанной с ИИ.

Ссылка на источник

![[Фото] Премьер-министр Фам Минь Чинь принимает губернатора провинции Тотиги (Япония)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Прямая трансляция] Гала-церемония вручения наград за общественную деятельность 2025 года](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Изображение] Утекшие в сеть фотографии в преддверии гала-церемонии вручения премии Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Фото] Премьер-министр Фам Минь Чинь принимает министра образования и спорта Лаоса Тонгсалит Мангнормек.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Фото] Премьер-министр Фам Минь Чинь принял участие во Вьетнамском экономическом форуме 2025 года](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/16/1765893035503_ndo_br_dsc-8043-jpg.webp)

Комментарий (0)