(CLO) Инструмент преобразования речи в текст Whisper от OpenAI рекламируется как «надежный и точный, близкий к человеческому уровню», но у него есть один существенный недостаток: он склонен к подделке фрагментов текста или даже целых предложений!

По словам экспертов, некоторые из сфабрикованных ею текстов, известных в индустрии как галлюцинаторные, могут включать расистские комментарии, сцены насилия и даже вымышленные методы лечения .

Эксперты говорят, что подобные фальсификации серьезны, поскольку Whisper используется во многих отраслях по всему миру для перевода и расшифровки интервью, создания текстов и субтитров к видеороликам.

Еще большую тревогу вызывает тот факт, что медицинские центры используют инструменты на базе Whisper для записи консультаций пациентов с врачами, несмотря на предупреждение OpenAI о том, что этот инструмент не следует использовать в «зонах повышенного риска».

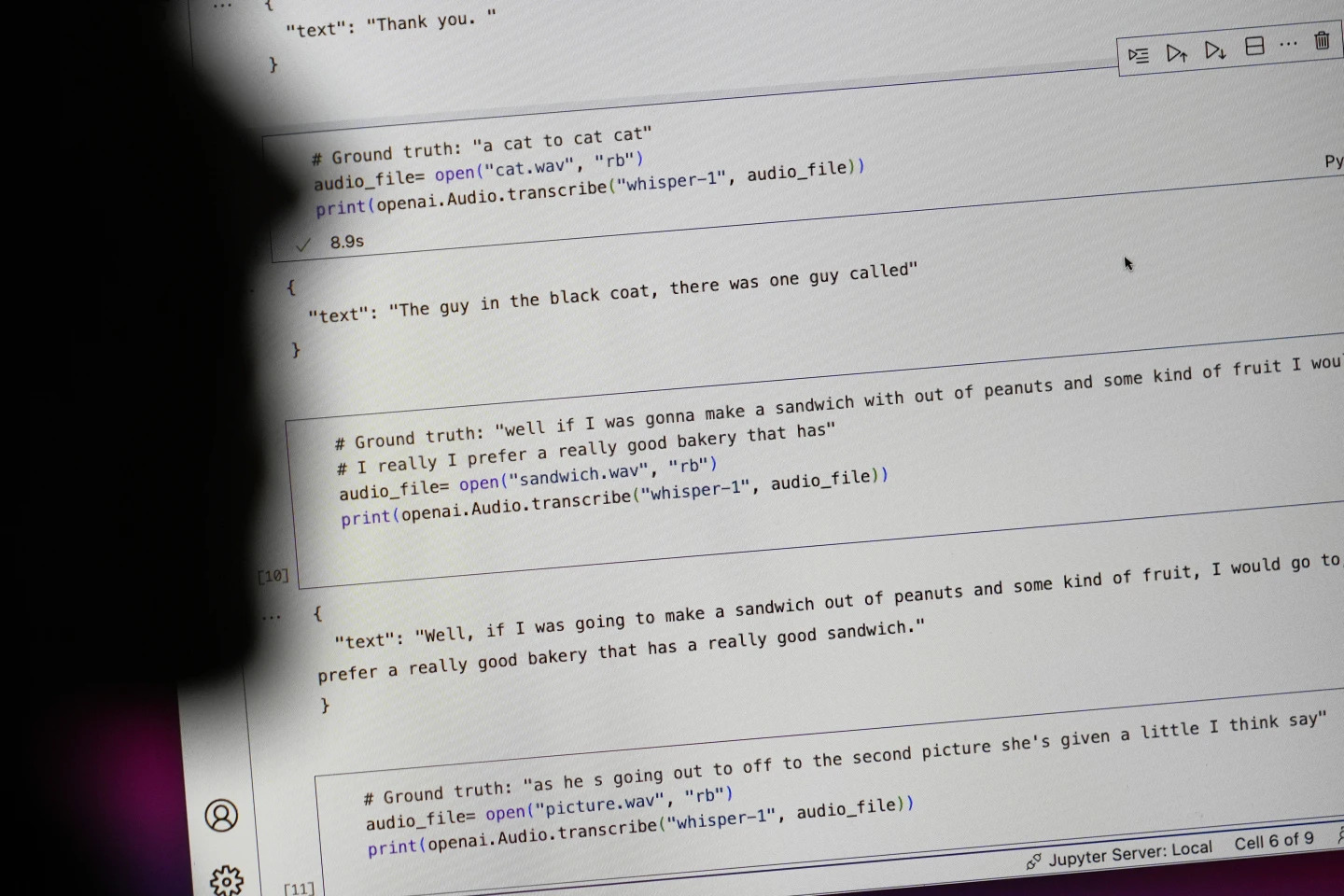

Предложения, начинающиеся с «#Ground truth», — это то, что было сказано на самом деле, предложения, начинающиеся с «#text», — это то, что Whisper расшифровал. Фото: AP

Исследователи и инженеры утверждают, что Whisper часто вызывает галлюцинации во время использования. Например, исследователь из Мичиганского университета заявил, что обнаружил галлюцинации в восьми из десяти изученных им записей.

Один из первых инженеров, занимающихся машинным обучением, обнаружил манипуляции примерно в половине из более чем 100 часов проанализированных им расшифровок Whisper. Третий разработчик сообщил, что обнаружил галлюцинации почти в каждой из 26 000 расшифровок, созданных с помощью Whisper.

Эта иллюзия сохраняется даже в коротких, качественно записанных аудиофрагментах. Недавнее исследование, проведённое учёными в области компьютерных технологий, выявило 187 искажений в более чем 13 000 изученных ими чистых аудиозаписях.

Исследователи утверждают, что эта тенденция может привести к десяткам тысяч ошибок в миллионах записей.

По словам Алондры Нельсон, профессора Школы социальных наук Института перспективных исследований, такие ошибки могут иметь «действительно серьезные последствия», особенно в условиях больницы.

«Никто не хочет получить неправильный диагноз. Необходимо установить более высокий барьер», — сказал Нельсон.

Профессора Эллисон Кёнеке из Корнеллского университета и Мона Слоун из Вирджинского университета изучили тысячи коротких отрывков, полученных из TalkBank, исследовательского архива Университета Карнеги — Меллона. Они установили, что почти 40% галлюцинаций были вредными или тревожными, поскольку говорящий мог быть неправильно понят или искажен.

В одной из записей говорящий описал «двух других девушек и женщину», но Уиспер выдумал дополнительные расистские комментарии, добавив «двух других девушек и женщину, которая была чернокожей».

В другой транскрипции Уиспер изобрел несуществующий препарат под названием «антибиотики с повышенной активностью».

Хотя большинство разработчиков признают, что инструменты транскрипции могут допускать орфографические ошибки или другие ошибки, инженеры и исследователи утверждают, что никогда не видели инструмента транскрипции на базе ИИ, столь галлюциногенного, как Whisper.

Этот инструмент интегрирован в несколько версий флагманского чат-бота OpenAI, ChatGPT, и представляет собой интегрированный сервис на платформе облачных вычислений Oracle и Microsoft, обслуживающий тысячи компаний по всему миру. Он также используется для транскрибирования и перевода текстов на многие языки.

Нгок Ань (по данным AP)

Источник: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Фото] Церемония закрытия XVIII съезда Ханойского партийного комитета](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/17/1760704850107_ndo_br_1-jpg.webp)

![[Фото] Газета «Нхан Дан» запускает «Отечество в сердце: фильм-концерт»](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/16/1760622132545_thiet-ke-chua-co-ten-36-png.webp)

Комментарий (0)