Бурное развитие искусственного интеллекта (ИИ) приносит человечеству огромную пользу, но также влечет за собой бесчисленные последствия: от расовых предрассудков и изощренного мошенничества в Интернете до риска превращения развивающихся стран в дешевые «информационные шахты».

Учитывая эту реальность, должно ли ответственное использование ИИ быть добровольным или обязательным? Что следует сделать Вьетнаму, создавая легальный коридор для этой области?

В кулуарах Недели науки и технологий VinFuture корреспондент побеседовал с профессором Тоби Уолшем из Университета Нового Южного Уэльса (Австралия), академиком Американского компьютерного общества.

Профессор предлагает идеи о том, как мы «ведём себя» с ИИ: от привлечения «машин» к ответственности до советов семьям по защите от волны мошенничества в сфере высоких технологий.

Кто отвечает за ИИ?

Профессор, должно ли ответственное использование ИИ быть добровольным или обязательным? И как нам следует вести себя по отношению к ИИ?

— Я твёрдо убеждён, что ответственное использование ИИ должно быть обязательным . Здесь действуют порочные стимулы , на ИИ зарабатываются огромные деньги, и единственный способ обеспечить надлежащее поведение — это ввести строгие правила , чтобы общественные интересы всегда были сбалансированы с коммерческими .

Кто несёт ответственность, когда ИИ совершает ошибку? Есть ли у нас возможность исправить механизмы работы ИИ-агентов, особенно в случае с ними?

Основная проблема ошибок ИИ заключается в том, что мы не можем привлечь ИИ к ответственности. ИИ — не человек, и это недостаток любой правовой системы в мире . Только люди могут нести ответственность за свои решения и действия.

Внезапно у нас появляется новый «агент», ИИ, который может — если мы ему позволим — принимать решения и совершать действия в нашем мире, что создает проблему: кого мы привлечем к ответственности?

Ответ таков: компании, которые внедряют и эксплуатируют системы ИИ, должны нести ответственность за последствия, которые вызывают эти «машины».

Многие компании также говорят об ответственном ИИ. Как им можно доверять? Откуда нам знать, что они серьёзны и всесторонне развивают свои идеи, а не просто используют «ответственный ИИ» как маркетинговый ход?

— Нам необходимо повысить прозрачность. Важно понимать возможности и ограничения систем искусственного интеллекта. Мы также должны «голосовать действием», то есть ответственно выбирать использование услуг.

Я искренне верю, что ответственное использование ИИ станет фактором, определяющим успех компаний на рынке, и даст им коммерческое преимущество.

Если компания уважает данные клиентов, это принесёт ей пользу и привлечёт новых клиентов. Компании поймут, что поступать правильно не только этично, но и способствует их успеху. Я рассматриваю это как способ выделить компании, и именно с ответственными компаниями нам будет комфортно сотрудничать.

Вьетнаму необходимо активно защищать культурные ценности.

Вьетнам — одна из немногих стран, рассматривающих возможность принятия Закона об искусственном интеллекте. Как вы оцениваете его? Какие, по вашему мнению, проблемы этики и безопасности при разработке ИИ существуют для развивающихся стран, таких как Вьетнам?

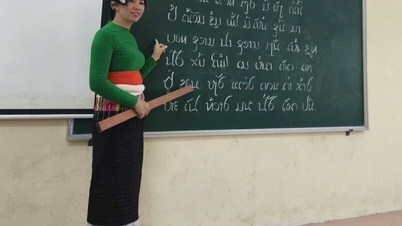

— Я очень рад, что Вьетнам стал одной из стран-первопроходцев, принявших специализированный закон об искусственном интеллекте. Это важно, поскольку у каждой страны есть свои ценности и культура, и им нужны законы, защищающие эти ценности.

Вьетнамские ценности и культура отличаются от австралийских, китайских и американских. Мы не можем ожидать, что китайские или американские технологические компании будут автоматически защищать вьетнамскую культуру и язык. Вьетнам должен взять на себя инициативу по защите этих ценностей.

Я помню, что в прошлом многие развивающиеся страны пережили период физической колонизации. Если мы не будем осторожны, нас может ожидать период «цифровой колонизации». Ваши данные будут эксплуатироваться, и вы станете дешёвым ресурсом.

Это окажется под угрозой, если развивающиеся страны будут развивать отрасль ИИ таким образом, чтобы эксплуатировать только данные, не контролируя и не защищая собственные интересы.

Как же выйти из этой ситуации?

— Всё просто: инвестируйте в людей. Повышайте квалификацию сотрудников, убедитесь, что они разбираются в ИИ. Поддерживайте предпринимателей, компании, занимающиеся ИИ, поддерживайте университеты. Будьте активны. Вместо того, чтобы ждать, пока другие страны передадут нам технологии или направят нас, мы сами должны быть активны и осваивать технологии.

Профессор Тоби Уолш выступает на Неделе науки и технологий VinFuture (Фото: Оргкомитет).

Во-вторых, нам необходимо решительно выступать за создание платформами социальных сетей безопасной среды для пользователей во Вьетнаме, не нанося при этом ущерба демократии в стране.

На самом деле существует множество примеров того, как контент социальных сетей влиял на результаты выборов, разделял страны и даже подстрекал к терроризму.

Я посвятил 40 лет работе над искусственным интеллектом. Первые 30 лет меня волновал вопрос, как сделать ИИ более мощным. В последние 10 лет я всё больше интересуюсь и выступаю за ответственную разработку ИИ.

Можете ли вы дать несколько советов, поскольку Вьетнам находится в процессе разработки закона об искусственном интеллекте?

— Во многих случаях новые законы не нужны. У нас уже есть законы о конфиденциальности, законы о конкуренции. Эти существующие законы применяются к цифровому пространству так же, как и к физическому миру.

Важно обеспечить соблюдение этих законов в цифровой среде так же строго, как и в физической среде.

Однако появляются новые риски, и мы начинаем это замечать. Люди начинают выстраивать отношения с ИИ, используя его в качестве терапевта, и иногда это может причинить вред пользователям, поэтому нам нужно быть осторожными.

Мы всегда привлекаем производителей к ответственности за выпуск продукции. Например, если компании, занимающиеся разработкой ИИ, выпускают продукты с использованием ИИ, наносящие вред людям, они также должны нести ответственность.

Итак, как мы можем предотвратить вредное воздействие ИИ на детей и создать безопасную среду для детей всякий раз, когда появляется ИИ, сэр?

— Я думаю, мы не извлекли много уроков из социальных сетей. Многие страны сейчас начинают понимать, что социальные сети имеют как огромные преимущества, так и множество недостатков, особенно в плане влияния на психическое здоровье, уровень тревожности и восприятие своего тела молодыми людьми, особенно девушками.

Многие страны уже начали принимать меры для решения этой проблемы. В Австралии возрастной ценз для использования социальных сетей вступит в силу 10 декабря. Думаю, нам нужны аналогичные меры и для искусственного интеллекта.

Мы создаем инструменты, которые могут оказывать положительное влияние, но также могут причинить вред, и нам необходимо защитить умы и сердца наших детей от этого негативного воздействия.

Кроме того, я надеюсь, что страны также примут строгие правила по управлению социальными сетями, тем самым создав по-настоящему безопасную среду для всех при использовании ИИ.

На самом деле, с рисками, связанными с самим ИИ, сталкиваются не только дети, но и взрослые. Как же люди могут использовать ИИ, чтобы улучшить свою жизнь и при этом не представлять опасности?

— ИИ применяется во многих областях, помогая улучшить качество нашей жизни. В медицине ИИ помогает открывать новые лекарства. В образовании ИИ также приносит множество положительных результатов.

Однако предоставление доступа к ИИ без адекватных мер защиты слишком рискованно. В США мы видели судебные иски, в которых родители подавали в суд на технологические компании, доведшие их детей до самоубийства после взаимодействия с чат-ботами на базе ИИ.

Хотя процент пользователей ChatGPT, испытывающих проблемы с психическим здоровьем, составляет всего несколько процентов, при сотнях миллионов пользователей реальное число таких людей исчисляется сотнями тысяч.

Данные очень важны для разработки ИИ, но с точки зрения управления, слишком строгое управление данными будет препятствовать развитию ИИ. Какие опасности, по вашему мнению, может повлечь ослабление управления данными? Как найти баланс между сбором данных, безопасным управлением данными и разработкой ИИ?

— Полностью согласен. Данные — основа прогресса искусственного интеллекта , поскольку именно данные его движут. Без данных мы не добьёмся никакого прогресса. Высококачественные данные — основа всего, что мы делаем. Фактически, коммерческая ценность и конкурентное преимущество компаний зависят от данных. Ключевой вопрос — качественные ли у нас данные или нет.

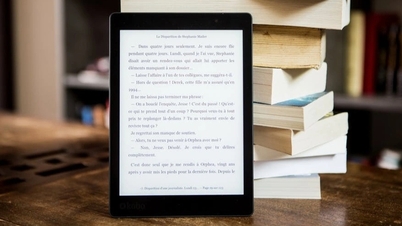

Возмутительно видеть, как книги авторов по всему миру, включая мои, используются без разрешения и без компенсации. Это кража плодов чужого труда. Если так будет продолжаться, авторы потеряют мотивацию писать книги, а мы потеряем культурные ценности, которыми дорожим.

Нам необходимо найти более справедливое решение, чем то, что у нас есть сейчас.

Сейчас «Кремниевая долина» забирает контент и творчество у авторов, не платя за это — это неустойчиво. Я сравниваю текущую ситуацию с Napster и ранним появлением онлайн-музыки в 2000-х. Тогда вся онлайн-музыка была «ворованной», но это не могло длиться вечно, ведь музыкантам нужен был доход, чтобы продолжать творить.

Наконец, у нас есть платные стриминговые сервисы , такие как Spotify или Apple Music, или музыка с рекламой, часть дохода от которой возвращается исполнителю. Нам нужно сделать то же самое с книгами, чтобы авторы получали пользу от своих данных. Иначе ни у кого не будет мотивации писать книги, и мир станет гораздо хуже без новых книг.

В рамках Недели науки и технологий VinFuture в Центре современного искусства Vincom Royal City также пройдет выставка «Toa V – точка соприкосновения науки» (Фото: Оргкомитет).

Искусственный интеллект (ИИ) очень развит во Вьетнаме. В последнее время Вьетнам проводит множество политических мер по его продвижению, но Вьетнам также сталкивается с проблемой мошенничества, связанного с ИИ. По мнению профессора, как Вьетнаму следует действовать в этой ситуации? Что профессор советует тем, кто сегодня использует ИИ для обеспечения безопасности и защиты своих данных?

— Для каждого человека, я думаю, самый простой способ — проверить информацию. Например, при получении телефонного звонка или электронного письма, например, от банка, нам нужно перепроверить информацию: мы можем перезвонить по этому номеру или связаться с банком напрямую, чтобы проверить информацию.

В наши дни существует множество поддельных электронных писем, телефонных номеров и даже звонков в Zoom. Эти способы мошенничества просты, недороги и не занимают много времени.

В моей семье тоже есть своя мера безопасности: «секретный вопрос», который знают только члены семьи, например, имя нашего домашнего кролика. Это гарантирует, что важная информация останется в семье и не будет раскрыта.

Вьетнам также включил обучение ИИ в систему общего образования. На что следует обратить внимание в этом процессе?

— ИИ меняет то, чему и как обучают. Он влияет на важные навыки будущего, такие как критическое мышление, коммуникативные навыки, социальный и эмоциональный интеллект. Эти навыки станут важнейшими.

ИИ может помочь в обучении этим навыкам, например, выступая в роли персонального репетитора, персонального помощника по рецензированию, предоставляя очень эффективные образовательные инструменты с помощью приложений ИИ.

Спасибо, профессор, что нашли время для нашей беседы!

Источник: https://dantri.com.vn/cong-nghe/viet-nam-can-lam-gi-de-tranh-nguy-co-tro-thanh-nguon-luc-re-tien-20251203093314154.htm

![[Фото] Парад в честь 50-летия Национального дня Лаоса](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

![[Фото] Поклонение статуе Тует Сон — почти 400-летнему сокровищу в пагоде Кео](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764679323086_ndo_br_tempimageomw0hi-4884-jpg.webp&w=3840&q=75)

Комментарий (0)