Insbesondere Googles Mutterkonzern Alphabet hat seinen Mitarbeitern geraten, keine vertraulichen Dokumente in KI-Chatbots einzugeben. Quellen aus Alphabet selbst, die Reuters vorliegen, warnte das Unternehmen seine Ingenieure zudem davor, den von Chatbots generierten Computercode direkt zu verwenden.

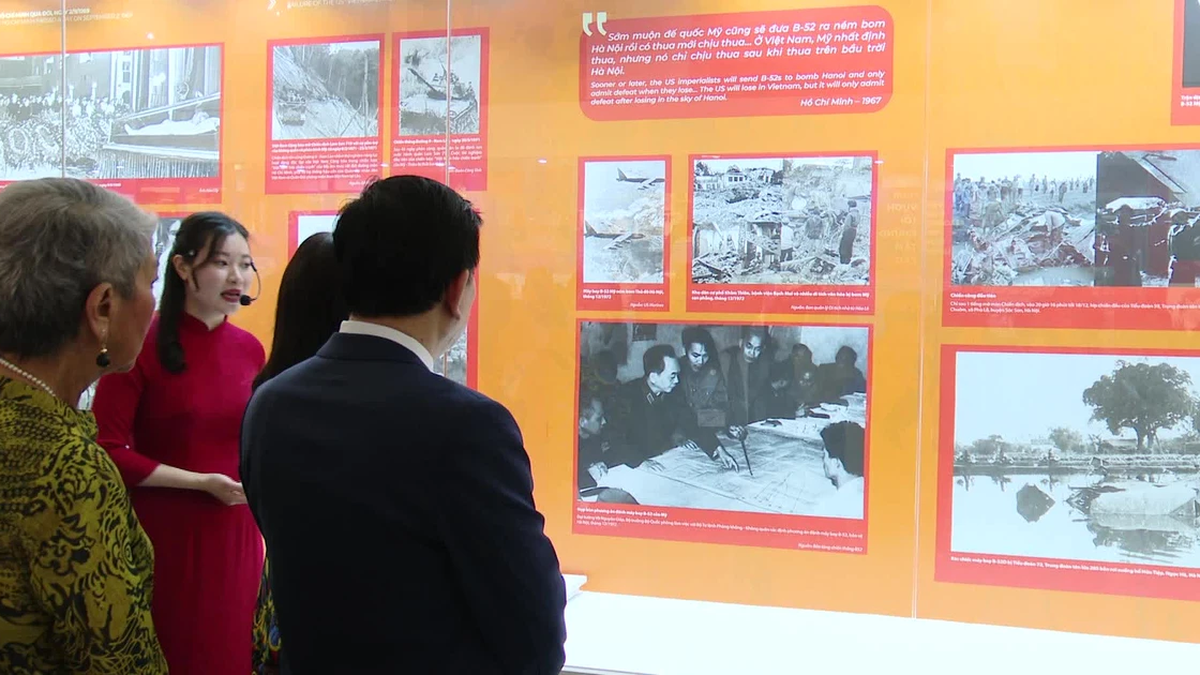

Auch der Tech-Gigant Google ist besorgt über Informationslecks durch seinen eigenen KI-Chatbot. Foto: Reuters

Chatbots wie Bard und ChatGPT sind Programme, die sogenannte allgemeine künstliche Intelligenz nutzen, um menschenähnliche Gespräche mit Nutzern zu führen. Experten warnen, dass Chatbots die Daten, die sie beim Antworten aufnehmen, replizieren können, wodurch das Risiko eines Datenlecks entsteht.

Die Bedenken zeigen, dass Google geschäftliche Schäden durch die Software, die es als Konkurrenz zu ChatGPT auf den Markt bringt, vermeiden möchte. Googles Vorsicht spiegelt auch einen wachsenden globalen Trend der Angst wider, der auch die Warnung von Unternehmen vor der Veröffentlichung von Informationen über Chatbots beinhaltet.

Immer mehr Unternehmen weltweit haben Sicherheitsvorkehrungen für KI-Chatbots getroffen, darunter Samsung, Amazon und die Deutsche Bank.

Laut einer Umfrage der US-Website Fishbowl unter fast 12.000 Personen nutzten im Januar etwa 43 % der Technikexperten ChatGPT oder andere KI-Tools, oft ohne ihren Vorgesetzten davon zu erzählen.

Bereits im Februar hatte Google seinen Mitarbeitern des Chatbots Bard gesagt, sie sollten keine internen Informationen weitergeben, berichtete Insider. Google führt Bard mittlerweile in über 180 Ländern und in 40 Sprachen ein.

Die KI-Technologie von Google wird für Tools eingesetzt, die automatisch E-Mails und Dokumente verfassen und sogar Software erstellen. Diese Aufgaben können jedoch falsche Informationen enthalten und bergen zudem das Risiko eines Informationslecks.

Bui Huy (laut Reuters, Insider)

[Anzeige_2]

Quelle

Kommentar (0)