Продукты ИИ: расизм и предвзятость

По словам экспертов по международному здравоохранению, созданные с помощью искусственного интеллекта изображения таких тем, как бедность, дети и жертвы сексуального насилия, заполоняют онлайн-фотоархивы, и неправительственные организации (НПО) всё чаще их используют. Эксперты предупреждают, что это может означать «новую эру культуры эксплуатации бедности».

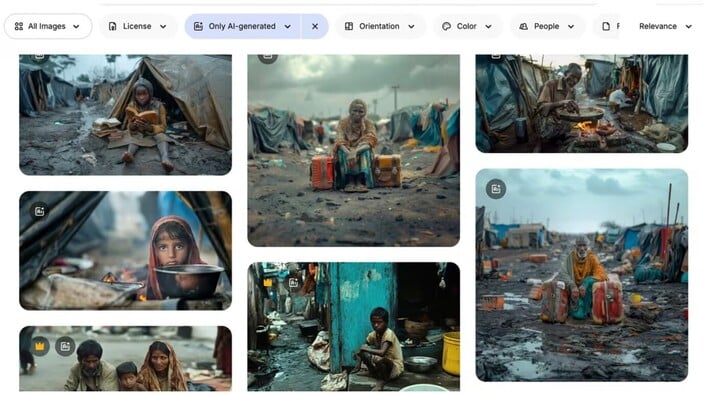

«Эти изображения отражают стандартное представление о бедности — дети, держащие пустые миски, потрескавшаяся земля... очень стереотипно», — сказал Арсений Аленичев, научный сотрудник Института тропической медицины в Антверпене, который изучает создание изображений, связанных со здоровьем в мире .

Г-н Аленичев собрал более 100 созданных с помощью искусственного интеллекта изображений крайней нищеты, которые использовались отдельными лицами или НПО в кампаниях в социальных сетях против голода и сексуального насилия.

На снимках, которыми он поделился с Guardian, изображены преувеличенные, стереотипные сцены: дети, жмущиеся к земле в лужах грязи; африканская девушка в свадебном платье, по лицу которой текут слёзы. В недавнем комментарии, опубликованном в журнале Lancet Global Health, он утверждал, что эти изображения представляют собой «порнографию бедности версии 2.0».

Скриншот с изображением «бедности», созданным искусственным интеллектом на фотосайте. (Фото: Freepik)

Г-н Аленичев и многие другие эксперты отмечают, что использование изображений, созданных с помощью искусственного интеллекта, растёт из-за опасений по поводу авторских прав и расходов. Сокращение правительством США финансирования НПО лишь усугубило эту проблему.

«Очевидно, что многие организации начинают рассматривать возможность использования изображений, созданных с помощью ИИ, вместо реальных фотографий, потому что это дёшево. К тому же, не нужно беспокоиться об авторских правах и многом другом», — сказал он.

На ком лежит ответственность: на пользователе или на платформе?

Изображения бедности, созданные искусственным интеллектом, появляются на десятках фотосайтов, включая Adobe Stock Photos и Freepik. Многие из них сопровождаются подписями: «сюрреалистичный ребёнок в лагере беженцев», «азиатские дети плавают в реке, полной мусора», «белый волонтёр оказывает медицинскую помощь чернокожим детям в африканской деревне» и другими. Adobe продаёт права на последние два изображения из этого списка примерно за 60 фунтов стерлингов.

«Эти фотографии откровенно расистские и не должны публиковаться, поскольку они являются худшим стереотипом об Африке, Индии или о чем угодно, что только можно себе представить», — заявил Аленичев.

Хоакин Абела, генеральный директор Freepik, заявил, что ответственность за использование столь экстремальных изображений лежит на пользователях, а не на платформах, подобных его. По его мнению, стоковые фотографии с искусственным интеллектом создаются глобальным сообществом пользователей, которые могут получать гонорары, когда клиенты Freepik решают купить их фотографии.

Freepik пытается бороться с предвзятостью, присущей его фотобиблиотекам, «внедряя разнообразие». В то же время компания также стремится обеспечить гендерный баланс на фотографиях юристов и руководителей.

Но, по его словам, возможности его платформы ограничены. «Это как пытаться осушить океан. Мы пытались, но реальность такова, что если клиенты по всему миру хотят, чтобы их изображения выглядели определённым образом, никто ничего не может с этим поделать».

Изображение, созданное с помощью искусственного интеллекта в рамках кампании благотворительной организации Plan International 2023 года против детских браков, направленной на защиту «личной жизни и достоинства девочек». (Фото: Plan International)

Многие авторитетные организации, даже Организация Объединенных Наций, использовали изображения, созданные с помощью ИИ.

В прошлом году Организация Объединённых Наций опубликовала на YouTube видео с «реконструкцией» сексуального насилия, включая показания бурундийской женщины, которая рассказала, как в 1993 году её изнасиловали и бросили умирать трое мужчин. Контент был полностью создан искусственным интеллектом. Видео было удалено после того, как газета Guardian обратилась в ООН за интервью.

Представитель ООН позже объяснил, почему видео было удалено. «Мы считаем, что видео было некорректно сгенерировано искусственным интеллектом и может представлять угрозу целостности информации, поскольку реальные кадры смешиваются с искусственным контентом, выглядящим как настоящий».

Продукты, созданные с помощью ИИ, уже давно считаются подражателями, порой преувеличивающими реальность. Г-н Аленичев отметил, что распространение таких предвзятых изображений может усугубить проблему, поскольку они могут распространяться по всему интернету и использоваться для обучения следующего поколения ИИ.

Представитель Plan International заявил, что в настоящее время НПО «не рекомендует использовать ИИ для изображения детей».

Минь Хоан

Источник: https://vtcnews.vn/chuyen-gia-bao-dong-tinh-trang-ai-tao-anh-rap-khuon-phong-dai-ar972160.html

![[Фото] Председатель Национальной ассамблеи Чан Тхань Ман присутствует на церемонии вручения премии VinFuture 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

![[Фото] 60-я годовщина основания Вьетнамской ассоциации фотохудожников](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

Комментарий (0)