Исследователи из DeepSeek анонсировали новую экспериментальную модель под названием V3.2-exp, призванную значительно снизить стоимость вывода при использовании в длительных контекстных операциях.

DeepSeek анонсировал модель в посте на Hugging Face, а также разместил ссылку на научную статью на GitHub.

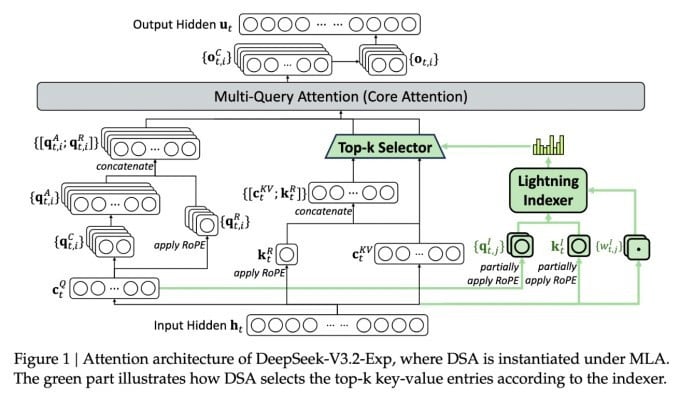

Важнейшая функция новой сложной модели называется DeepSeek Sparse Attention. По сути, система использует модуль, называемый «молниеносным индексатором», для приоритизации определённых фрагментов из контекстного окна.

DeepSeek анонсирует экономически эффективную модель вывода.

Отдельная система, называемая «системой точного выбора токенов», затем выбирает из этих фрагментов конкретные токены для загрузки в ограниченное окно внимания модуля. В совокупности они позволяют моделям разреженного внимания работать с длинными фрагментами контекста при относительно небольшой нагрузке на сервер.

Для операций с длинным контекстом преимущества системы существенны. Предварительное тестирование DeepSeek показывает, что стоимость вызова простой функции вывода (API) в сценариях с длинным контекстом может быть снижена до половины.

Для создания более надежной оценки необходимы дополнительные испытания, но поскольку модель открыта и находится в свободном доступе на Hugging Face, пройдет совсем немного времени, прежде чем сторонние тесты смогут оценить утверждения, изложенные в статье.

В отличие от других моделей чат-ботов на основе искусственного интеллекта, потребляющих много энергии, DeepSeek стремится сократить расходы на всех этапах — от обучения до эксплуатации.

Новая модель DeepSeek — одно из ряда недавних достижений, которые решают проблему стоимости вывода — по сути, стоимости сервера для запуска предварительно обученной модели ИИ по сравнению со стоимостью ее обучения.

В случае DeepSeek исследователи искали способы сделать базовую архитектуру трансформатора более эффективной и обнаружили, что необходимо внести значительные улучшения.

Базирующаяся в Китае компания DeepSeek — необычная фигура на рынке искусственного интеллекта, особенно для тех, кто рассматривает исследования в этой области как соревнование между США и Китаем. Ранее в этом году компания произвела фурор своей моделью R1, обученной преимущественно с помощью обучения с подкреплением, при значительно меньших затратах, чем у американских конкурентов.

Однако эта модель не смогла спровоцировать полномасштабную революцию в обучении ИИ, которую некоторые предсказывали, и в последующие месяцы компания постепенно сошла с ума.

Новый подход с «рассеянным вниманием» вряд ли вызовет такое же возмущение, как R1, но он все же может научить американских поставщиков услуг некоторым столь необходимым приемам, которые помогут снизить затраты на вывод.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Источник: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Фото] Премьер-министр Фам Минь Чинь и его жена встречаются с вьетнамской общиной в Алжире](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/19/1763510299099_1763510015166-jpg.webp)

![[Фото] Генеральный секретарь То Лам принимает заместителя премьер-министра Словакии и министра обороны Роберта Калинака](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/18/1763467091441_a1-bnd-8261-6981-jpg.webp)

Комментарий (0)