BGRによると、2024年は世界にとって、人工知能が本当にコンピューティングの未来なのか、それとも一時的な流行に過ぎないのかを見極める重要な年となるでしょう。AIの真の応用はますます多様化していますが、今後数ヶ月の間に、この技術のダークサイドも無数の詐欺によって明らかになるでしょう。

Scams.info の詐欺対策専門家が、2024 年に警戒すべき AI を利用した詐欺 3 種のリストを発表しました。魅力的すぎるものには注意するのが原則ですが、以下の詐欺には特に高い警戒が必要です。

AIベースの投資詐欺

Google、Microsoft、OpenAIといった大手企業はAIに数百万ドルを投入しており、今年も引き続き多額の投資を行う見込みです。詐欺師はこの事実につけ込み、怪しい投資機会にあなたを誘い込もうとします。ソーシャルメディアで、AIが投資収益を倍増させると説得してくる人がいたら、財布の紐を緩める前によく考えてください。

「お得な取引」や低リスクの投資は実際には存在しません。

「低リスクで高リターンを約束する投資には注意が必要です。投資する前に必ず徹底的な調査を行ってください」と、Scams.infoの専門家ニコラス・クラウチ氏は警告しています。また、新規投資家は、新規会員の紹介を求めるオファーにも注意が必要です。こうしたオファーは多くの場合、マルチレベルマーケティング(MLM)モデルに基づいており、上位の会員だけが利益を得て、他の参加者はほとんど利益を得られません。

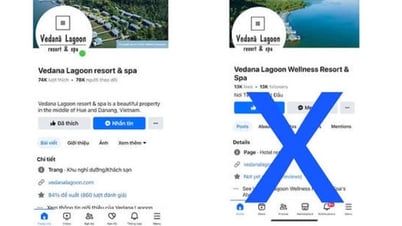

親戚になりすます

友人や親戚になりすまして金を借りる詐欺は、声真似では効果が薄いため、目新しいものではありません。しかし、AIの活用により、この種の詐欺ははるかに巧妙になります。親戚の声を収録したYouTube 動画やFacebookの投稿があれば、詐欺師はAIを使ってそれを完璧に再現できます。電話での会話で、その違いがわかるでしょうか?

AIはあなたの大切な人の声を簡単に真似ることができます。

ワシントンポストからのスクリーンショット

「詐欺師が音声録音や家族情報を収集するのを防ぐために、人々がソーシャルメディアのアカウントを保護することが非常に重要だ」とクラウチ氏は強調した。

音声コマンドを使用してセキュリティ システムをバイパスする。

一部の銀行は、電話での取引の際に音声認識を用いて本人確認を行っています。しかし、前述の理由により、この方法は以前よりも安全性が低下しています。自分の声を含む動画やクリップをインターネット上に投稿すると、悪意のある人物がそのコンテンツを利用してあなたの声を盗む可能性があります。クラウチ氏が指摘するように、銀行は顧客の身元確認に使用できる他のデータも保有していますが、この手法は犯罪者が銀行口座を盗むことに近づいています。

音声ベースのセキュリティ システムは、AI の力によってもはや安全ではなくなりました。

AIは私たちの生活やデバイスとの関わり方を根本的に変える可能性を秘めています。同時に、ハッカーや詐欺師がユーザーを攻撃するために利用する最新のツールでもあります。そのため、AIに関わるあらゆる活動に従事する前に、常に警戒を怠らず、徹底的な調査を行うことが重要です。

[広告2]

ソースリンク

![[ライブ] 2025年コミュニティアクションアワードガラ](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[画像] 2025年コミュニティアクションアワード授賞式を前に流出した画像。](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[動画] 40年間の改革を通じて国際統合と結びついた独立と自立](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/16/1765899635777_1-1-8054-png.webp)

コメント (0)