A GPU é o cérebro do computador com IA.

Em termos simples, a unidade de processamento gráfico (GPU) funciona como o cérebro do computador com inteligência artificial.

Como você deve saber, a unidade central de processamento (CPU) é o cérebro do computador. A vantagem de uma GPU é que ela é uma CPU especializada que pode realizar cálculos complexos. A maneira mais rápida de fazer isso é ter grupos de GPUs resolvendo o mesmo problema. No entanto, o treinamento de um modelo de IA ainda pode levar semanas ou até meses. Uma vez construído, ele é colocado em um sistema de computador front-end e os usuários podem fazer perguntas ao modelo de IA, um processo chamado inferência.

Um computador com inteligência artificial contendo múltiplas GPUs

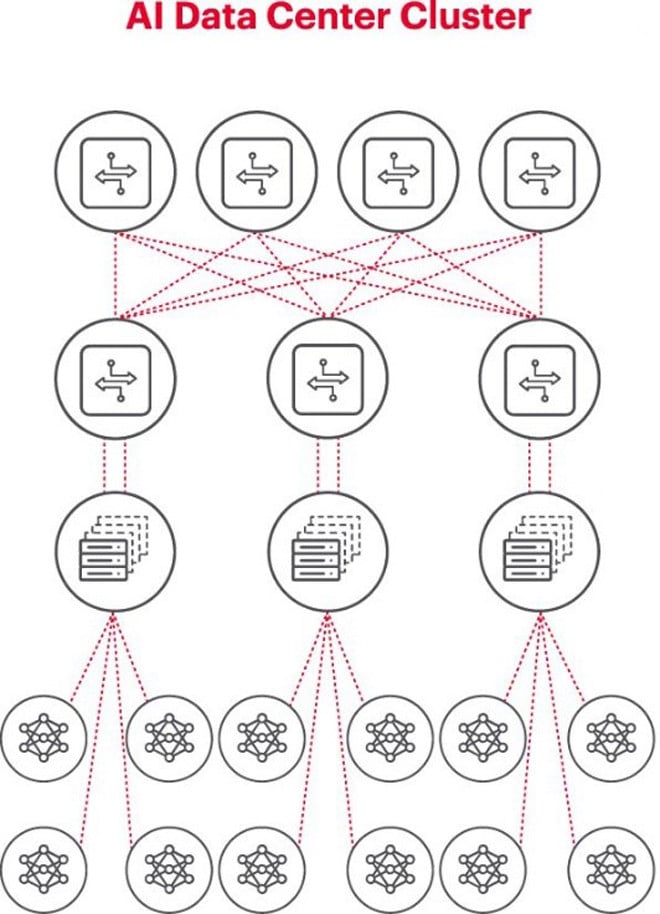

A melhor arquitetura para problemas de IA é usar um cluster de GPUs em um rack, conectado a um switch no topo do rack. Vários racks de GPUs podem ser conectados em uma hierarquia de rede. À medida que o problema se torna mais complexo, os requisitos de GPU aumentam e alguns projetos podem precisar implantar clusters com milhares de GPUs.

Cada cluster de IA é uma pequena rede.

Ao construir um cluster de IA, é necessário configurar uma pequena rede de computadores para conectar e permitir que as GPUs trabalhem juntas e compartilhem dados de forma eficiente.

A figura acima ilustra um cluster de IA onde os círculos na parte inferior representam os fluxos de trabalho executados em GPUs. As GPUs se conectam aos switches de topo de rack (ToR). Os switches ToR também se conectam aos switches de backbone da rede mostrados acima do diagrama, demonstrando a hierarquia de rede clara necessária quando várias GPUs estão envolvidas.

As redes representam um gargalo na implementação da IA.

No outono passado, na Cúpula Global do Open Computer Project (OCP), onde os participantes trabalhavam para construir a próxima geração de infraestrutura de IA, o participante Loi Nguyen, da Marvell Technology, fez uma observação fundamental: "o novo gargalo é a rede".

Tecnicamente, a alta latência ou perda de pacotes devido ao congestionamento da rede pode causar o reenvio de pacotes, aumentando significativamente o tempo de conclusão da tarefa (JCT). Como resultado, empresas desperdiçam milhões ou dezenas de milhões de dólares em GPUs devido a sistemas de IA ineficientes, o que resulta em perda de receita e tempo de lançamento no mercado.

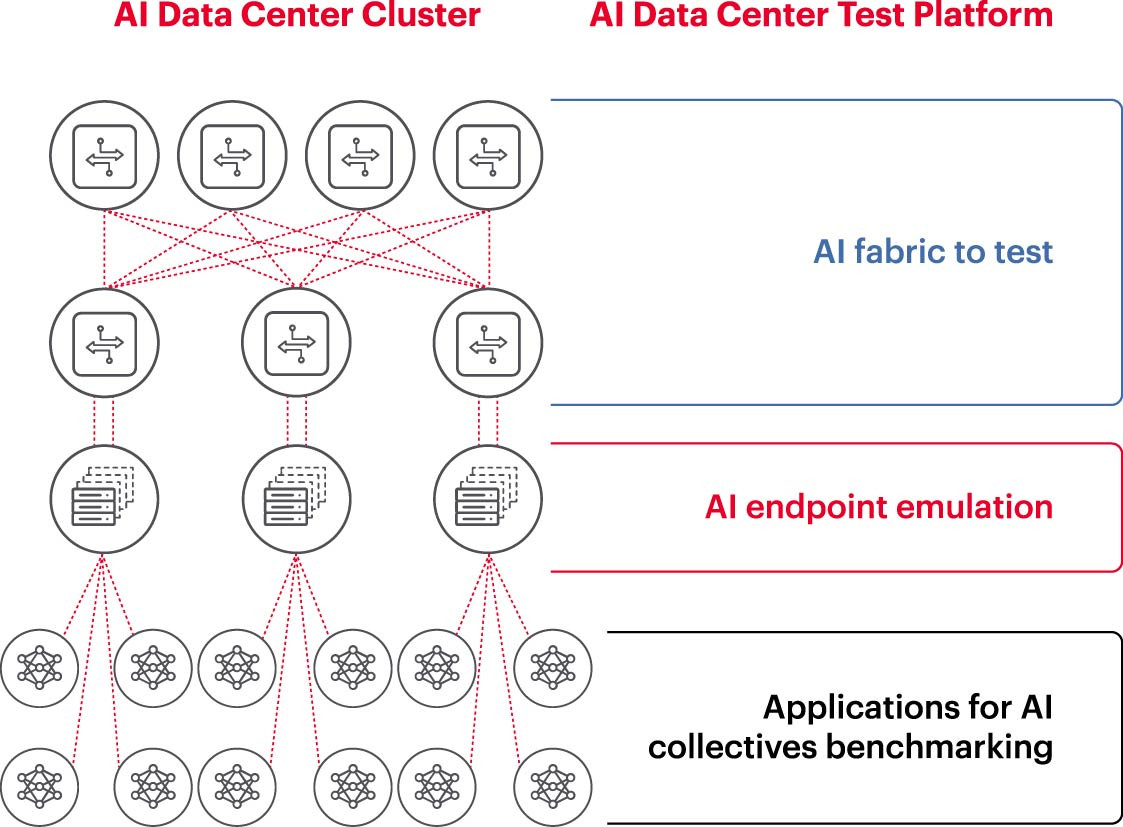

A medição é uma condição fundamental para o funcionamento bem-sucedido de redes de IA.

Para executar um cluster de IA de forma eficaz, as GPUs precisam ser totalmente utilizadas para reduzir o tempo de treinamento e colocar o modelo de aprendizado em prática, maximizando o retorno sobre o investimento. Portanto, é necessário testar e avaliar o desempenho do cluster de IA (Figura 2). No entanto, essa tarefa não é fácil, pois, em termos de arquitetura de sistema, existem muitas configurações e relações entre as GPUs e as estruturas de rede que precisam se complementar para resolver o problema.

Isso cria muitos desafios na medição de redes de IA:

- Dificuldade em reproduzir redes de produção inteiras em laboratório devido a limitações de custo, equipamento, escassez de engenheiros de IA de rede qualificados, espaço, energia e temperatura.

- A medição no sistema de produção reduz a capacidade de processamento disponível do próprio sistema de produção.

- Dificuldade em reproduzir os problemas com precisão devido às diferenças de escala e escopo dos mesmos.

- A complexidade de como as GPUs estão conectadas coletivamente.

Para lidar com esses desafios, as empresas podem testar um subconjunto das configurações recomendadas em um ambiente de laboratório para avaliar métricas importantes, como o tempo de conclusão de tarefas (JCT), a largura de banda que a equipe de IA pode alcançar e compará-la com a utilização da plataforma de comutação e a utilização do cache. Essa avaliação comparativa ajuda a encontrar o equilíbrio certo entre a carga de trabalho da GPU/processamento e o projeto/configuração da rede. Uma vez satisfeitos com os resultados, os arquitetos de computadores e engenheiros de rede podem levar essas configurações para produção e medir novos resultados.

Laboratórios de pesquisa corporativos, instituições acadêmicas e universidades estão trabalhando para analisar todos os aspectos da construção e operação de redes de IA eficazes, visando enfrentar os desafios de trabalhar com grandes redes, especialmente à medida que as melhores práticas continuam a evoluir. Essa abordagem colaborativa e repetível é a única maneira de as empresas realizarem medições consistentes e testarem rapidamente cenários hipotéticos, que são a base para a otimização de redes para IA.

(Fonte: Keysight Technologies)

Fonte: https://vietnamnet.vn/ket-noi-mang-ai-5-dieu-can-biet-2321288.html

Comentário (0)