Департамент інформаційної безпеки нещодавно опублікував попередження щодо продовження шахрайства з високотехнологічним відео та зображенням.

Відповідно, влада широко попередила велику кількість людей про ситуацію, коли кіберзлочинці використовують публічні зображення та відео людей для редагування, обрізання та погроз шантажу за допомогою фальшивих відео.

Використовуючи технологію Deepfake, яка дозволяє відтворювати звук і зображення людини з високою точністю, злочинці можуть видавати себе за лідерів на онлайн-зустрічах або створювати відео та дзвінки для скоєння фінансового шахрайства.

Крім того, ці шахрайства часто використовують психологічні фактори, такі як терміновість, страх або влада, що змушує жертв діяти поспішно, не перевіряючи ретельно справжність.

Діпфейки не обмежуються шахрайством, пов'язаним з фінансовими інвестиціями. Іншим прикладом є романтичні афери, де діпфейки використовуються для створення вигаданих персонажів, які взаємодіють з жертвами через відеодзвінки; після завоювання довіри жертви шахрай просить грошові перекази для вирішення надзвичайних ситуацій, дорожніх витрат або позик.

З огляду на вищезазначену ситуацію, Департамент інформаційної безпеки рекомендує людям бути обережними з інвестиційними порадами від знаменитостей у соціальних мережах; бути обережними з невідомими повідомленнями, електронними листами чи дзвінками; та уважно спостерігати за неприродними виразами обличчя на відео.

Людям також потрібно обмежити публікацію контенту, пов’язаного з особистою інформацією, в соціальних мережах, щоб уникнути крадіжки такої інформації, як зображення, відео чи голоси, зловмисниками; водночас, налаштувати облікові записи в приватний режим для захисту особистої інформації.

У розмові з журналістами газети Dai Doan Ket експерт з кібербезпеки Нго Мінь Х'єу, співзасновник В'єтнамського проекту з запобігання кібершахрайству (Chongluadao.vn), заявив, що використання технології Deepfake у штучному інтелекті для фальсифікації відеодзвінків з метою шахрайства все ще залишається складним. Суб'єкти використовують цю технологію, щоб підвищити довіру до своєї "здобичі".

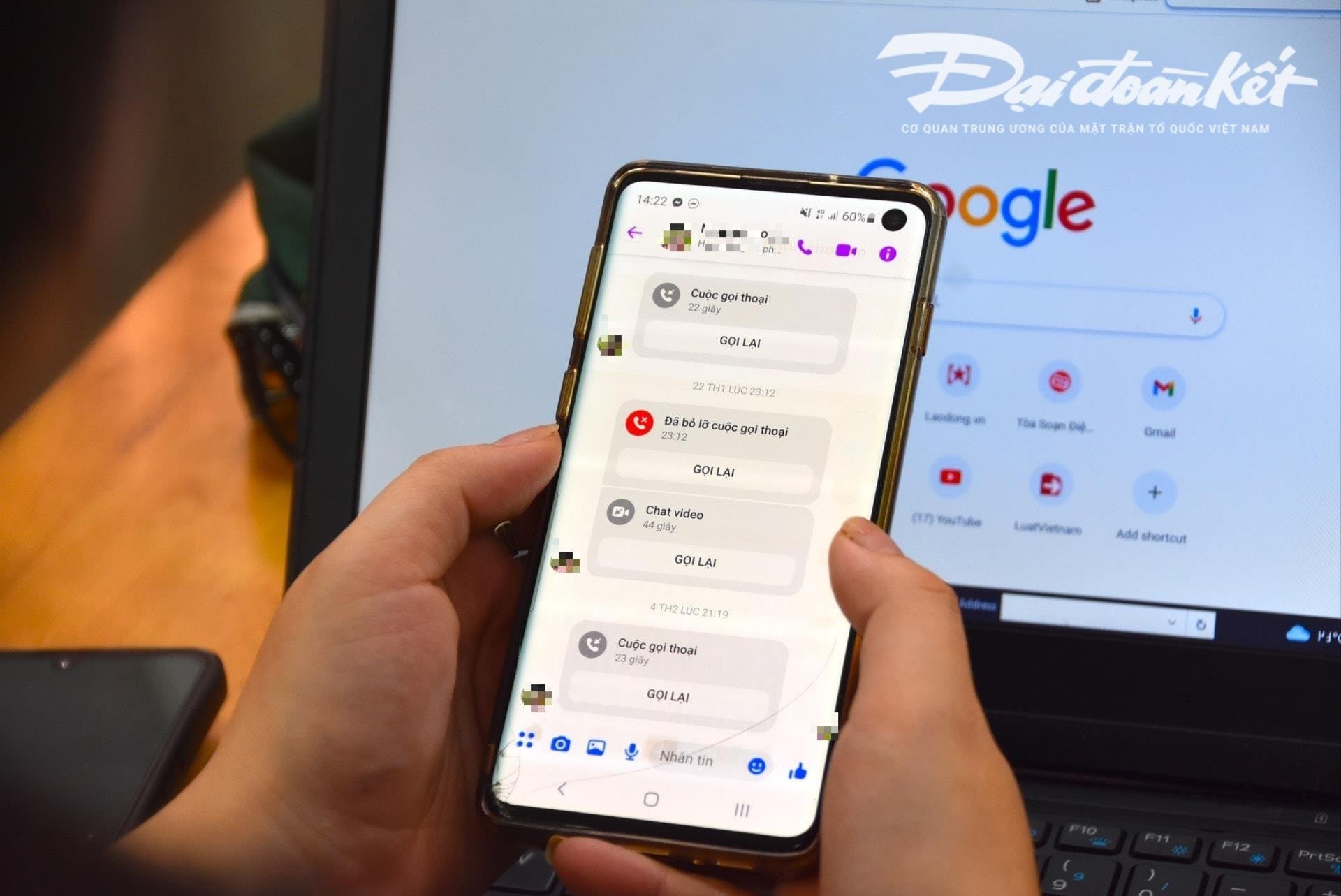

Зокрема, суб'єкти проактивно здійснюватимуть відеодзвінки жертвам за допомогою раніше «вкрадених» зображень та відео, а також маніпулюватимуть технікою, спотворюючи звук або створюючи імітацію зображень, щоб завоювати довіру жертви.

Зазвичай ці дзвінки дуже короткі, тривають лише кілька секунд, потім вони використовують виправдання нестабільної мережі, перебування на вулиці тощо, щоб попросити жертву виконати прохання шахрая.

Експерти попереджають, що використання штучного інтелекту для кібершахрайства, ймовірно, значно зросте найближчим часом. Тому людям слід проактивно підвищувати свою пильність, особливо під час отримання дивних повідомлень, відеодзвінків та посилань.

Згідно з аналізом цього експерта, поточний алгоритм штучного інтелекту (ШІ) Deepfake під час дзвінків у реальному часі не зможе впоратися, якщо абонент повернеться ліворуч, праворуч або встане...

Однією з особливих слабкостей, на яку людям слід звернути увагу, отримуючи такі дзвінки, є зуби. Відповідно, сучасні алгоритми штучного інтелекту не можуть відтворити зуби людини, яку видають за людину.

Якщо використовується Deepfake, зображення людини, яка відкриває рот, може не мати зубів, деякі люди можуть мати 3 або навіть 4 щелепи. Тому характеристики зубів є найбільш впізнаваним елементом фальшивого дзвінка за допомогою Deepfake.

«Уповільнення» та негайне виконання запиту є обов’язковою умовою, щоб уникнути потрапляння в пастку шахраїв. Отримуючи будь-яке повідомлення чи дзвінок через соціальні мережі, людям потрібно зателефонувати безпосередньо своїм родичам, щоб точно перевірити, хто з ними зв’язується, з мінімальним часом спілкування більше 30 секунд або зустрітися особисто.

У разі підозри у видаванні себе за родичів у соціальних мережах з метою шахрайства або привласнення майна, необхідно негайно повідомити найближчий відділ поліції для своєчасної підтримки та вирішення проблеми.

Джерело: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[Фото] Кат Ба - Зелений острівний рай](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[Відео] Цифрова система для управління науково-технічними завданнями](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764810148741_1764673678503-jpg.webp)

![[VIMC 40 днів блискавичної швидкості] Порт Хайфон налаштований прорватися, досягнувши цільового показника в 2 мільйони TEU до 2025 року](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764816441820_chp_4-12-25.jpeg)

Коментар (0)