Le département de la sécurité de l'information a récemment émis un avertissement concernant la récurrence persistante des fraudes de haute technologie utilisant des vidéos et des images.

En conséquence, les autorités ont largement mis en garde un grand nombre de personnes contre le risque que des cybercriminels exploitent des images et des vidéos publiques de personnes pour les modifier, les couper et les utiliser pour proférer des menaces de chantage à l'aide de fausses vidéos.

En utilisant la technologie Deepfake qui permet de reproduire avec une grande précision le son et l'image d'une personne, des criminels peuvent usurper l'identité de dirigeants lors de réunions en ligne, ou créer des vidéos et des appels pour commettre des fraudes financières.

De plus, ces arnaques exploitent souvent des facteurs psychologiques tels que l'urgence, la peur ou le pouvoir, poussant les victimes à agir précipitamment sans vérifier soigneusement l'authenticité.

Les deepfakes ne se limitent pas aux arnaques financières. On peut également citer les arnaques sentimentales, où des deepfakes servent à créer des personnages fictifs qui interagissent avec les victimes par appels vidéo. Après avoir gagné la confiance de la victime, l'escroc demande des transferts d'argent pour faire face à des urgences, des frais de voyage ou des prêts.

Au vu de la situation décrite ci-dessus, le Département de la sécurité de l'information recommande de se méfier des conseils d'investissement donnés par des célébrités sur les réseaux sociaux ; de se méfier des messages, courriels ou appels provenant de sources inconnues ; et d'observer attentivement les expressions faciales anormales dans les vidéos.

Il est également nécessaire de limiter la publication de contenu à caractère personnel sur les réseaux sociaux afin d'éviter que des informations telles que des images, des vidéos ou des enregistrements vocaux ne soient volées par des personnes mal intentionnées ; parallèlement, il est conseillé de paramétrer ses comptes en mode privé afin de protéger ses informations personnelles.

S'adressant aux journalistes du quotidien Dai Doan Ket, Ngo Minh Hieu, expert en cybersécurité et cofondateur du Projet vietnamien de prévention de la cyberfraude (Chongluadao.vn), a déclaré que l'utilisation de la technologie Deepfake, basée sur l'intelligence artificielle, pour falsifier des appels vidéo à des fins frauduleuses reste complexe. Les individus mal intentionnés exploitent cette technologie pour renforcer la crédibilité de leurs victimes.

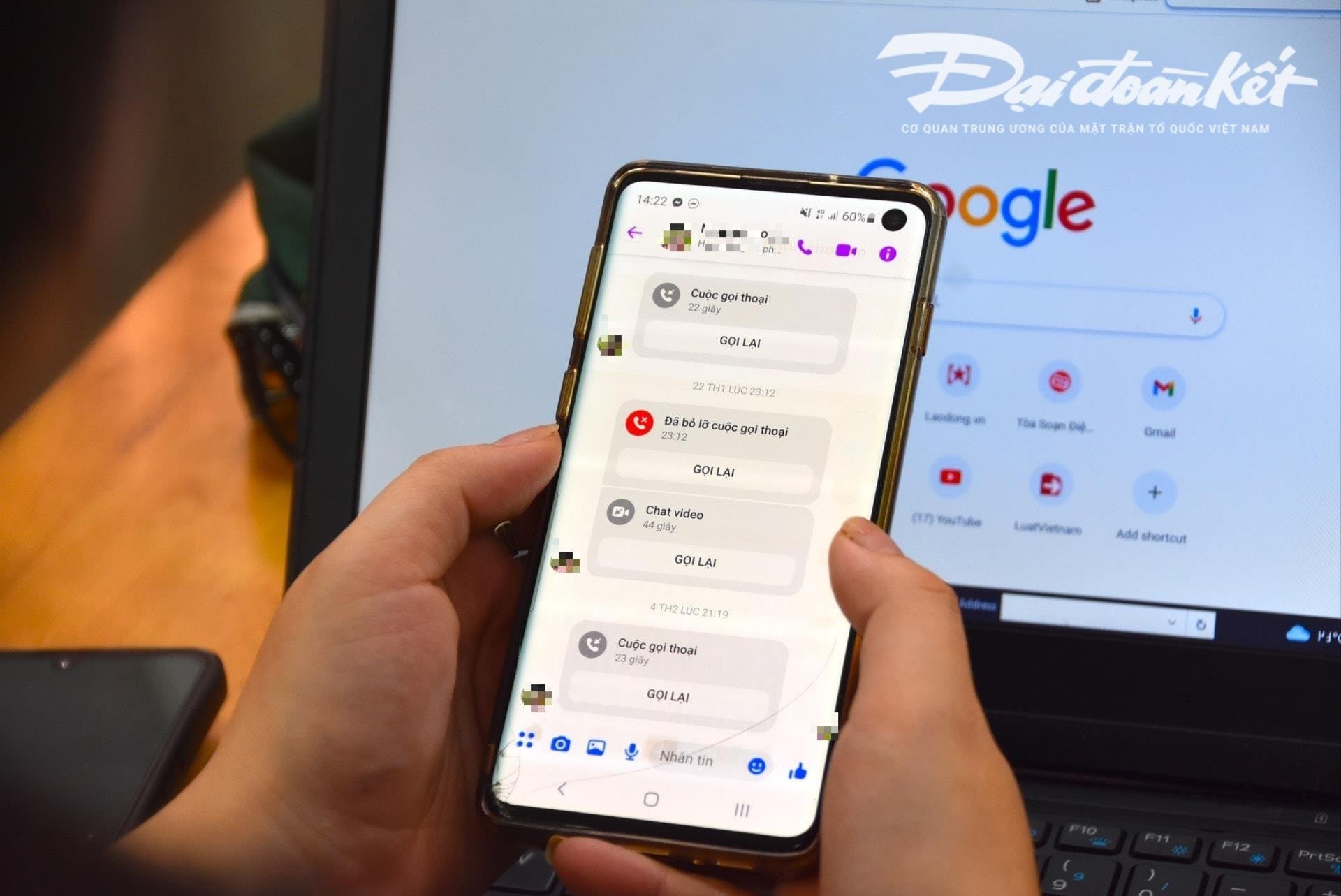

Plus précisément, les individus passeront des appels vidéo à leurs victimes à partir d'images et de vidéos préalablement « volées », et manipuleront la technique, en déformant le son ou en simulant des problèmes d'image pour gagner la confiance de la victime.

Généralement, ces appels sont très courts, ne durant que quelques secondes, puis ils utilisent le prétexte d'un réseau instable, d'être dans la rue, etc., pour demander à la victime de satisfaire les demandes de l'escroc.

Les experts préviennent que l'utilisation de l'IA à des fins de cyberfraude devrait augmenter considérablement dans un avenir proche. Il est donc essentiel que chacun redouble de vigilance, notamment face à des messages, appels vidéo ou liens suspects.

Selon l'analyse de cet expert, l'algorithme d'intelligence artificielle (IA) Deepfake actuel ne pourra pas gérer les mouvements de l'appelant lors d'appels en temps réel, notamment s'il se tourne à gauche, à droite ou s'il se lève...

L'un des points faibles auxquels il faut prêter attention lorsqu'on reçoit ce type d'appel est la dentition. Or, les algorithmes d'IA actuels ne peuvent pas reproduire les dents de la personne dont l'identité est usurpée.

Lorsqu'on utilise la technologie Deepfake, l'image d'une personne ouvrant la bouche peut ne montrer aucune dent, certaines personnes pouvant avoir trois ou même quatre mâchoires. Par conséquent, les caractéristiques des dents constituent l'élément le plus reconnaissable d'un appel falsifié à l'aide de Deepfake.

Prendre son temps et ne pas répondre immédiatement à une demande est essentiel pour éviter de tomber dans le piège d'une arnaque. Lorsqu'on reçoit un message ou un appel via les réseaux sociaux, il est important de contacter directement ses proches pour vérifier l'identité de l'appelant, au moins 30 secondes après l'appel, ou de le rencontrer en personne.

En cas de suspicion d'usurpation d'identité de proches sur les réseaux sociaux à des fins frauduleuses ou d'appropriation de biens, il est nécessaire de le signaler immédiatement au poste de police le plus proche afin d'obtenir une assistance et une prise en charge rapides.

Source : https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[Photo] Cat Ba - Île paradisiaque verte](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[Vidéo] Système numérique de gestion des tâches scientifiques et technologiques](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764810148741_1764673678503-jpg.webp)

![[VIMC 40 jours à une vitesse fulgurante] Le port de Hai Phong déterminé à percer et à atteindre son objectif de 2 millions d'EVP d'ici 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764816441820_chp_4-12-25.jpeg)

![[Série de photos] Panorama de l'aéroport de Long Thanh avant son inauguration](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764822152985_anh_8_20251204103350_20251204110421.jpeg)

Comment (0)