|

薬剤師のティエン氏(ファム・ミン・ヒュー・ティエン)は、「ChatDST」というAIを立ち上げました。写真: DST 。 |

7月14日、薬剤師のティエン氏はソーシャルメディアに同社の様々な製品を紹介する動画を投稿しました。その中でも、「ChatDST」というAIチャットボットは、「ChatGPTよりも優れている」というプレゼンターの発言で注目を集めました。

この情報は物議を醸しています。ティエン氏と彼を率いる組織は化粧品とエンターテインメント業界で働いており、テクノロジーの専門知識を持っていないからです。一方、数千億ドルの投資と長年の開発を経て誕生したOpenAIのChatGPTは、依然として多くの面で市場をリードする製品です。

薬剤師ティエンの声明

「Tienのほぼすべてのパラメータは、現在使用されている人工知能を上回っています。Tienは、このパラメータが市場で非常に高いことをお見せします」と、ファム・ミン・フー・ティエン(薬剤師ティエン)は発表会で宣言しました。

|

薬剤師ティエン氏によるChatDSTチャットボットのパラメータの説明。写真:ファム・ミン・フー・ティエン氏 |

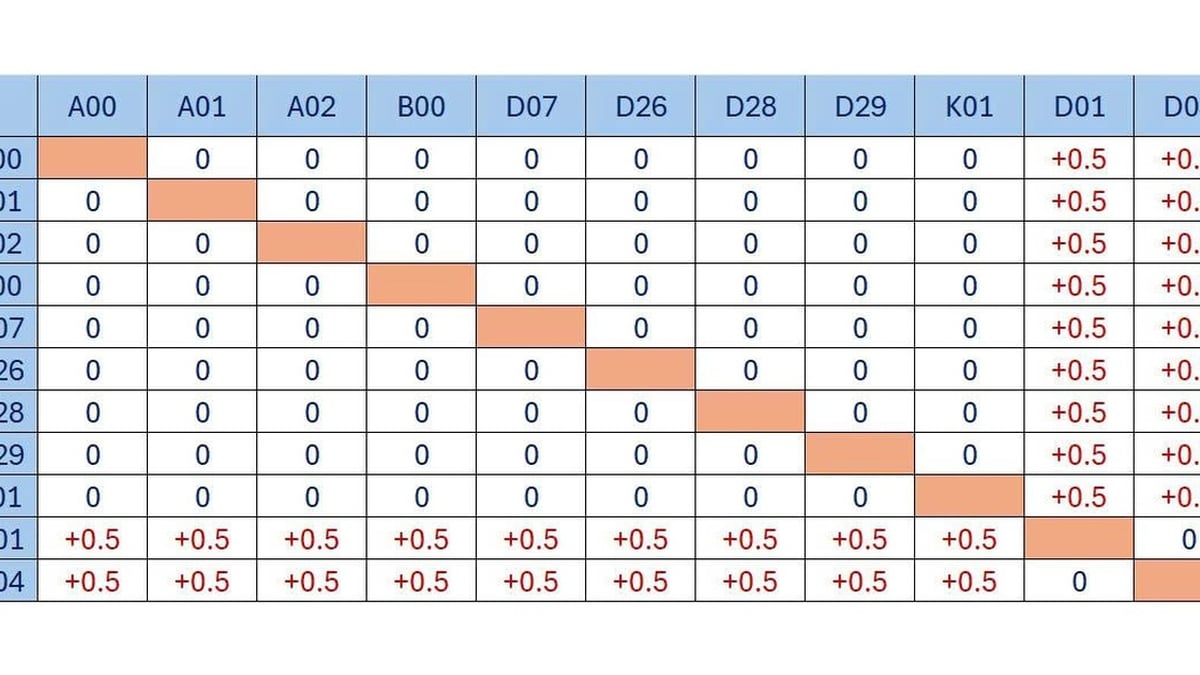

この人物が比較対象として挙げたのはVRAM容量だ。ファム・ミン・フー・ティエン氏は、彼らが構築したシステムはChatGPTの2倍のメモリ(480GBに対して960GB)を搭載していると主張した。「さらに、化学・化粧品業界のデータには個人の特性も読み込まれており、この分野で働く人々にとって非常に役立つでしょう」とティエン氏は述べた。

さらに、プレゼンテーション画面のパラメータを見ると、このプラットフォームは毎秒2,000トークンを生成できることが分かります。このアーキテクチャは6つのAIモデルを組み合わせることでパフォーマンスを向上させています。ChatDSTは、最大100万トークンのコンテキストを処理し、99.95%の安定した動作を約束しています。

特に、紹介者は、このチャットボットはセッションごとに無制限のメモリを備えていると述べました。薬剤師のTien氏は、このソリューションは10月にリリースされ、ユーザーは20~300米ドルで利用できると発表しました。しかし、リリースイベントの動画は現在YouTubeから削除されています。

異常なパラメータ

Pharmacist Tien氏が発表したプロジェクトは現時点ではまだ「紙の上」であり、試用版やソースコード、動作に関する詳細なレポートは公開されていません。現時点での情報には、基本的なパラメータと、ChatDSTがChatGPTよりも高度な設定を備えており、市場最高峰のツールの一つであるという記述のみが記載されています。

しかし、この情報も曖昧で、大部分が非論理的で不可能です。

情報技術修士、AI製品開発者のNB氏は、 Tri Thuc - ZNewsとのインタビューで、薬剤師Tien氏の発言には一部誤った情報が含まれていると語った。

|

OpenAIの400億ドル規模のAI工場が米国テキサス州で建設中。写真: Data Center Dynamic。 |

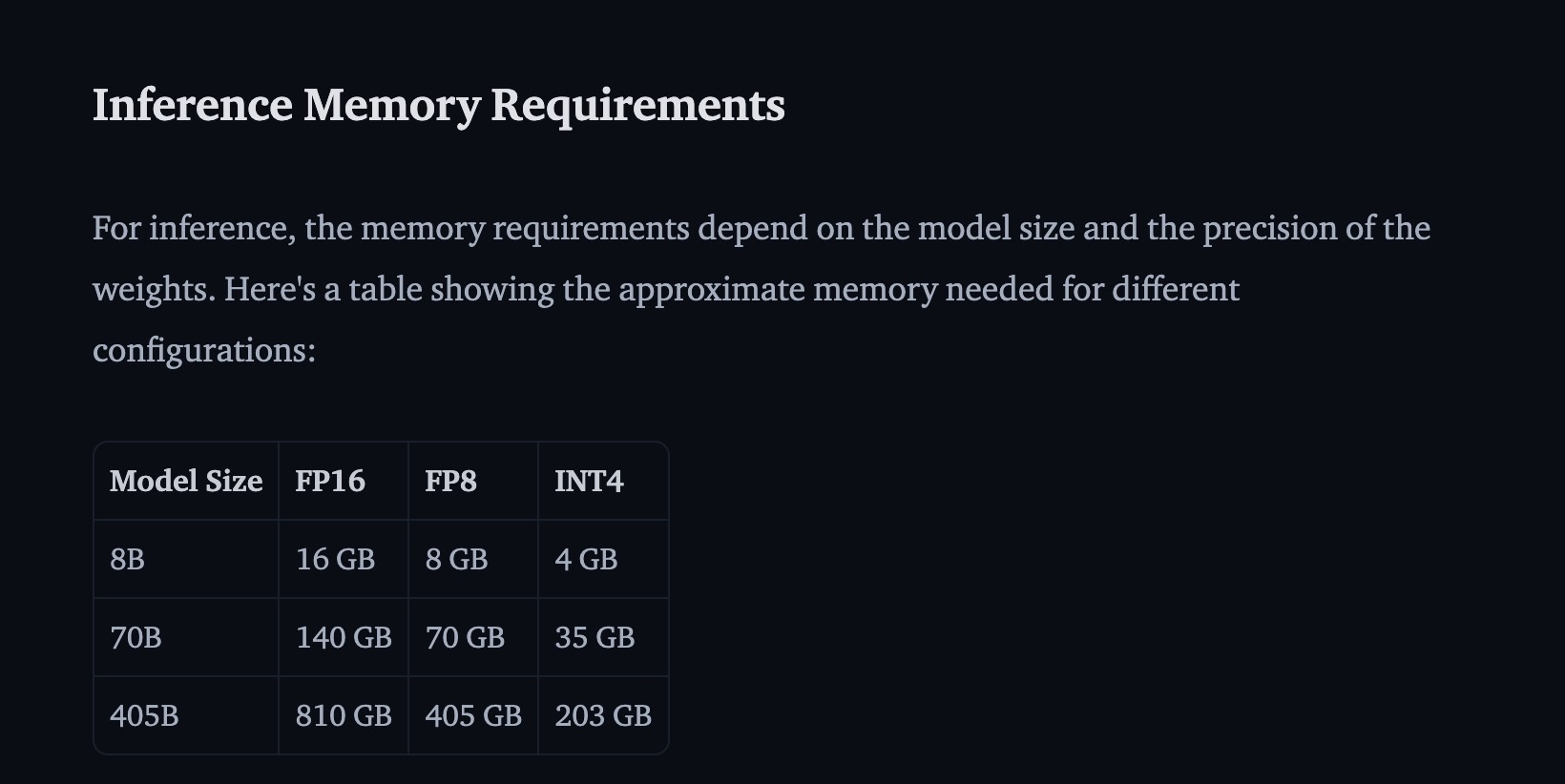

例えば、Tien氏はChatDSTが4030億個の「ニューロン」を搭載したLlamaプラットフォーム上で開発されたと述べました。実際、大規模言語モデルでは「ニューロン」ではなくパラメータを用いてデータドメインについて語ります。一方、Llamaはオープンソースコードを公開しているMetaによって開発され、4030億個のパラメータを持つバージョンではなく、4050億個のパラメータを持つバージョンしかありませんでした。

一方、ファム・ミン・フー・ティエン氏が発表したように、OpenAIが480GBのメモリを搭載したサーバーを使用していることを示す情報源は存在しません。ティエン氏が示したパラメータによると、ChatDSTは12基のNvidia A100 80GB GPUと合計960GBのVRAMを搭載したプラットフォームで動作します。これらのグラフィックカードの市場価格は1枚あたり約7億ドンで、このコンポーネントに84億ドンの投資が相当します。

一方、 The Informationの情報筋によると、OpenAIは約35万枚のA100カードを推論用に備えたデータセンターを所有しているという。ChatGPTだけでも29万台のGPUを使用しており、これはPharmacist Tienが発表した構成の24,167倍に相当する。さらに同社は、ユーザー数増加時の負荷軽減のため、MicrosoftのAzureサーバーもレンタルしている。

OpenAIは1日あたり約10万米ドル( 26億ドン)の運用費用を負担する必要があると推定されています。つまり、同社の4日間の運用コストは、薬剤師TienがChatDSTで使用した12個のA100チップの構成費用を上回ります。

|

Llama 405Bは、動作モデルを収容するために少なくとも810GBのVRAMを占有します。写真: HuggingFace。 |

HuggingFaceによると、Llama 4050億個のパラメータを保存するには少なくとも810GBのメモリが必要です。そのため、Tien氏のサーバーには、ユーザーがチャットする際に計算処理に使用できる空き容量が150GBしかありません。このVRAM容量は、1~3人のユーザーが同時にチャットするのに十分な量です。リソースを節約するためにモデルの精度を下げたとしても、同時に3~9アカウントを処理するユーザー数は十分です。

ChatDSTの処理速度である2,000トークン/秒も、業界では「想像を絶する」数値です。現在、ChatGPTはモデルによって50~100トークン/秒しか生成できず、システムに過負荷をかけています。Claudeも同様に40~80トークン/秒しか達成していません。

出典: https://znews.vn/ai-cua-duoc-si-tien-co-thuc-su-hon-chatgpt-post1569417.html

![[インフォグラフィック] 2025年には47の製品が国家OCOPを達成する](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/5d672398b0744db3ab920e05db8e5b7d)

コメント (0)