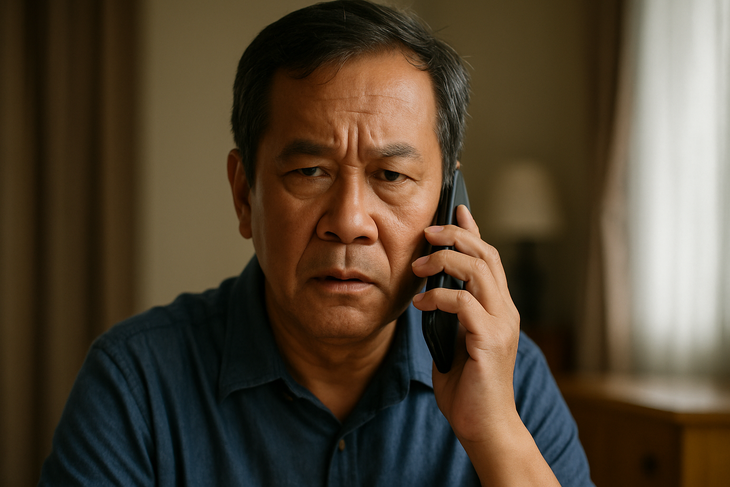

ディープフェイク音声で声を偽装する詐欺

急速に発展する人工知能(AI)の時代において、かつては信頼できる証拠と考えられていた音声は、今や犯罪者の手に渡り、危険なツールとなっています。ディープフェイク音声技術は、実在の人間とほとんど区別がつかない音声を作り出すことを可能にし、詐欺や資産窃盗を目的とした巧妙な詐欺電話を可能にしています。

ディープフェイクの音声はなぜ怖いのでしょうか?

ディープフェイク音声は、人工知能(AI)と機械学習を応用して、実際の人の声とまったく同じ偽の音声を作成する技術です。

Tacotron、WaveNet、ElevenLabs などの最新モデルや、Reppeecher などの音声クローン作成プラットフォームの助けを借りれば、犯罪者は 3 ~ 10 秒の音声サンプルだけで、95% 信憑性のあるディープフェイクを作成できます。

ディープフェイク音声は、発音、イントネーションから各人の独特の話し方まで、ほぼ完璧に音声を模倣できるため、特に危険です。

これにより、被害者にとって、特にその声が親戚や友人、上司のものである場合、本物と偽物を見分けることが非常に困難になります。

音声マイニングも非常に簡単です。今日では、ほとんどの人がTikTokなどのプラットフォーム、ソーシャルメディアのライブ配信、ポッドキャスト、オンライン会議などを通じて音声を公開しているからです。さらに懸念されるのは、ディープフェイクの音声は画像や動画のような視覚的な痕跡を残さないため、捜査が困難になり、被害者は金銭的損失を被るリスクが高まることです。

わずか数秒の音声サンプルでディープフェイクを作成できる

ディープフェイク音声詐欺はますます巧妙化しており、緊急事態で知人になりすましてパニックを起こさせ、被害者にすぐに送金するよう圧力をかけるという、おなじみの手法が使われることが多くなっています。

ベトナムでは、母親が「息子」から事故に遭い、緊急にお金が必要だという電話を受けたという事件がありました。英国では、ある会社の取締役が「上司」から電話で送金を依頼され、24万ドル以上を騙し取られました。また、ある事務職員が「大物」から「戦略的パートナー」への支払いを要求される電話を受け、詐欺に遭いました。

こうした状況に共通するのは、偽の声が親戚や目上の人そっくりに再現され、被害者は絶対的に信じてしまい、確認する時間がないという点です。

常に検証し、すぐに信頼しない

ディープフェイク音声詐欺の増加を踏まえ、たとえ声が親戚とそっくりだとしても、音声通話のみを頼りに送金することは避けるべきです。取引を行う前に、元の番号に折り返し電話をかけるか、複数のチャネルで情報を確認するようにしてください。

多くの専門家は、異常な状況での検証のために、自宅や職場内に「内部パスワード」を設定することも推奨しています。

さらに、音声が明瞭な動画、特に長時間の動画のソーシャルメディアへのアップロードを制限する必要があります。特に、高齢者やテクノロジーへのアクセスが限られている人々といった脆弱な立場にある人々は、ハイテク詐欺の格好の標的となるため、積極的な警告と指導を提供する必要があります。

親戚、友人、同僚の声はすべて偽造可能です。

多くの国では、当局が独自の法的枠組みでディープフェイク技術の管理を強化し始めている。

米国では、複数の州が選挙運動や偽情報の拡散におけるディープフェイクの使用を禁止しました。欧州連合(EU)はAI法を可決し、コンテンツが人工知能(AI)によって生成された場合、組織に透明性と明確な警告を義務付けました。

一方、ベトナムではディープフェイク音声に関する具体的な規制はないものの、関連行為は詐欺、財産横領、プライバシー侵害、身元偽造などの犯罪として現行法に則って取り扱われる可能性がある。

しかし、現実には、技術は法律の監視能力をはるかに超えるペースで発展しており、悪意のある者が悪用できる抜け穴が数多く残されています。

声が証拠ではなくなったとき

かつて声は親密で信頼できるものでしたが、ディープフェイク音声の登場により、もはや有効な証拠ではなくなりました。AI時代においては、一人ひとりがデジタル防御の知識を持ち、積極的に検証し、常に警戒を怠らないようにする必要があります。なぜなら、通話は罠となる可能性があるからです。

出典: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

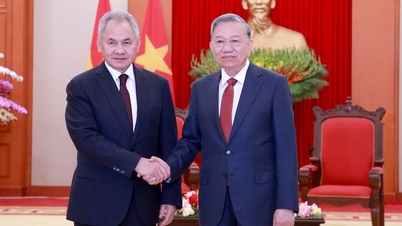

![[写真] ト・ラム書記長が第14回党大会小委員会常務委員会と活動中](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/09/1765265023554_image.jpeg)

コメント (0)